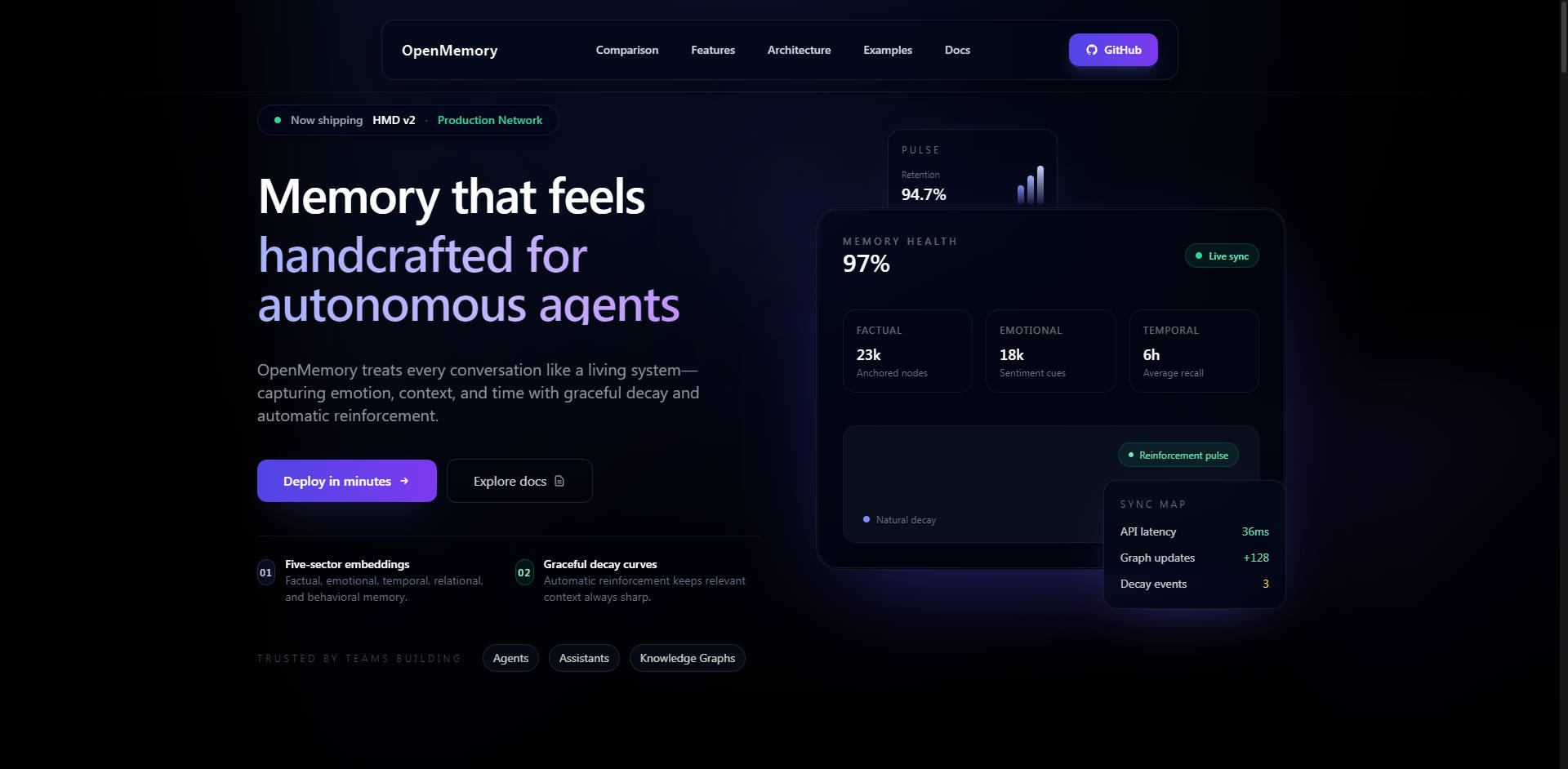

What is OpenMemory?

OpenMemory es un motor de memoria de IA modular y autoalojado, diseñado para resolver el problema crítico de las ventanas de contexto limitadas de los LLM. Ofrece una memoria a largo plazo persistente, estructurada y semántica, lo que permite a los agentes de IA, asistentes y copilotos empresariales recordar de forma segura datos complejos de usuarios, preferencias e interacciones previas a lo largo de diversas sesiones y tareas. Diseñado para desarrolladores y organizaciones que priorizan el control, el rendimiento y la transparencia, OpenMemory garantiza que sus aplicaciones de IA retengan el contexto de manera eficiente y privada.

Características Clave

OpenMemory ofrece una verdadera memoria a largo plazo a través de un modelo cognitivo especializado, yendo más allá del simple almacenamiento vectorial para proporcionar una recuperación de contexto matizada y explicable.

🧠 Arquitectura de Descomposición de Memoria Jerárquica (HMD)

HMD es la innovación central que distingue a OpenMemory de las bases de datos vectoriales tradicionales o de las capas de memoria simples. En lugar de almacenar todo el contexto de forma uniforme, HMD descompone los recuerdos en embeddings multisectoriales (episódicos, semánticos, procedimentales, reflexivos, emocionales). Esta arquitectura de inspiración biológica utiliza un grafo de enlaces escaso y de un solo punto de ruta para garantizar un nodo canónico por recuerdo, reduciendo drásticamente la duplicación de datos y mejorando la precisión de la recuperación. Esta estructura es clave para lograr una menor latencia y rutas de razonamiento explicables.

🔒 Seguridad Autoalojada y Propiedad de los Datos

Por diseño, OpenMemory es autoalojado y se puede implementar localmente, a través de Docker o en su entorno de nube privada. Esta arquitectura garantiza una propiedad del 100% de los datos y su privacidad, eliminando la exposición de datos a proveedores inherente a las API de memoria alojadas. Las características de seguridad incluyen autenticación Bearer para las API de escritura, funciones de depuración y anonimización de PII, cifrado de contenido AES-GCM opcional y un sólido aislamiento de inquilinos para implementaciones multiusuario.

💻 Extensión de VS Code para la Persistencia del Copiloto

La extensión dedicada de VS Code dota a los asistentes de IA de una memoria persistente a lo largo de sesiones de codificación complejas. Esta extensión ofrece integración de configuración cero, rastreando automáticamente cada edición, guardado y apertura de archivos. Fundamentalmente, utiliza Smart Compression para reducir inteligentemente el uso de tokens entre un 30% y un 70%, asegurando una entrega de contexto rentable y proporcionando respuestas a consultas en menos de 80 ms mediante un caché inteligente.

🔗 Integración Profunda con LangGraph y MCP

OpenMemory está diseñado para la orquestación moderna de IA. Incorpora un Modo de Integración LangGraph (LGM) dedicado, que proporciona puntos finales REST especializados para mapear automáticamente las salidas de nodos (por ejemplo,observe, plan, reflect) al almacenamiento HMD multisectorial apropiado. Además, el Servidor HTTP del Protocolo de Contexto de Modelo (MCP) integrado permite a los agentes compatibles con MCP (como Claude Desktop y los SDK personalizados) conectarse inmediatamente sin necesidad de instalar un SDK, mejorando la interoperabilidad independiente del framework.

Casos de Uso

OpenMemory está diseñado para escenarios que exigen alta fidelidad de contexto, seguridad y retención a largo plazo.

1. Desarrollo de Copilotos Empresariales

Implemente OpenMemory dentro de su red corporativa segura para impulsar copilotos de nivel empresarial. Esto asegura que todos los datos propietarios, procedimientos operativos y preferencias de los empleados se recuerden de forma segura y privada. Las capacidades de depuración de PII y aislamiento de inquilinos permiten una implementación multiusuario que cumple con las normativas, donde la integridad y el control de los datos no son negociables.

2. Memoria de Agente a Largo Plazo y Personalización

Desarrolle agentes de IA que realmente evolucionen y aprendan con el tiempo. Al utilizar la arquitectura HMD, los agentes pueden recuperar recuerdos basándose no solo en la similitud semántica, sino también en el historial procedimental o en percepciones reflexivas. Esto permite al agente recordar acciones pasadas específicas, comprender hábitos complejos de los usuarios y proporcionar asistencia altamente personalizada y contextualmente relevante durante semanas o meses.

3. Persistencia Mejorada del Flujo de Trabajo del Desarrollador

La extensión OpenMemory VS Code permite a los equipos de desarrollo que utilizan asistentes de IA (como GitHub Copilot o Cursor) mantener una memoria persistente a través de reinicios, ramas de código y proyectos de larga duración. El asistente no solo recuerda el archivo actual; recuerda el contexto de todo el historial del proyecto, las decisiones arquitectónicas tomadas la semana pasada y los pasos específicos de depuración realizados ayer, reduciendo significativamente la repetición redundante de contexto y mejorando la eficiencia.

¿Por Qué Elegir OpenMemory? Ventajas Únicas

OpenMemory está diseñado para superar a las soluciones de memoria tradicionales en métricas clave: velocidad, costo y transparencia funcional.

| Ventaja | Beneficio | Diferenciador de Rendimiento |

|---|---|---|

| Rendimiento y Costo Superiores | Logre una mayor precisión contextual y una recuperación más rápida, al tiempo que reduce drásticamente los costos operativos. | Recuperación contextual 2–3 veces más rápida y costo 6–10 veces menor en comparación con las “API de memoria” alojadas. (por ejemplo, 2.5 veces más rápido y 10–15 veces más barato que Zep a la misma escala). |

| Recuerdo Explicable | Comprenda con precisión por qué se recuperó una parte del contexto, garantizando la transparencia y la confianza en el razonamiento de la IA. | El modelo cognitivo multisectorial permite rutas de recuerdo explicables basadas en tipos de memoria específicos (episódica, semántica, etc.). |

| Verdadera Apertura y Flexibilidad | Utilice los mejores modelos de embedding para su caso de uso específico, minimizando la dependencia del proveedor. | Diseño independiente del framework que soporta embeddings híbridos (OpenAI, Gemini) y modelos locales (Ollama, E5, BGE) sin costo alguno. |

| Control de Datos | Gobernanza completa sobre el ciclo de vida, la seguridad y la ubicación de almacenamiento de sus datos. | Propiedad del 100% de los datos y capacidades de borrado total a través de sólidos puntos finales de API. |

Conclusión

OpenMemory proporciona la infraestructura crítica necesaria para la próxima generación de aplicaciones LLM inteligentes y conscientes del contexto. Al ofrecer un motor de memoria autoalojado, optimizado para el rendimiento y arquitectónicamente superior, usted obtiene el control, la velocidad y la profundidad necesarios para construir experiencias de IA verdaderamente persistentes y confiables.