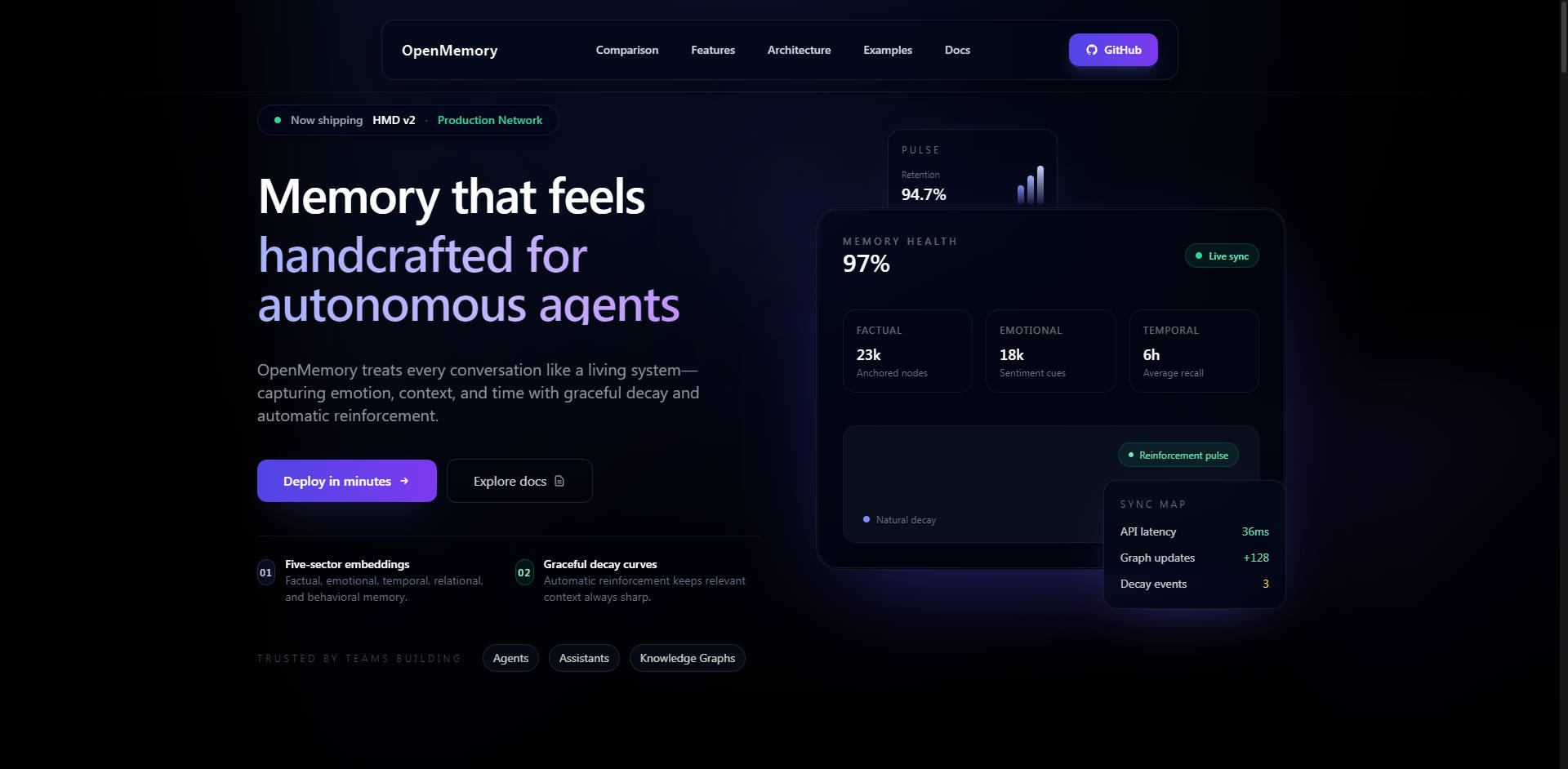

What is OpenMemory?

OpenMemory est un moteur de mémoire IA modulaire et auto-hébergé, conçu pour résoudre le problème crucial des fenêtres de contexte limitées des LLM. Il offre une mémoire à long terme persistante, structurée et sémantique, permettant aux agents IA, aux assistants et aux copilotes d'entreprise de retenir en toute sécurité les données utilisateur complexes, les préférences et les interactions antérieures, quelle que soit la session ou la tâche. Conçu pour les développeurs et les organisations qui privilégient le contrôle, la performance et la transparence, OpenMemory garantit que vos applications IA conservent le contexte de manière efficace et confidentielle.

Fonctionnalités Clés

OpenMemory offre une véritable mémoire à long terme grâce à un modèle cognitif spécialisé, allant au-delà du simple stockage vectoriel pour proposer une récupération de contexte nuancée et explicable.

🧠 Architecture de Décomposition Hiérarchique de la Mémoire (HMD)

L'HMD est l'innovation fondamentale qui distingue OpenMemory des bases de données vectorielles traditionnelles ou des couches de mémoire simplistes. Au lieu de stocker tout le contexte de manière uniforme, l'HMD décompose les souvenirs en embeddings multisectoriels (épisodiques, sémantiques, procéduraux, réflexifs, émotionnels). Cette architecture d'inspiration biologique utilise un graphe de liaison éparse à point unique pour garantir un nœud canonique par souvenir, réduisant considérablement la duplication des données et améliorant la précision de la récupération. Cette structure est essentielle pour atteindre une latence réduite et des chemins de raisonnement explicables.

🔒 Sécurité Auto-Hébergée et Propriété des Données

De par sa conception, OpenMemory est auto-hébergé, déployable localement, via Docker, ou dans votre environnement de cloud privé. Cette architecture garantit la propriété intégrale des données à 100 % et la confidentialité, éliminant l'exposition des données au fournisseur inhérente aux API de mémoire hébergées. Les fonctionnalités de sécurité incluent l'authentification Bearer pour les API d'écriture, des crochets de nettoyage et d'anonymisation des informations personnelles identifiables (PII), un chiffrement de contenu AES-GCM optionnel et une isolation robuste des locataires pour les déploiements multi-utilisateurs.

💻 Extension VS Code pour la Persistance du Copilote

L'extension dédiée VS Code confère aux assistants IA une mémoire persistante tout au long des sessions de codage complexes. Cette extension offre une intégration sans configuration, traquant automatiquement chaque modification, sauvegarde et ouverture de fichier. De manière cruciale, elle utilise la Smart Compression pour réduire intelligemment l'utilisation des tokens de 30 à 70 %, assurant une livraison de contexte rentable et fournissant des réponses aux requêtes en moins de 80 ms grâce à une mise en cache intelligente.

🔗 Intégration Approfondie avec LangGraph et MCP

OpenMemory est conçu pour l'orchestration IA moderne. Il intègre un Mode d'Intégration LangGraph (LGM) dédié, qui fournit des points de terminaison REST spécialisés pour mapper automatiquement les sorties de nœuds (par exemple, observe, plan, reflect) au stockage HMD multisectoriel approprié. De plus, le Serveur HTTP du Protocole de Contexte de Modèle (MCP) intégré permet aux agents compatibles MCP (comme Claude Desktop et les SDK personnalisés) de se connecter immédiatement sans nécessiter d'installation de SDK, améliorant ainsi l'interopérabilité agnostique des frameworks.

Cas d'Utilisation

OpenMemory est conçu pour les scénarios exigeant une fidélité de contexte, une sécurité et une rétention à long terme élevées.

1. Développement de Copilotes d'Entreprise

Déployez OpenMemory au sein de votre réseau d'entreprise sécurisé pour alimenter des copilotes de niveau entreprise. Cela garantit que toutes les données propriétaires, les procédures opérationnelles et les préférences des employés sont mémorisées de manière sécurisée et confidentielle. Les capacités de nettoyage des PII et d'isolation des locataires permettent un déploiement multi-utilisateur conforme où l'intégrité et le contrôle des données sont non négociables.

2. Mémoire à Long Terme et Personnalisation des Agents

Créez des agents IA qui évoluent et apprennent véritablement au fil du temps. En utilisant l'architecture HMD, les agents peuvent récupérer des souvenirs non seulement basés sur la similarité sémantique, mais aussi sur l'historique procédural ou des réflexions perspicaces. Cela permet à l'agent de se souvenir d'actions passées spécifiques, de comprendre des habitudes utilisateur complexes et de fournir une assistance hautement personnalisée et contextuellement pertinente sur des semaines ou des mois.

3. Persistance Améliorée des Flux de Travail des Développeurs

L'extension OpenMemory VS Code permet aux équipes de développement utilisant des assistants IA (comme GitHub Copilot ou Cursor) de maintenir une mémoire persistante à travers les redémarrages, les branches de code et les projets de longue haleine. L'assistant ne se contente pas de se souvenir du fichier actuel ; il se souvient du contexte de l'historique complet du projet, des décisions architecturales prises la semaine dernière et des étapes de débogage spécifiques effectuées hier, réduisant considérablement la répétition redondante du contexte et améliorant l'efficacité.

Pourquoi Choisir OpenMemory ? Avantages Uniques

OpenMemory est conçu pour surpasser les solutions de mémoire traditionnelles sur des métriques clés : vitesse, coût et transparence fonctionnelle.

| Avantage | Bénéfice | Différenciateur de Performance |

|---|---|---|

| Performance & Coût Supérieurs | Obtenez une meilleure précision contextuelle et une récupération plus rapide tout en réduisant drastiquement les coûts opérationnels. | Rappel contextuel 2 à 3 fois plus rapide et coût 6 à 10 fois inférieur par rapport aux « API de mémoire » hébergées. (par exemple, 2,5 fois plus rapide et 10 à 15 fois moins cher que Zep à la même échelle). |

| Rappel Explicable | Comprenez précisément pourquoi une information contextuelle a été récupérée, assurant transparence et confiance dans le raisonnement de l'IA. | Le modèle cognitif multisectoriel permet des chemins de rappel explicables basés sur des types de mémoire spécifiques (épisodique, sémantique, etc.). |

| Véritable Ouverture et Flexibilité | Utilisez les meilleurs modèles d'embedding pour votre cas d'utilisation spécifique, minimisant ainsi la dépendance vis-à-vis d'un fournisseur. | Conception agnostique des frameworks prenant en charge les embeddings hybrides (OpenAI, Gemini) et les modèles locaux (Ollama, E5, BGE) sans frais. |

| Contrôle des Données | Gouvernance complète sur le cycle de vie de vos données, leur sécurité et leur emplacement de stockage. | Propriété intégrale des données à 100 % et capacités d'effacement complètes via des points de terminaison d'API robustes. |

Conclusion

OpenMemory fournit l'infrastructure critique nécessaire à la prochaine génération d'applications LLM intelligentes et sensibles au contexte. En offrant un moteur de mémoire auto-hébergé, optimisé pour la performance et architecturalement supérieur, vous obtenez le contrôle, la vitesse et la profondeur nécessaires pour construire des expériences IA véritablement persistantes et fiables.