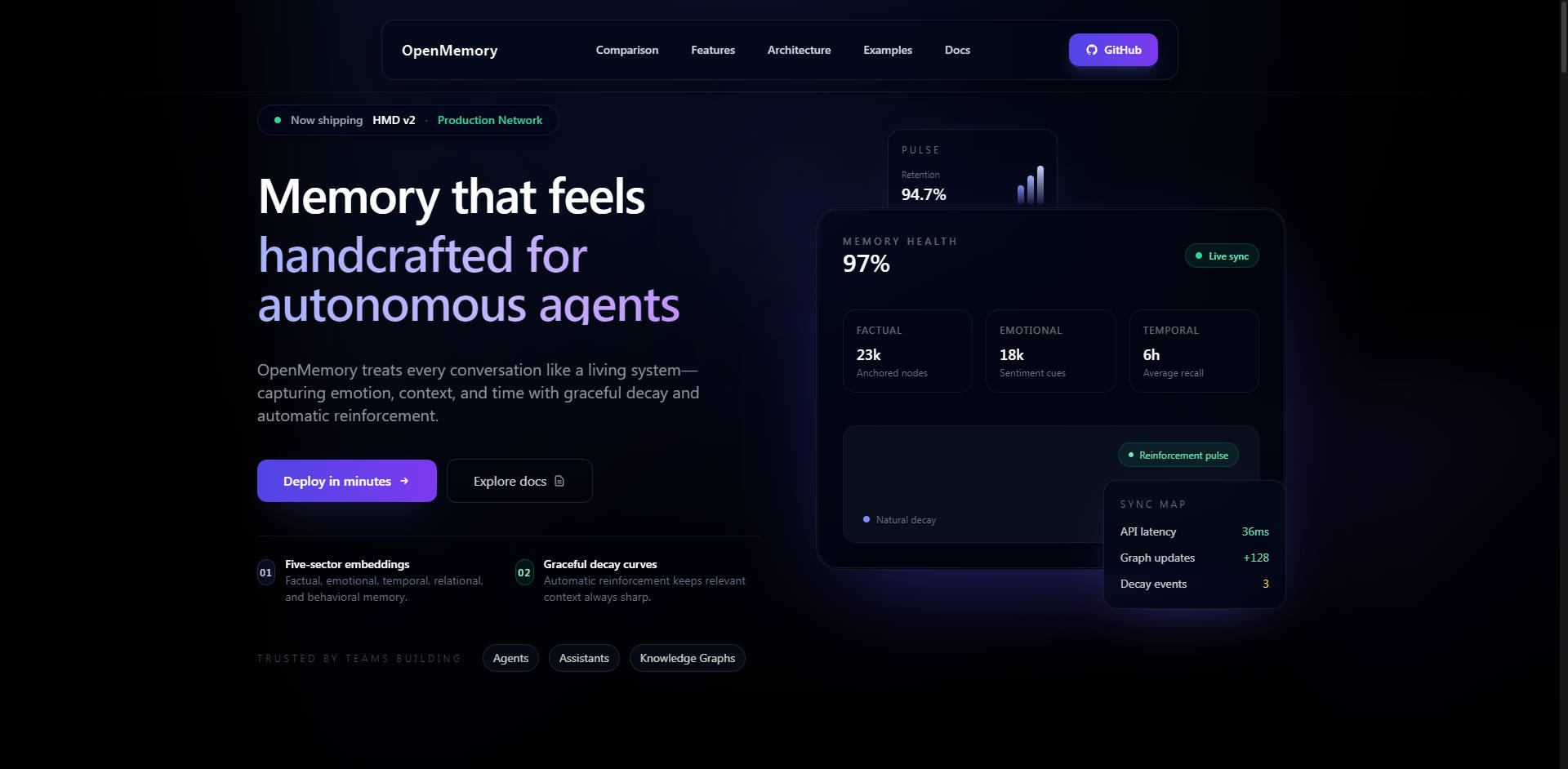

What is OpenMemory?

OpenMemoryは、限られたLLMコンテキストウィンドウという喫緊の課題を解決するために設計された、モジュール式でセルフホスト型のAIメモリエンジンです。セッションやタスクを超えて、AIエージェント、アシスタント、エンタープライズコパイロットが複雑なユーザーデータ、設定、過去のインタラクションを安全に記憶できるよう、永続的で構造化された意味のある長期記憶を提供します。制御、パフォーマンス、透明性を重視する開発者や組織向けに設計されたOpenMemoryは、AIアプリケーションがコンテキストを効率的かつプライベートに保持することを保証します。

主な機能

OpenMemoryは、特殊な認知モデルを通じて真の長期記憶を実現し、単純なベクトルストレージを超えて、繊細で説明可能なコンテキスト検索を提供します。

🧠 階層的メモリ分解(HMD)アーキテクチャ

HMDは、OpenMemoryを従来のベクトルデータベースや単純なメモリ層から区別する核となるイノベーションです。HMDは、すべてのコンテキストを一様に保存するのではなく、記憶をマルチセクター埋め込み(エピソード、意味、手続き、内省、感情)に分解します。この生物学的発想に基づくアーキテクチャは、疎な単一のウェイポイント連結グラフを使用し、メモリごとに1つの規範ノードを確保することで、データの重複を劇的に削減し、検索精度を向上させます。この構造は、低レイテンシーと説明可能な推論経路を実現するための鍵となります。

🔒 セルフホスト型セキュリティとデータ所有権

OpenMemoryは設計上セルフホスト型であり、ローカル、Docker経由、またはプライベートクラウド環境にデプロイ可能です。このアーキテクチャは100%のデータ所有権とプライバシーを保証し、ホスト型メモリAPIに内在するベンダーへのデータ露出を排除します。セキュリティ機能には、書き込みAPI用のBearer認証、PIIスクラブおよび匿名化フック、オプションのAES-GCMコンテンツ暗号化、多人数デプロイメントにおける堅牢なテナント分離が含まれます。

💻 VS Code Extensionによるコパイロットの永続性

専用のVS Code Extensionは、複雑なコーディングセッション全体でAIアシスタントに永続的なメモリを提供します。この拡張機能はゼロコンフィグ統合を提供し、すべてのファイルの編集、保存、オープンを自動的に追跡します。特に、Smart Compressionを使用してトークン使用量を30〜70%インテリジェントに削減し、費用対効果の高いコンテキスト配信を保証し、インテリジェントなキャッシュを通じて80ミリ秒未満のクエリ応答を提供します。

🔗 LangGraphおよびMCPとのディープな統合

OpenMemoryは、現代のAIオーケストレーション向けに設計されています。専用のLangGraph Integration Mode (LGM)を特徴とし、ノード出力(例:observe、plan、reflect)を適切なマルチセクターHMDストレージに自動的にマッピングするための特殊なRESTエンドポイントを提供します。さらに、内蔵のModel Context Protocol (MCP) HTTP Serverにより、MCP対応エージェント(Claude DesktopやカスタムSDKなど)はSDKのインストールを必要とせずに即座に接続でき、フレームワークに依存しない相互運用性を向上させます。

ユースケース

OpenMemoryは、高いコンテキスト忠実度、セキュリティ、長期的な保持が求められるシナリオのために構築されています。

1. エンタープライズコパイロットの開発

セキュアな企業ネットワーク内にOpenMemoryをデプロイし、エンタープライズグレードのコパイロットを強化します。これにより、すべての専有データ、運用手順、従業員の嗜好が安全かつプライベートに記憶されることが保証されます。PIIスクラブ機能とテナント分離機能により、データ整合性と制御が譲れない多人数利用のデプロイメントにおいて、コンプライアンスに準拠した運用が可能です。

2. エージェントの長期記憶とパーソナライゼーション

時間とともに真に進化し学習するAIエージェントを構築します。HMDアーキテクチャを活用することで、エージェントは意味的類似性だけでなく、手続き履歴や内省的な洞察に基づいて記憶を検索できます。これにより、エージェントは特定の過去の行動を想起し、複雑なユーザー習慣を理解し、数週間または数ヶ月にわたって高度にパーソナライズされた、文脈に関連性の高い支援を提供できます。

3. 開発者ワークフローの永続性の向上

OpenMemory VS Code Extensionは、AIアシスタント(GitHub CopilotやCursorなど)を利用する開発チームが、再起動、コードブランチ、長期プロジェクトにわたって永続的なメモリを維持できるようにします。アシスタントは現在のファイルだけでなく、プロジェクト全体の履歴、先週下されたアーキテクチャ上の決定、昨日実行された特定のデバッグ手順といったコンテキストを記憶するため、冗長なコンテキストの繰り返しを大幅に削減し、効率を向上させます。

OpenMemoryを選ぶ理由:独自の利点

OpenMemoryは、主要な指標(速度、コスト、機能的透明性)において、従来のメモリソリューションを上回るように設計されています。

| 利点 | メリット | パフォーマンス上の差別化要因 |

|---|---|---|

| 優れたパフォーマンスとコスト | 運用コストを大幅に削減しつつ、より優れたコンテキスト精度と高速な検索を実現します。 | ホスト型「メモリAPI」と比較して、2~3倍高速なコンテキスト想起と6~10倍の低コストを実現します(例:Zepと同規模で2.5倍高速、10~15倍低コスト)。 |

| 説明可能な想起 | なぜ特定のコンテキストが検索されたのかを正確に理解し、AIの推論における透明性と信頼性を確保します。 | マルチセクター認知モデルにより、特定の記憶タイプ(エピソード、意味など)に基づいた説明可能な想起経路が可能になります。 |

| 真のオープン性と柔軟性 | 特定のユースケースに最適な埋め込みモデルを活用し、ベンダーロックインを最小限に抑えます。 | ハイブリッド埋め込み(OpenAI、Gemini)およびローカルモデル(Ollama、E5、BGE)をゼロコストでサポートするフレームワークにとらわれない設計です。 |

| データ制御 | データライフサイクル、セキュリティ、保存場所に対する完全なガバナンスを実現します。 | 堅牢なAPIエンドポイントを通じて、100%のデータ所有権と完全な消去機能を提供します。 |

まとめ

OpenMemoryは、次世代のインテリジェントでコンテキストを意識したLLMアプリケーションに必要な不可欠なインフラストラクチャを提供します。セルフホスト型、パフォーマンス最適化済み、そしてアーキテクチャ的に優れたメモリエンジンを提供することで、真に永続的で信頼できるAI体験を構築するために必要な制御、速度、深さを手に入れることができます。