What is OpenMemory?

OpenMemory는 제한된 LLM 컨텍스트 윈도우라는 중요한 문제를 해결하기 위해 설계된 모듈형 자체 호스팅 AI 메모리 엔진입니다. 이는 영구적이고 구조화되며 의미론적인 장기 기억을 제공하여 AI 에이전트, 어시스턴트 및 기업용 코파일럿이 세션과 작업 전반에 걸쳐 복잡한 사용자 데이터, 선호도 및 이전 상호 작용을 안전하게 기억할 수 있도록 지원합니다. 제어, 성능 및 투명성을 중요하게 생각하는 개발자와 조직을 위해 설계된 OpenMemory는 AI 애플리케이션이 컨텍스트를 효율적이고 사적으로 유지하도록 보장합니다.

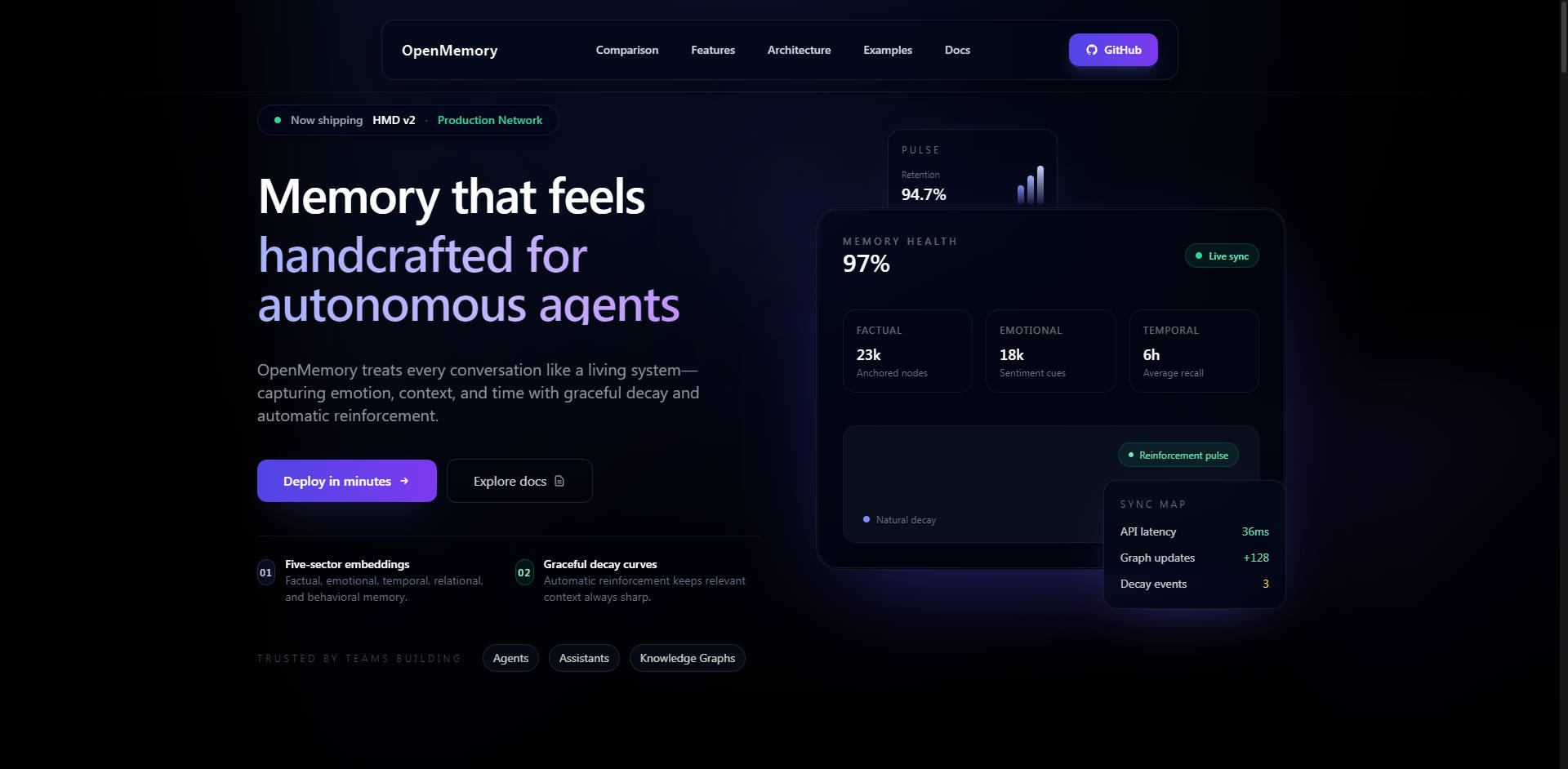

핵심 기능

OpenMemory는 특화된 인지 모델을 통해 진정한 장기 기억을 제공하며, 단순한 벡터 스토리지를 넘어 미묘하고 설명 가능한 컨텍스트 검색을 제공합니다.

🧠 Hierarchical Memory Decomposition (HMD) 아키텍처

HMD는 OpenMemory를 기존 벡터 데이터베이스 또는 단순 메모리 레이어와 차별화하는 핵심 혁신입니다. HMD는 모든 컨텍스트를 균일하게 저장하는 대신, 기억을 다중 섹터 임베딩(일화적, 의미적, 절차적, 성찰적, 감성적)으로 분해합니다. 이 생체에서 영감을 받은 아키텍처는 희소하고 단일 웨이포인트 연결 그래프를 사용하여 메모리당 하나의 정규 노드를 보장함으로써 데이터 중복을 획기적으로 줄이고 검색 정확도를 향상시킵니다. 이 구조는 낮은 지연 시간과 설명 가능한 추론 경로를 달성하는 데 핵심입니다.

🔒 자체 호스팅 보안 및 데이터 소유권

OpenMemory는 설계상 자체 호스팅 방식으로, 로컬, Docker 또는 개인 클라우드 환경에 배포할 수 있습니다. 이 아키텍처는 100% 데이터 소유권과 프라이버시를 보장하며, 호스팅된 메모리 API에 내재된 공급업체 데이터 노출 위험을 제거합니다. 보안 기능에는 쓰기 API를 위한 Bearer authentication, PII(개인 식별 정보) 스크러빙 및 익명화 후크, 선택적 AES-GCM 콘텐츠 암호화, 다중 사용자 배포를 위한 강력한 테넌트 격리가 포함됩니다.

💻 Copilot 영구성을 위한 VS Code Extension

전용 VS Code Extension은 복잡한 코딩 세션 전반에 걸쳐 AI 어시스턴트에게 영구적인 메모리를 제공합니다. 이 확장 프로그램은 제로 구성 통합을 제공하며, 모든 파일 편집, 저장 및 열기 작업을 자동으로 추적합니다. 결정적으로, **Smart Compression**을 사용하여 토큰 사용량을 30–70% 지능적으로 줄여 비용 효율적인 컨텍스트 전달을 보장하고 지능형 캐싱을 통해 80ms 미만의 쿼리 응답을 제공합니다.

🔗 LangGraph 및 MCP와의 심층 통합

OpenMemory는 현대 AI 오케스트레이션을 위해 설계되었습니다. 전용 LangGraph Integration Mode (LGM)를 제공하며, 이는 특수 REST 엔드포인트를 통해 노드 출력(예: <code>observe</code>, <code>plan</code>, <code>reflect</code>)을 적절한 다중 섹터 HMD 스토리지에 자동으로 매핑합니다. 또한, 내장된 Model Context Protocol (MCP) HTTP Server는 MCP를 인지하는 에이전트(Claude Desktop 및 사용자 정의 SDK 등)가 SDK 설치 없이 즉시 연결할 수 있도록 하여 프레임워크에 구애받지 않는 상호 운용성을 향상시킵니다.

사용 사례

OpenMemory는 높은 컨텍스트 충실도, 보안 및 장기 보존이 요구되는 시나리오를 위해 구축되었습니다.

1. 기업용 Copilot 개발

보안된 기업 네트워크 내에 OpenMemory를 배포하여 기업 등급의 코파일럿을 구동하세요. 이는 모든 독점 데이터, 운영 절차 및 직원 선호도가 안전하고 비공개적으로 기억되도록 보장합니다. PII 스크러빙 및 테넌트 격리 기능은 데이터 무결성 및 제어가 필수적인 규정 준수 다중 사용자 배포를 가능하게 합니다.

2. 장기 에이전트 메모리 및 개인화

시간이 지남에 따라 진정으로 발전하고 학습하는 AI 에이전트를 구축하세요. HMD 아키텍처를 활용하여 에이전트는 의미론적 유사성뿐만 아니라 절차적 기록 또는 성찰적 통찰력을 기반으로 기억을 검색할 수 있습니다. 이는 에이전트가 특정 과거 행동을 회상하고, 복잡한 사용자 습관을 이해하며, 몇 주 또는 몇 달에 걸쳐 고도로 개인화되고 상황에 맞는 지원을 제공할 수 있도록 합니다.

3. 향상된 개발자 워크플로우 영구성

OpenMemory VS Code Extension은 AI 어시스턴트(예: GitHub Copilot 또는 Cursor)를 사용하는 개발팀이 재부팅, 코드 브랜치 및 장기 프로젝트 전반에 걸쳐 영구적인 메모리를 유지할 수 있도록 합니다. 어시스턴트는 현재 파일만 기억하는 것이 아니라, 전체 프로젝트 이력의 <em>컨텍스트</em>, 지난주에 내린 아키텍처 결정, 어제 수행된 특정 디버그 단계까지 기억하여 중복 컨텍스트 반복을 크게 줄이고 효율성을 향상시킵니다.

OpenMemory를 선택하는 이유? 고유한 장점

OpenMemory는 속도, 비용 및 기능 투명성과 같은 핵심 지표에서 기존 메모리 솔루션보다 뛰어난 성능을 발휘하도록 설계되었습니다.

| 장점 | 이점 | 성능 차별점 |

|---|---|---|

| 우수한 성능 및 비용 | 운영 비용을 대폭 절감하면서 더 나은 컨텍스트 정확도와 더 빠른 검색을 달성합니다. | 호스팅된 “메모리 API”에 비해 2–3배 더 빠른 컨텍스트 회상과 6–10배 낮은 비용을 제공합니다. (예: 동일한 규모에서 Zep보다 2.5배 빠르고 10–15배 저렴). |

| 설명 가능한 회상 | 특정 컨텍스트 조각이 <em>왜</em> 검색되었는지 정확히 이해하여 AI 추론의 투명성과 신뢰를 보장합니다. | 다중 섹터 인지 모델은 특정 기억 유형(일화적, 의미론적 등)을 기반으로 설명 가능한 회상 경로를 가능하게 합니다. |

| 진정한 개방성과 유연성 | 특정 사용 사례에 가장 적합한 임베딩 모델을 활용하여 공급업체 종속을 최소화합니다. | 하이브리드 임베딩(OpenAI, Gemini) 및 로컬 모델(Ollama, E5, BGE)을 비용 없이 지원하는 프레임워크 비종속적 설계. |

| 데이터 제어 | 데이터 수명 주기, 보안 및 저장 위치에 대한 완전한 거버넌스. | 강력한 API 엔드포인트를 통한 100% 데이터 소유권 및 완전 삭제 기능. |

결론

OpenMemory는 차세대 지능형, 컨텍스트 인식 LLM 애플리케이션에 필요한 핵심 인프라를 제공합니다. 자체 호스팅 방식의, 성능 최적화되고, 아키텍처적으로 우수한 메모리 엔진을 제공함으로써, 진정으로 영구적이고 신뢰할 수 있는 AI 경험을 구축하는 데 필요한 제어, 속도 및 깊이를 얻게 됩니다.