What is Evaligo?

Evaligo 是一个综合性AI开发平台,专为工程团队和开发者设计,旨在帮助他们大规模交付可靠的AI功能。它将提示词生成、严格评估和生产追踪集中整合到一个统一的工作空间中。通过告别分散的脚本和仪表盘,Evaligo 使您能够快速迭代,防止代价高昂的回归,并确保您的AI应用在模型和需求演进过程中保持一致的质量和性能。

主要功能

Evaligo 提供贯穿整个AI开发生命周期系统化质量保证的核心基石。

🛠️ 交互式提示词调试与实验平台: 在协作环境中进行提示词实验、回放和优化。即时可视化参数更改的影响,并获得AI驱动的改进建议,从而加速您的设计和迭代周期。

⚖️ 以LLM作为裁判的提示词评估: 利用先进的语言模型,大规模提供细致入微、一致的评分和可操作的洞察。这项功能以客观、可重复的评估取代了主观的人工审查,确保每一次提示词更改都经过严格测试,符合您预设的质量标准。

🚀 提示词管理、测试与CI/CD: 安全地组织、版本控制和部署提示词。将评估驱动的检查直接集成到您的部署管道(CI/CD)中,在部署到生产环境之前自动捕获回归并防止性能下降。

📊 实时追踪与生产监控: 全面了解生产环境中每一个提示词、响应和模型决策。即时追踪问题,实时监控质量、成本和延迟指标,并利用持续评估确保您的在线应用的可靠性。

🧪 基于数据集的系统化实验: 通过将多个提示词或模型变体与经过精心策划、版本控制的数据集进行并排比较,运行结构化实验。这一过程为优化问题提供了数据驱动的答案,帮助您同时优化准确性、成本和延迟。

使用案例

Evaligo 将零散的提示词工程转化为严谨、可衡量的开发流程,从而带来显著的性能提升并降低运营风险。

1. 阻止部署回归

当您的团队需要升级底层LLM(例如,从GPT-3.5升级到GPT-4o)时,您可以使用Evaligo的CI/CD集成运行自动化回归检查。通过针对现有已验证数据集测试新模型,该平台会在部署最终完成之前自动标记任何准确性下降或错误率增加的情况,从而确保平稳安全的过渡。

2. 客观提示词优化

一个数据科学团队正在努力优化一个用于复杂分类任务的提示词。他们不再进行手动试错,而是使用交互式实验平台生成多个变体。接着,他们运行一项实验,利用“以LLM作为裁判”的功能,基于一致性和准确性指标对这些变体进行客观评分。这种系统化的方法使他们能够在几分钟内而非数天内识别并部署表现最佳的提示词配置。

3. 完善生产反馈闭环

一个在线内容生成API突然出现token使用量和延迟指标的激增。工程团队利用Evaligo的实时追踪功能,即时查明导致异常的具体用户输入和相关提示词版本。他们分析生产追踪数据,识别出一个未处理的边缘情况,并利用这些真实世界数据立即更新他们的评估数据集,确保修复得到验证并防止未来的回归。

为何选择 Evaligo?

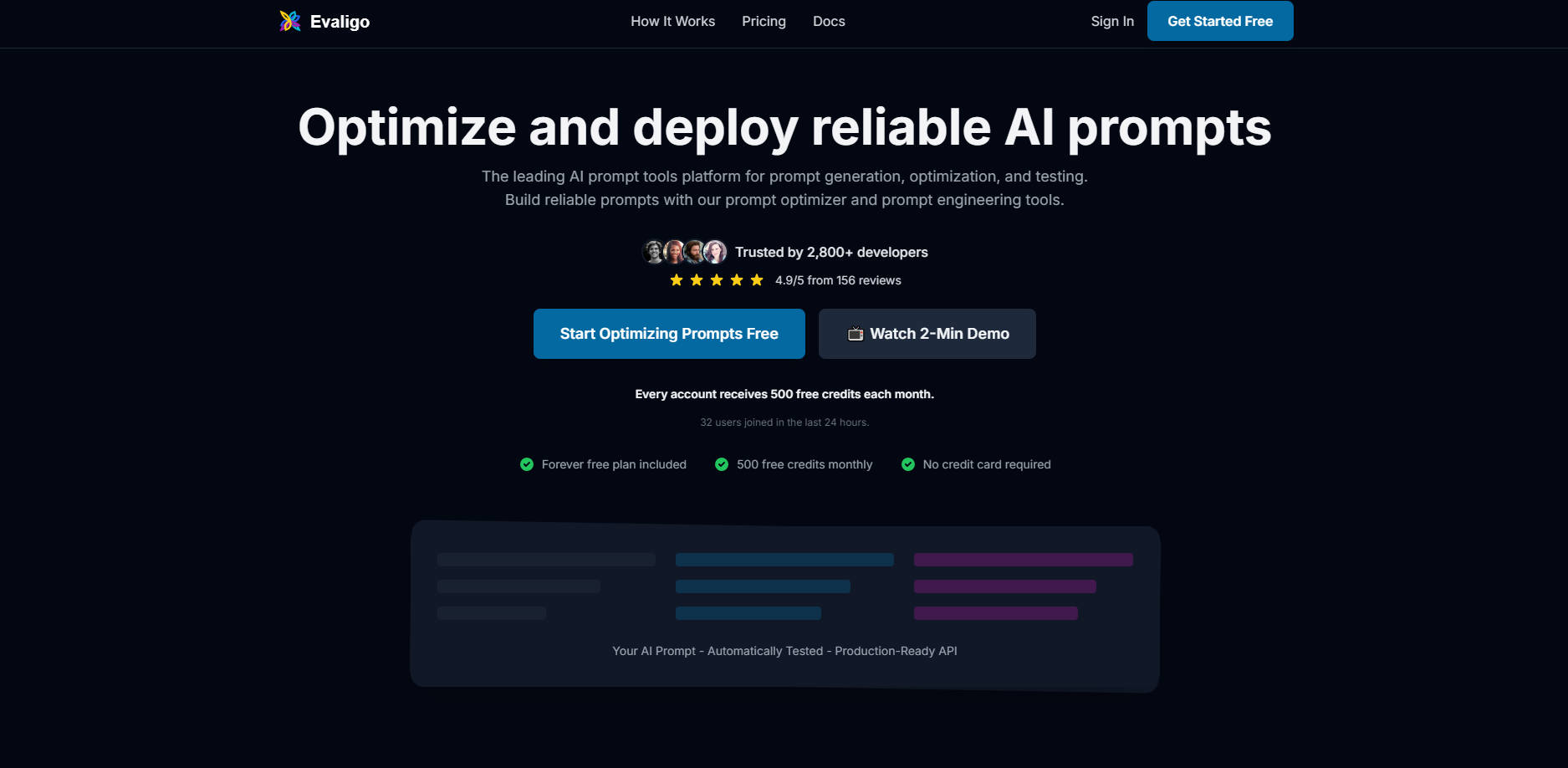

Evaligo 受到超过2,800名开发者的信赖,因为它提供了一种集成化、以开发者为中心的AI质量保证方法,远超简单的提示词管理。

集成式三步工作流: Evaligo 支持完整的开发周期:**迭代**(在实验平台快速优化),**评估**(通过自动化检查和自定义指标测试每次更改),以及**发布**(监控生产性能并自动化可靠性)。这种集成式闭环处理了复杂性,让您能够专注于构建可靠的功能。

客观质量保证: 与仅仅依赖人工审查的平台不同,Evaligo 使用结构化数据集和基于LLM的裁判来提供一致、客观且可量化的质量、安全性与性能指标。这确保了改进是可衡量且可持续的。

开发者信任与社区: 凭借4.9/5的客户评分和良好的业绩记录,Evaligo 提供了一个强大、生产就绪的API和专为工程团队设计的全面文档,让您能够自信地将想法转化为可靠的部署。

总结

Evaligo 助力开发者更快地行动,更可靠地构建。通过集中化实验、客观评估和实时生产监控,您将获得部署和扩展高质量AI功能所需的信心。