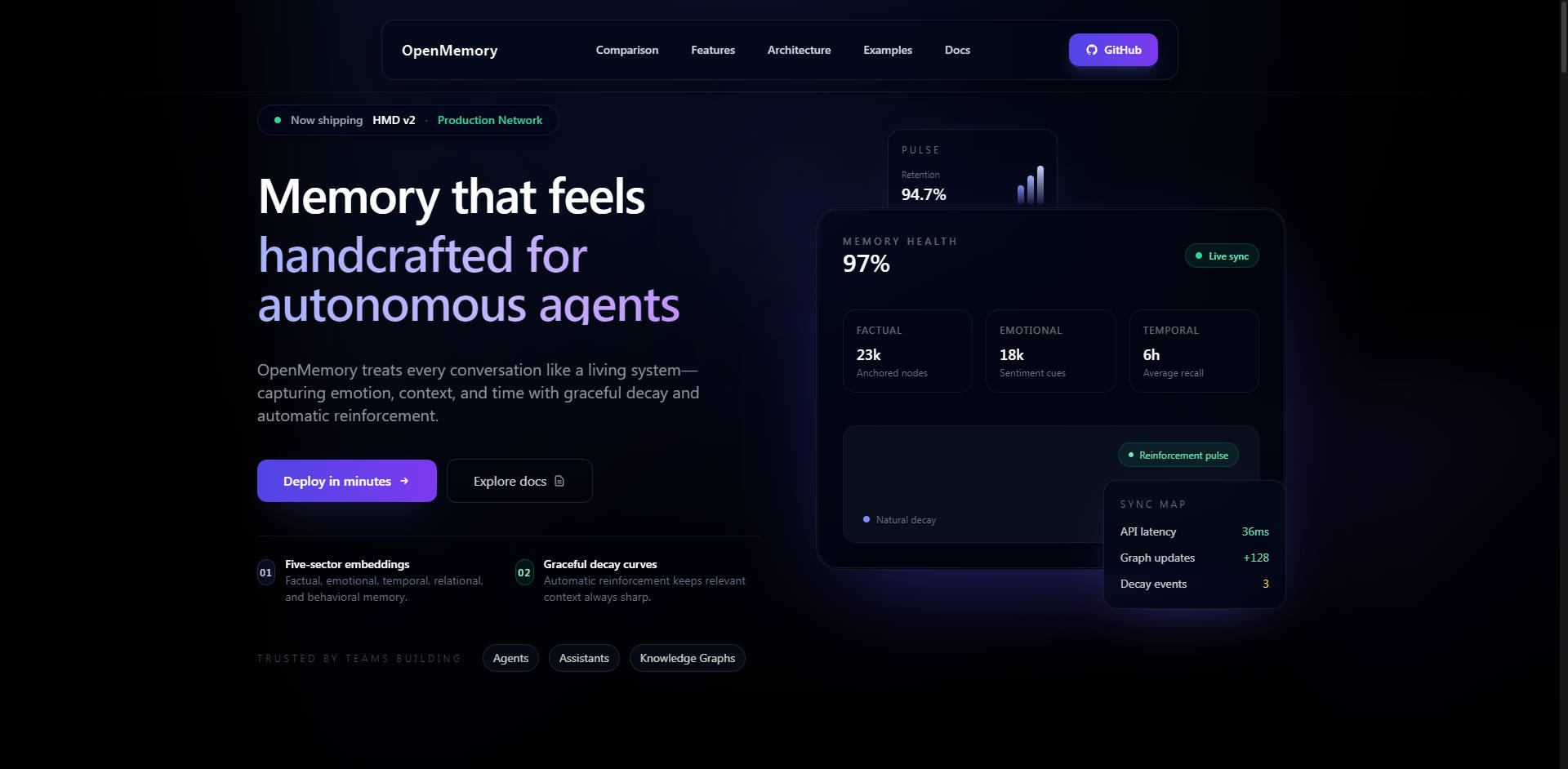

What is OpenMemory?

OpenMemory是一个模块化、自托管的AI记忆引擎,旨在解决大型语言模型 (LLM) 上下文窗口限制这一关键问题。它提供持久化、结构化、语义化的长时记忆能力,使AI智能体、助手和企业级Copilot能够在不同会话和任务中安全地记住复杂的用户数据、偏好和历史交互。OpenMemory专为优先考虑控制权、性能和透明度的开发者及组织设计,确保您的AI应用高效且私密地保留上下文。

核心功能

OpenMemory通过专门的认知模型实现真正的长时记忆,超越了简单的向量存储,提供细致入微、可解释的上下文检索。

🧠 分层记忆分解(HMD)架构

HMD是区分OpenMemory与传统向量数据库或简单记忆层的核心创新。HMD并非统一存储所有上下文,而是将记忆分解为 多扇区嵌入 (情景、语义、程序、反思、情感)。这种受生物学启发的架构使用稀疏的单路点链接图,确保每个记忆只有一个规范节点,大幅减少数据重复并提高检索精度。此结构是实现低延迟和可解释推理路径的关键。

🔒 自托管安全与数据所有权

OpenMemory天生为自托管而设计,可本地部署、通过Docker部署或部署在您的私有云环境中。这种架构保证了 100%的数据所有权 和隐私,消除了托管记忆API中固有的供应商数据暴露风险。安全功能包括写入API的Bearer认证、PII(个人身份信息)清洗和匿名化钩子、可选的AES-GCM内容加密,以及针对多用户部署的强大租户隔离。

💻 用于Copilot持久性的VS Code Extension

专用的VS Code Extension在复杂的编码会话中为AI助手提供持久记忆。此扩展提供零配置集成,自动跟踪每次文件编辑、保存和打开。关键在于,它采用 智能压缩 技术,将token使用量智能减少 30-70%,确保了经济高效的上下文交付,并通过智能缓存提供80毫秒以内的查询响应。

🔗 与LangGraph和MCP的深度集成

OpenMemory专为现代AI编排而设计。它设有专用的 LangGraph Integration Mode (LGM),提供专门的REST端点,自动将节点输出(例如,observe、plan、reflect)映射到相应的多扇区HMD存储。此外,内置的 Model Context Protocol (MCP) HTTP Server 允许支持MCP的智能体(如Claude Desktop和自定义SDK)无需安装SDK即可立即连接,从而增强了与框架无关的互操作性。

应用场景

OpenMemory针对那些需要高上下文保真度、安全性和长期记忆保留的场景而构建。

1. 企业级Copilot开发

在您的安全企业网络内部署OpenMemory,为企业级Copilot提供强大支持。这确保了所有专有数据、操作流程和员工偏好都得到安全私密的记忆。PII清洗和租户隔离功能允许进行合规的多用户部署,在其中数据完整性和控制权是不可妥协的。

2. 智能体长时记忆与个性化

构建真正能够随着时间推移而演进和学习的AI智能体。通过利用HMD架构,智能体不仅基于语义相似性,还能根据程序历史或反思性洞察来检索记忆。这使得智能体能够回忆特定的过往行为,理解复杂的用户习惯,并在数周或数月内提供高度个性化、上下文相关的帮助。

3. 增强的开发者工作流持久性

OpenMemory VS Code Extension允许使用AI助手(如GitHub Copilot或Cursor)的开发团队在重启、代码分支和长期项目中保持持久记忆。助手不仅仅记住当前文件;它能记住整个项目历史的上下文、上周做出的架构决策,以及昨天采取的特定调试步骤,显著减少了冗余上下文重复,提高了效率。

为何选择OpenMemory?独特优势

OpenMemory旨在速度、成本和功能透明度等关键指标上超越传统记忆解决方案。

| 优势 | 益处 | 独特性能 |

|---|---|---|

| 卓越性能与成本 | 实现更高的上下文准确性和更快的检索速度,同时大幅削减运营成本。 | 相较于托管式“记忆API”,上下文召回速度快2-3倍,成本降低6-10倍。(例如,在相同规模下,比Zep快2.5倍,便宜10-15倍)。 |

| 可解释的召回 | 精确理解为什么某段上下文被检索,确保AI推理的透明度和可信度。 | 多扇区认知模型支持基于特定记忆类型(情景、语义等)的可解释召回路径。 |

| 真正的开放性与灵活性 | 为您的特定用例选择最佳的嵌入模型,最大程度减少供应商锁定。 | 与框架无关的设计,支持混合嵌入(OpenAI, Gemini)以及本地模型(Ollama, E5, BGE),且零成本。 |

| 数据控制 | 对您的数据生命周期、安全性及存储位置拥有完全的治理权。 | 通过强大的API端点,实现100%数据所有权和完全擦除功能。 |

总结

OpenMemory为下一代智能、上下文感知型LLM应用提供了所需的关键基础设施。通过提供自托管、性能优化且架构卓越的记忆引擎,您将获得所需的控制力、速度和深度,以构建真正持久且值得信赖的AI体验。