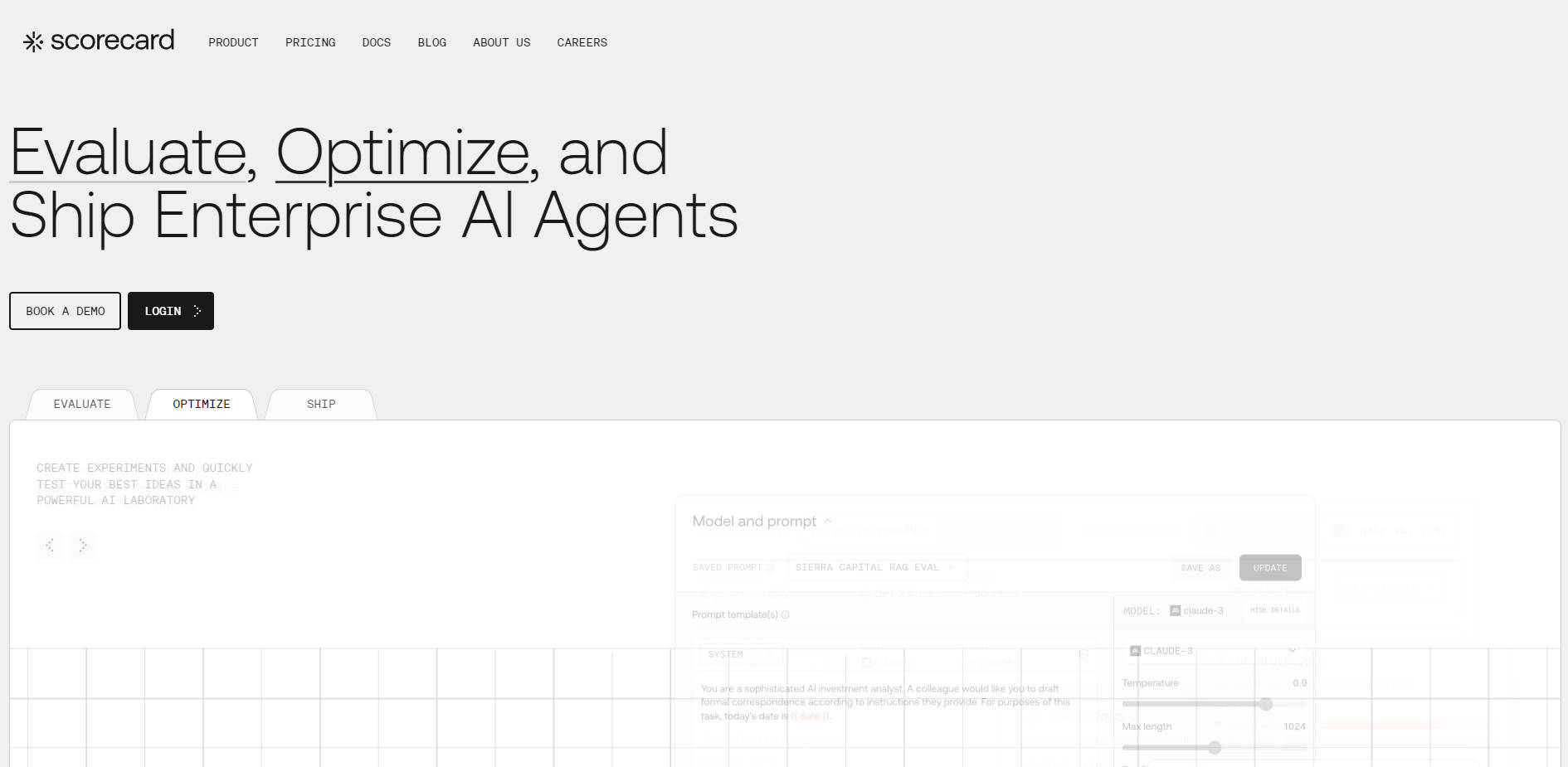

What is Scorecard?

Scorecard 是专为前瞻性团队打造的AI评估平台,旨在帮助他们构建并发布可靠的AI产品。该平台提供系统的基础设施,用于测试复杂的智能体、验证其性能,并在问题影响用户之前有效阻止代价高昂的回归错误,从而解决了AI可靠性这一核心难题。Scorecard 为AI性能评估带来了至关重要的清晰度和结构,赋能AI工程师、产品经理和质量保证(QA)团队协同合作,共同交付可预测的AI体验。

主要功能

Scorecard 提供全面的工具,以标准化AI质量保证流程,帮助您的团队从手动“凭感觉”的检验,迈向数据驱动的部署自信。

💡 持续评估与实时可观测性

将评估直接整合到您的开发周期中,让您在构建模型的同时监控其行为表现。这种实时可观测性能够提供用户与智能体交互的实时脉搏,帮助您快速识别问题、监控故障并发现性能改进机会,确保快速反馈循环。

📊 可靠的指标设计与验证

借助 Scorecard 经过验证的指标库,超越简单的输出检查。您可以访问行业基准,或定制经过验证的指标。在使用前,您可以对自定义指标进行压力测试和验证,并以人工评分作为“事实真相(ground truth)”来确保准确性,从而确保您所追踪的指标真正关乎您的业务成果。

⚙️ 统一的提示词管理与版本控制

通过在一个集中位置存储、追踪和管理所有生产环境中的提示词,为它们建立单一的“事实真相(single source of truth)”。利用内置的版本控制功能,您可以轻松比较提示词随时间的变化,追踪表现最佳的迭代版本,并维护清晰的有效历史记录,从而自信地将提示词部署到生产环境中。

🔄 将生产环境故障转化为测试用例

不要让实际问题溜走。Scorecard 使您能够捕获实际的生产环境故障,并立即将其转化为可重用、结构化的测试用例。这使您能够快速生成用于回归测试和微调的训练样本,确保关键问题得到解决并防止其在未来的部署中再次出现。

🧠 全面的智能体系统测试

Scorecard 支持现代AI智能体的全 спектrum,包括多轮对话、工具调用智能体、RAG(检索增强生成)管道以及复杂的多步骤工作流。您可以使用自动化用户画像在多轮模拟中测试完整的智能体配置(包括提示词、工具和设置),从而确保其在真实用户流程中的稳健性。

使用场景

Scorecard 无缝融入您的工作流程,解决AI产品生命周期中常见的可靠性和质量挑战。

1. 验证关键任务发布

在发布新功能或模型更新之前,对当前系统和拟议系统进行结构化的A/B对比。利用人工标注功能,邀请领域专家和产品经理提供“事实真相(ground truth)”验证,确保新的AI行为与用户预期和合规性要求完美契合。

2. 自动化回归预防

将 Scorecard 评估直接集成到您的CI/CD管道中。此自动化工作流会在性能低于预设阈值时触发警报,有效及早发现回归问题。通过系统化地运行全面的测试套件——包括那些由过去的生产环境故障生成的测试套件——您可以自信地部署新代码和模型。

3. 优化复杂智能体工作流

对于处理复杂、多步骤任务(如复杂推理或工具调用)的智能体,使用 Scorecard Playground 可以快速原型设计,并使用实际请求并行比较不同的模型和提示链。捕获详细的延迟指标(端到端、模型推理、网络),以识别性能瓶颈并在部署前优化智能体的效率。

独特优势

Scorecard 旨在提供系统化的基础设施和跨职能的可见性,这对于大规模工程化可靠AI至关重要。

系统化的AI评估基础设施:我们提供必要的Infrastructure来系统化地运行AI评估,用标准化流程取代手动检查。这使得AI工程师能够专注于开发,而平台则自动验证改进并防止回归。

以人为本的跨职能设计: Scorecard 旨在团结产品经理、领域专家和开发者。非技术性利益相关者可以轻松贡献领域专业知识,共同定义质量指标并验证成果,确保AI产品既满足技术要求,也符合用户期望。

一流的开发者体验:集成设计旨在实现快速和便捷。凭借 Python 和 JavaScript/TypeScript 的全面SDK,以及强大的 REST API,您可以在数分钟内将 Scorecard 集成到您的生产部署中,立即建立快速反馈循环。

总结

Scorecard 为您的团队提供了构建和发布真正可靠AI产品所需的结构、清晰度和信心。通过将实际性能转化为可操作数据,并将评估集成到整个开发周期中,您可以确保AI体验的可预测性,并使其持续改进。