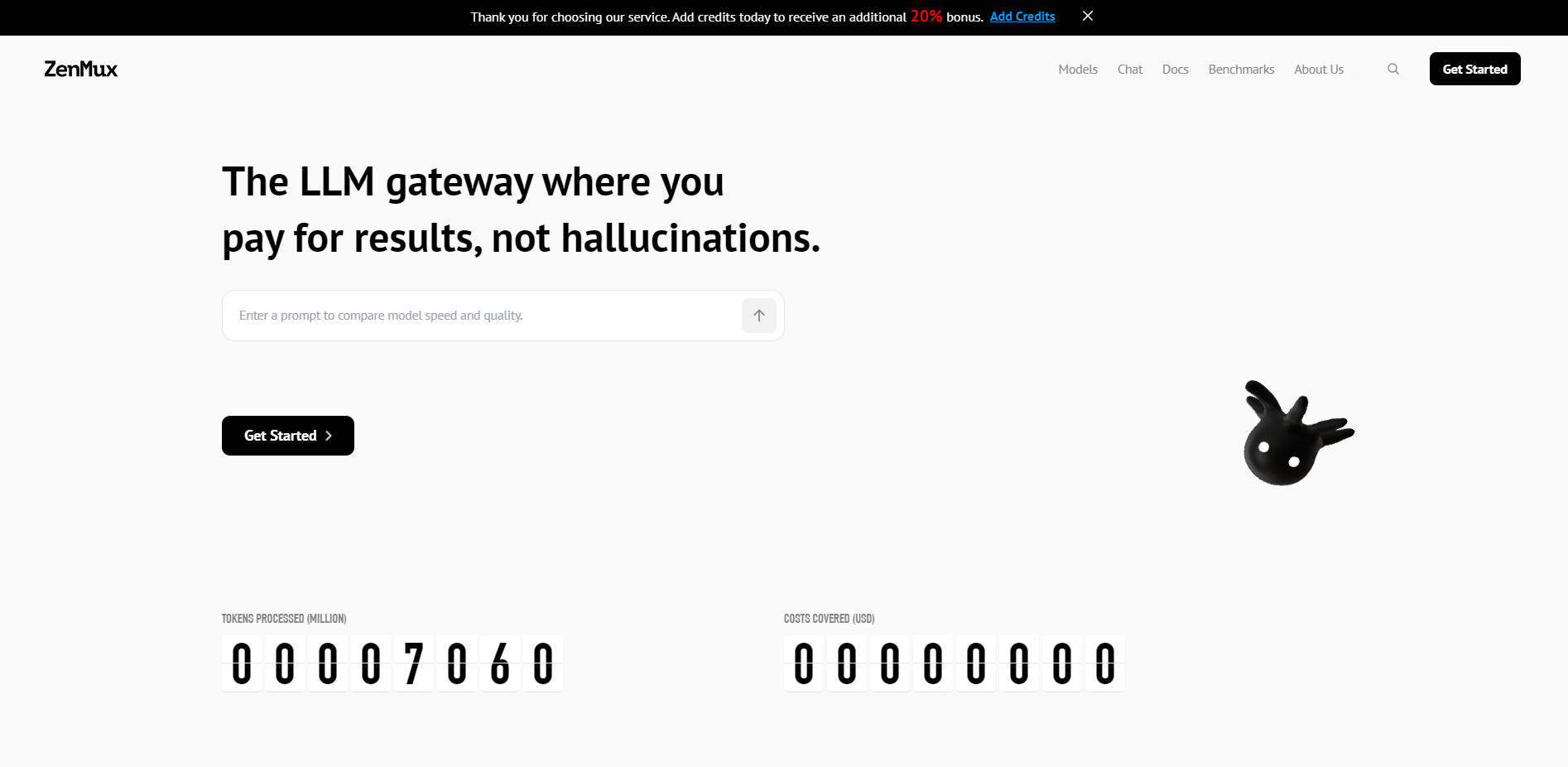

What is ZenMux?

ZenMux は、グローバルな大規模言語モデル(LLM)の複雑なオーケストレーションを簡素化し、固有の品質リスクを軽減するために設計された、世界初のエンタープライズグレードのモデル集約プラットフォームです。統合API、インテリジェントルーティング、そして画期的なAIモデル保険サービスを提供することで、ZenMuxは、モデルのハルシネーション、不安定な出力品質、複数ベンダー管理によるオーバーヘッドといった企業の懸念に包括的に対応します。これは、信頼性が高く、スケーラブルで、コスト最適化されたAIアプリケーションを構築する開発者や組織にとって不可欠なインフラストラクチャ層となります。

主な機能

ZenMux は、何千ものモデルを単一の信頼性の高いプラットフォームに統合し、複雑さを簡素化して最適な結果を生み出すというその哲学を体現しています。

🔗 ワンストップLLM統合 & 統一請求

ZenMux は、主要なクローズドソースモデルおよびオープンソースモデル(OpenAI、Anthropic、Google、DeepSeek など)を、単一のAPI標準とキーの背後に集約します。これにより、複数のプラットフォームアカウントの管理、ベンダーごとの登録、個別の請求書の照合といった運用上の摩擦が解消され、チームは純粋にアプリケーション開発に集中できるようになります。

🧠 インテリジェントモデルルーティング

手動での介入なしに、パフォーマンスとコストの最適なバランスを実現します。ZenMux は、リクエスト内容とタスク特性を自動的に分析し、最適なモデルをリアルタイムで選択します。このタスクに応じたマッチングにより、優先度の高い複雑なタスクはプレミアムモデルにルーティングされ、日常的なクエリには費用対効果の高い代替モデルが活用されるため、効率が最大化され、支出が最小限に抑えられます。

🛡️ AIモデル保険サービス

ZenMux は、モデル呼び出しの結果に対し、保険に裏付けられたセーフガードを提供する世界初のプラットフォームです。この革新的なメカニズムは、パフォーマンスの低下、過度なレイテンシー、重大なハルシネーションといったシナリオを保証します。日常的な自動検出と支払いを通じて、このサービスは重要なAIアプリケーションに対し、極めて重要な品質のバックストップを提供し、同時に製品改善のための貴重な最適化データを生成します。

🔎 透明性の高い品質保証(劣化検出)

プラットフォーム全体にわたる継続的な品質モニタリングを通じて、モデル選択に自信を持つことができます。ZenMux は、統合された全モデルチャネルにおける Human Last Exam(HLE)テストの結果を公に評価し、オープンソース化する業界初のプラットフォームです。この透明なメカニズムにより、「劣化」したモデルの使用が排除され、プラットフォーム上のすべてのプロバイダーの信頼性と真正性が確保されます。

🌍 グローバルエッジノードによる高可用性

AIアプリケーションが世界中で最高のパフォーマンスと安定性を維持することを保証します。ZenMux は、高い容量予約(Tier 5クォータ)を維持し、複数のプロバイダー間での自動フェイルオーバー機能を備えています。Cloudflare インフラストラクチャを基盤とし、グローバルエッジノードはネットワーク伝送のレイテンシーを低減し、ユーザーの地理的所在地に関わらず、低遅延で高性能なサービスを保証します。

ユースケース

ZenMux は、LLMを活用する企業にとっての主要な運用上および信頼性の課題を解決するために設計されています。

基幹アプリケーションのアップタイム保証: リアルタイムの顧客サービスボットや財務分析ツールといった重要度の高いアプリケーションにとって、ZenMuxのマルチベンダーサポートと自動フェイルオーバーアーキテクチャは不可欠です。プライマリプロバイダーが障害や容量制約を経験した場合でも、リクエストは即座に利用可能な代替プロバイダーに再ルーティングされ、開発者の介入やユーザーエクスペリエンスの低下なしにサービスの継続性を保証します。

コスト最適化されたRAGシステムの開発: Retrieval-Augmented Generation (RAG) システムを構築する際、開発者は迅速なプロトタイプ作成と効率的なスケーリングを必要とすることがよくあります。インテリジェントルーティングを使用すると、ZenMuxを構成して、初期の複雑な要約タスクには強力で高品質なモデル(例:GPT-4)を自動的に使用し、標準的な会話のフォローアップにはより手頃なモデル(例:DeepSeek)にシームレスに切り替えることができます。これにより、可能な限り低い運用コストで最適な結果を達成します。

グローバルで低遅延な機能の展開: ユーザーベースが大陸をまたいで分散している場合、ZenMuxのグローバルエッジノード展開は一貫した速度を保証します。アジアのユーザーがアプリケーションを呼び出すと、LLMリクエストは最寄りのエッジノードを経由してルーティングされ、レイテンシーが大幅に削減され、リアルタイム翻訳やコード生成のような時間に敏感なAI機能の応答性が向上します。

独自の利点

ZenMux は、従来の単一プロバイダーによるセットアップでは匹敵できないエンタープライズレベルの信頼性と柔軟性を提供するように根本的に設計されています。

画期的なリスク軽減: ZenMux は、AIモデル保険を提供する世界初のプラットフォームであり、出力品質の障害に対する検証可能な財務上のセーフティネットを提供し、本番環境のAI展開におけるリスクプロファイルを一変させます。

独自のデュアルプロトコルサポート: 単一のAPI標準を強制するプラットフォームとは異なり、ZenMux はOpenAI互換プロトコルとAnthropic互換プロトコルの両方を独自にサポートしています。この柔軟性により、開発チームは、コアロジックを書き換えることなく、最も慣れ親しんだAPIフレームワーク(例:既存の Claude Code ツールとの統合)を使用してシームレスに統合できます。

検証可能な品質の透明性: ZenMux の公開HLEテストとリアルタイム劣化検出は、これまでにないレベルの品質インサイトを提供します。ベンダーの主張に頼る必要はありません。モデル選択に役立つ、オープンソース化された継続的に更新されるデータが得られます。

結論

ZenMux は、マルチモデルAIの複雑な世界を簡素化し、開発者がミニマリストで回復力があり、完全に保証されたプラットフォームを通じて、何千ものLLMの力を活用できるようにします。最適な結果を達成し、コストを管理し、信頼性の懸念を解消します。

ZenMux が貴社のエンタープライズAI戦略をいかに効率化できるか、今すぐご確認ください。

よくある質問

Q1: ZenMux は統合のためにどのAPIプロトコルをサポートしていますか?

ZenMux は独自のデュアルプロトコルサポートを提供しています。プラットフォーム上のすべてのモデルを、広く採用されているOpenAI互換標準API、またはAnthropic互換標準APIのいずれかを使用して呼び出すことができます。これにより、最大限の統合の柔軟性が確保され、既存のプロジェクト要件とチームの専門知識に最も適したプロトコルを選択できます。

Q2: AIモデル保険サービスはどのように機能しますか?

AIモデル保険サービスは、パフォーマンスの劣化、過度な応答レイテンシー、重大なハルシネーション出力といった特定のシナリオをカバーすることで、品質のバックストップを提供します。保険チェックはプラットフォームの呼び出しデータに対し毎日実行され、高度なアルゴリズムを使用して「問題のあるケース」を特定します。支払いは翌日に自動的に清算され、潜在的な障害を製品の継続的な改善のための貴重な構造化データへと変えます。

Q3: ZenMux は、異なるモデル間でどのように高可用性を保証しますか?

ZenMux は、堅牢なマルチプロバイダー、マルチモデル冗長アーキテクチャを採用しています。重要なモデルに対しTier 5の容量クォータを維持し、同じLLMに対して複数のプロバイダー(例:Anthropic、Vertex AI、Amazon Bedrock)を自動的に統合します。あるプロバイダーがサービスインシデントや容量制限を経験した場合でも、システムは利用可能な別のプロバイダーへの即時かつ自動的なフェイルオーバーを実行し、サービスの継続性と信頼性を確保します。