VLM Run

VLM Run

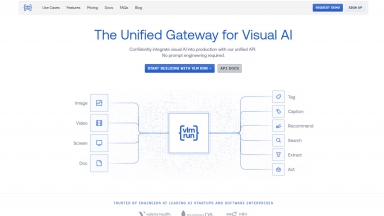

VLM Run:统一生产环境中的视觉 AI。预构建架构、精准模型、快速微调。非常适合医疗、金融、媒体行业。无缝集成。高精度和可扩展性。经济高效。

LLMWare.ai

LLMWare.ai

LLMWare.ai 使开发人员能够轻松创建企业 AI 应用程序。它拥有 50 多个专业模型,无需 GPU,并提供安全集成,非常适合金融、法律等领域。

VLM Run

| Launched | 2024-06 |

| Pricing Model | Paid |

| Starting Price | $499 /mo |

| Tech used | Google Analytics,Google Tag Manager,Framer,Google Fonts,Gzip,HTTP/3,OpenGraph,HSTS |

| Tag | Data Extraction,Data Integration,Data Visualization |

LLMWare.ai

| Launched | 2023-09 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,Framer,Gzip,HTTP/3,OpenGraph,HSTS |

| Tag | Developer Tools,Workflow Automation,Data Analysis |

VLM Run Rank/Visit

| Global Rank | 2061692 |

| Country | Bangladesh |

| Month Visit | 7325 |

Top 5 Countries

66.23%

26.51%

7.27%

Bangladesh

United States

India

Traffic Sources

6.27%

1.74%

0.13%

11.49%

39.6%

40.35%

social

paidReferrals

mail

referrals

search

direct

LLMWare.ai Rank/Visit

| Global Rank | 12033499 |

| Country | United States |

| Month Visit | 1527 |

Top 5 Countries

100%

United States

Traffic Sources

8.75%

0.51%

0.04%

4.82%

31.23%

54.64%

social

paidReferrals

mail

referrals

search

direct

Estimated traffic data from Similarweb

What are some alternatives?

When comparing VLM Run and LLMWare.ai, you can also consider the following products

GLM-4.5V - GLM-4.5V:以先进视觉,赋能您的AI。轻松将屏幕截图转化为网页代码,自动化图形用户界面操作,并深度推理分析文档与视频。

DeepSeek-VL2 - DeepSeek-VL2,是由 DeepSeek-AI 开发的视觉-语言模型,能够处理高分辨率图像,并借助 MLA 技术提供快速响应,在视觉问答 (VQA) 和光学字符识别 (OCR) 等多种视觉任务中表现出色。它是研究人员、开发者和商业智能 (BI) 分析师的理想之选。

Vellum - Vellum 简化了原型到生产的转型,具有快速实验、回归测试、版本控制以及可观测性功能。

Vero - VERO:面向大型语言模型(LLM)管道的企业级AI评估框架。快速检测并修复问题,将数周的质量保证(QA)工作,转化为短短数分钟的信心。

Runware.ai - 借助高效、经济实惠的API,创作高质量媒体。从毫秒级图像生成,到尖端视频推理,一切皆由定制硬件和可再生能源提供动力。无需基础设施或机器学习专业知识。