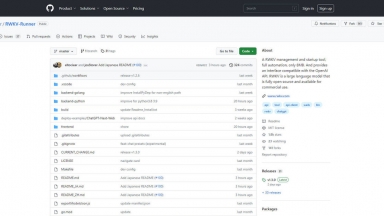

RWKV-Runner

RWKV-Runner

Runner H

Runner H

RWKV-Runner

| Launched | 2023 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Software Development |

Runner H

| Launched | 2024-04 |

| Pricing Model | Free Trial |

| Starting Price | |

| Tech used | Nuxt.js,Vercel,Gzip,OpenGraph,HSTS |

| Tag | Web Scraper |

RWKV-Runner Rank/Visit

| Global Rank | 0 |

| Country | |

| Month Visit | 0 |

Top 5 Countries

Traffic Sources

Runner H Rank/Visit

| Global Rank | 158927 |

| Country | United States |

| Month Visit | 241522 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

RWKV-LM - RWKV es una RNN con rendimiento LLM a nivel de transformer. Se puede entrenar directamente como un GPT (paralizable). Por lo tanto, combina lo mejor de RNN y transformer: gran rendimiento, inferencia rápida, ahorra VRAM, entrenamiento rápido, ctx_len "infinito" e incrustación de oraciones gratuita.

ChatRWKV - ChatRWKV es similar a ChatGPT pero funciona con el modelo de lenguaje RWKV (100 % RNN) y es de código abierto.

ktransformers - KTransformers, un proyecto de código abierto del equipo KVCache.AI de Tsinghua y QuJing Tech, optimiza la inferencia de modelos de lenguaje grandes. Reduce los umbrales de hardware, ejecuta modelos de 671B parámetros en GPUs individuales de 24GB de VRAM, aumenta la velocidad de inferencia (hasta 286 tokens/s en pre-procesamiento, 14 tokens/s en generación) y es adecuado para uso personal, empresarial y académico.

Command-R - Command-R es un modelo generativo escalable dirigido a RAG y al uso de herramientas para permitir la IA a escala de producción para empresas.