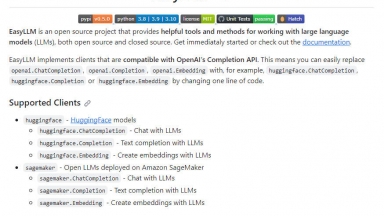

EasyLLM

EasyLLM

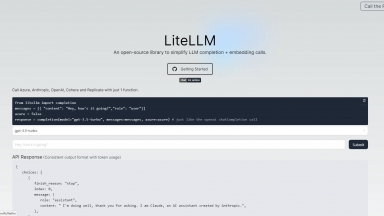

LiteLLM

LiteLLM

EasyLLM

| Launched | 2024 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Developer Tools,Chatbot Builder,Coding Assistants |

LiteLLM

| Launched | 2023-08 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Next.js,Vercel,Webpack,HSTS |

| Tag | Gateway |

EasyLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

LiteLLM Rank/Visit

| Global Rank | 102564 |

| Country | United States |

| Month Visit | 482337 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

vLLM - Un moteur d'inférence et de service à haut débit et économe en mémoire pour les LLM

OneLLM - OneLLM est votre plateforme no-code de bout en bout pour créer et déployer des LLM.

LazyLLM - LazyLLM : Le low-code pour les applications LLM multi-agents. Créez, itérez et déployez rapidement des solutions d'IA complexes, du prototype à la production. Concentrez-vous sur les algorithmes, et non sur l'ingénierie.

LLM Explorer - Découvrez, comparez et classez les modèles de langage volumineux sans effort avec LLM Extractum. Simplifiez votre processus de sélection et favorisez l'innovation dans les applications d'IA.