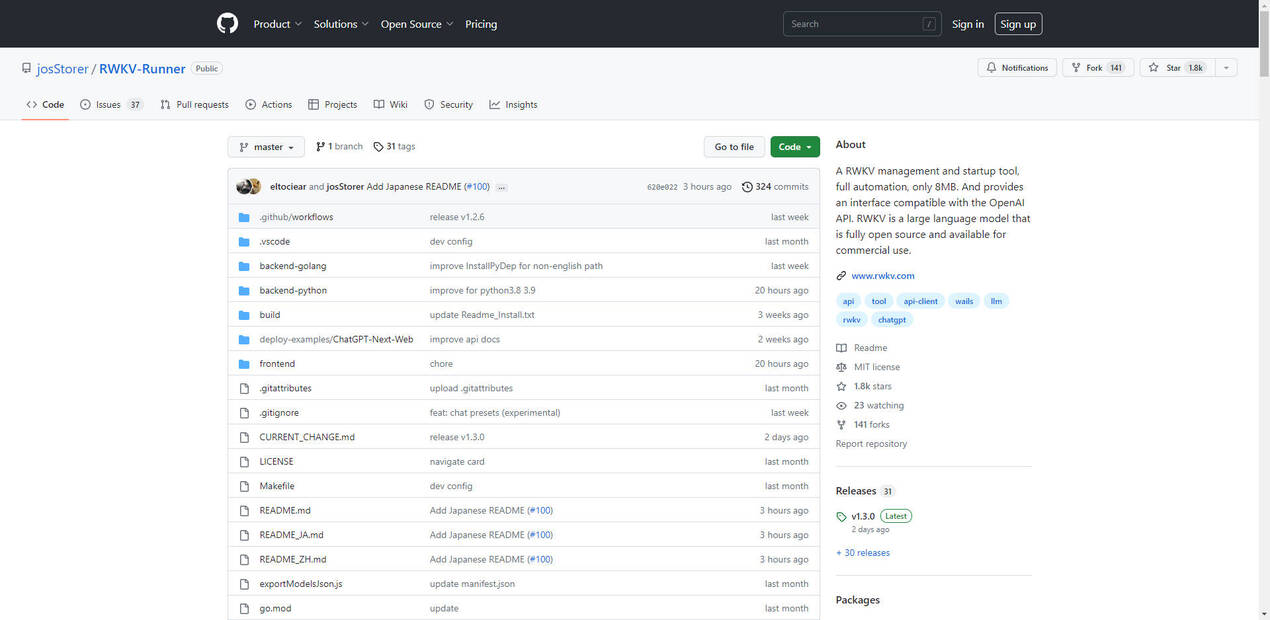

What is RWKV-Runner?

RWKV 관리 및 시작 도구는 RWKV 언어 모델의 배포 및 운영을 간소화하도록 설계된 경량의 완전 자동화 솔루션입니다. 8MB에 불과한 이 도구는 OpenAI API와의 원활한 통합을 제공하여 비용 효율적이고 고성능의 기존 트랜스포머 모델 대안을 찾는 개발자와 기업에게 이상적인 선택이 됩니다. RWKV는 RNN과 트랜스포머의 장점을 결합하여 빠른 추론, 낮은 리소스 사용량 및 모든 컨텍스트 길이에 대한 확장성을 제공합니다. 완전히 오픈 소스이며 상업적으로 사용 가능한 RWKV는 활발한 커뮤니티의 지원을 받고 Linux Foundation의 후원을 받습니다.

주요 기능:

?️ 경량 및 효율성

단 8MB로, 이 도구는 높은 성능을 유지하면서 최소한의 리소스 소비를 보장하여 하드웨어 성능이 제한적인 장치에도 적합합니다.? OpenAI API 호환성

이 도구는 OpenAI API와 원활하게 통합되는 인터페이스를 제공하여 사용자가 기존 워크플로를 다시 작성하지 않고도 RWKV의 기능을 활용할 수 있도록 합니다.⚡ 빠른 추론 및 학습

RWKV의 아키텍처는 RNN의 속도와 트랜스포머의 성능을 결합하여 기존 모델에 비해 10배에서 100배까지 낮은 컴퓨팅 요구 사항을 제공합니다.? 확장 가능한 컨텍스트 길이

트랜스포머와 달리 RWKV는 컨텍스트 길이에 따라 선형적으로 확장되므로 성능 저하 없이 장문의 콘텐츠를 처리할 수 있습니다.? 오픈 소스 및 상업적 사용 가능

Apache 2.0 라이선스에 따라 RWKV는 개인 및 상업적 용도로 모두 무료이며 커뮤니티 중심 개발 모델에 의해 지원됩니다.

사용 사례:

AI 기반 챗봇

개발자는 RWKV를 사용하여 빠른 응답 시간과 낮은 리소스 사용량으로 챗봇을 구축할 수 있으며, 고객 지원 또는 대화형 애플리케이션에 이상적입니다.다국어 콘텐츠 생성

중국어와 일본어와 같은 언어에서 RWKV의 강력한 성능은 현지화된 콘텐츠를 생성하거나 문서를 번역하는 데 유용한 도구입니다.연구 및 실험

연구자는 RWKV의 오픈 소스 특성과 낮은 컴퓨팅 요구 사항을 활용하여 사용자 지정 언어 모델을 실험하거나 특정 작업에 대해 기존 모델을 미세 조정할 수 있습니다.

결론:

RWKV 관리 및 시작 도구는 기존 트랜스포머의 무거운 리소스 요구 사항 없이 대규모 언어 모델의 성능을 활용하려는 개발자와 기업에게 획기적인 변화를 가져다줍니다. 경량 설계, OpenAI API 호환성 및 오픈 소스 라이선스는 광범위한 애플리케이션에 대한 다용도적이고 비용 효율적인 솔루션을 제공합니다. 챗봇을 구축하든, 다국어 콘텐츠를 생성하든, 연구를 수행하든 RWKV는 필요한 성능과 유연성을 제공합니다.