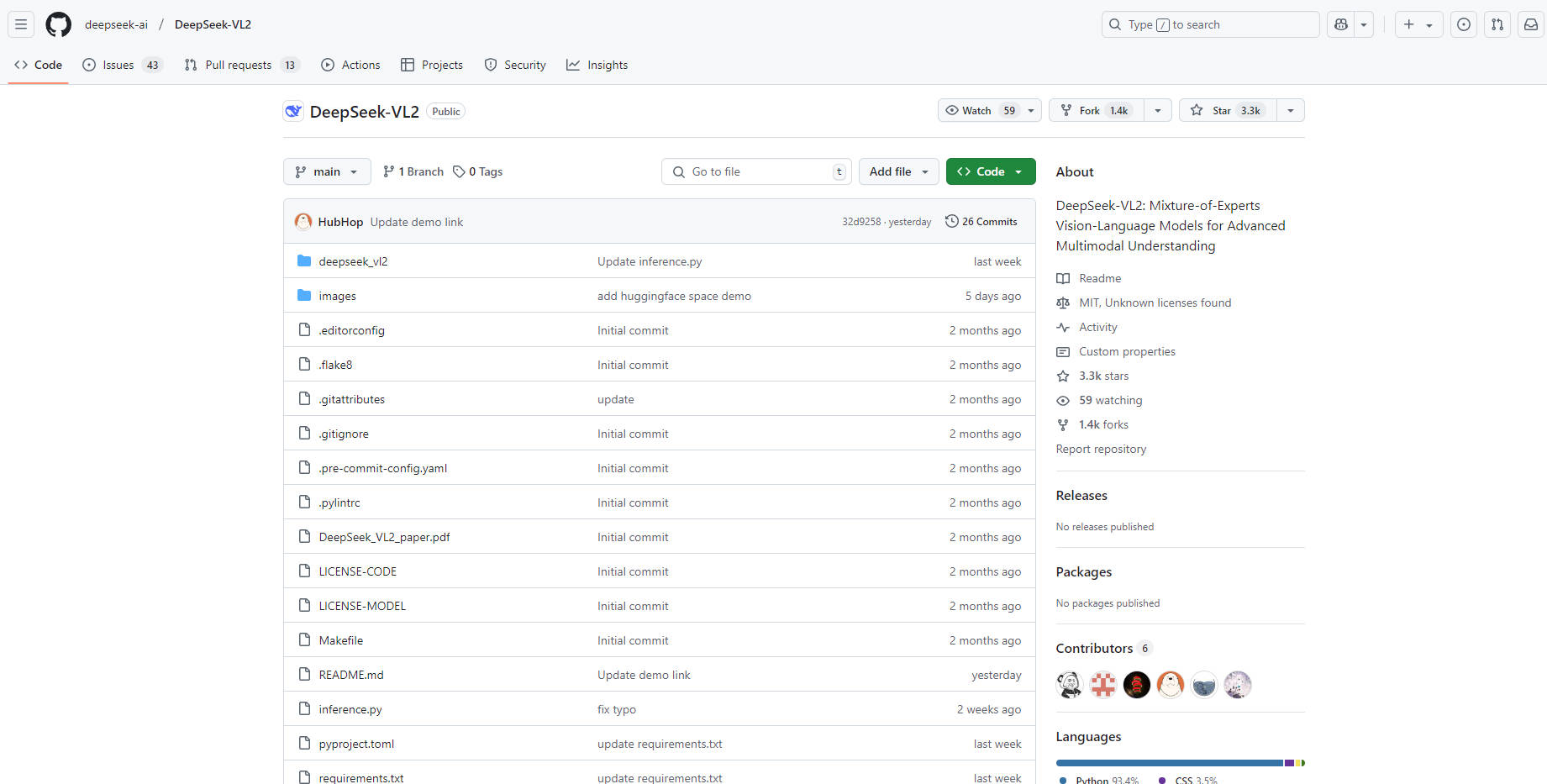

What is DeepSeek-VL2?

想象一下这样一个世界:你的人工智能能够真正像你一样“看见”并理解周围的世界。这正是DeepSeek-AI推出的全新视觉语言模型系列DeepSeek-VL2所带来的愿景。它不仅仅是识别图像,更能理解复杂的视觉信息,从详细的图表和文档到现实场景,并以自然、直观的方式回答你关于这些内容的问题。无论你是研究人员、开发者,还是想要挖掘视觉数据潜力的普通人,DeepSeek-VL2都旨在助你实现更多目标。

主要特性:

🎯 采用动态分块策略处理高分辨率图像:DeepSeek-VL2不会受限于固定的图像尺寸,而是能智能地将高分辨率图像分割成更小、更易处理的“图块”。这意味着你可以向它输入详细的视觉内容,而无需担心计算瓶颈或丢失关键细节。对你而言,这将带来更高的准确性,并为分析图形或插图等复杂材料打开大门。

🧠 借助多头潜在注意力机制(MLA)实现更快响应:我们都看重速度。DeepSeek-VL2利用MLA显著减少处理时间,它通过浓缩关键信息来实现这一点。无论你是在分析大型数据集还是构建交互式应用程序,这都能转化为更快的响应和更高效的工作流程。

⚖️ 受益于优化的语言模型架构:基于强大的DeepSeekMoE模型,它在准确性和效率之间取得了平衡。该模型有三种规格(Tiny、Small和Base)可供选择,以满足你的需求。你可以灵活地为特定项目选择性能和资源使用的最佳平衡点。

📊 支持处理多种数据源:DeepSeek-VL2在丰富的数据集上进行训练,涵盖从图像描述到视觉问答等各种内容。这意味着它能够应对广泛的数据类型和分析需求。

👁️🗨️ 擅长多项任务,包括文档和图表理解:DeepSeek-VL2的能力远不止简单的图像识别。它擅长视觉问答(VQA)、光学字符识别(OCR)等任务,甚至能够理解复杂文档、表格和图表的内容。无需再手动提取数据,让模型为你完成繁重的工作。

应用场景:

商业智能分析师:想象一下你正在分析市场趋势。无需手动仔细研究无数的图表,只需将它们输入到DeepSeek-VL2中并提问:“第三季度销售额最高的地区是哪个,与第二季度相比增长了多少百分比?”你将立即获得准确的答案,从而能够更快地做出基于数据的决策。

研究人员/学者:你正在处理大量历史文档数据集,其中许多是手写的。DeepSeek-VL2强大的OCR功能可以快速准确地转录这些文档,为你节省大量的手动工作时间,使你能够专注于分析工作。

应用程序开发者:你正在开发一款帮助用户识别周围物体的移动应用程序。DeepSeek-VL2提供视觉理解引擎,使你的应用不仅能够识别物体,还能回答关于它们的问题(“这是什么类型的树?”)。这将为用户带来更丰富、更具交互性的体验。

总结:

DeepSeek-VL2不仅仅是另一个视觉语言模型,它是迈向更具视觉智能和易用性人工智能的重要一步。其动态图像处理、高效注意力机制和强大语言模型的结合,为用户提供了一个适用于广泛视觉理解任务的多功能工具。通过赋予人工智能真正“看见”的能力,DeepSeek-VL2正在为各个领域开辟新的可能性。

常见问题解答

什么是视觉语言模型(VLM)?视觉语言模型是一种能够理解和处理图像与文本的人工智能模型。这使得它能够执行需要理解视觉信息并将其与文本描述或问题相关联的任务。

DeepSeek-VL2-Tiny、Small和Base有什么区别?DeepSeek-VL2有三种变体,每种变体的模型大小和激活参数不同。所有模型都设计为高效运行,激活参数较低。这三种变体分别是:DeepSeek-VL2-Tiny、DeepSeek-VL2-Small和DeepSeek-VL2,激活参数分别为10亿、28亿和45亿。

DeepSeek-VL2能否处理模糊图像?DeepSeek-VL2经过训练,具有较强的鲁棒性。虽然在清晰图像上的性能最佳,但它仍能从适度模糊的图像中提取有用信息,DeepSeek-AI团队将专注于进一步改进。