LMCache

| Launched | 2024-10 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,cdnjs,Cloudflare CDN,Fastly,Google Fonts,GitHub Pages,Gzip,HTTP/3,Varnish |

| Tag | Infrastructure,Data Pipelines,Developer Tools |

VLLM

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Software Development,Data Science |

LMCache Rank/Visit

| Global Rank | 475554 |

| Country | China |

| Month Visit | 59830 |

Top 5 Countries

31.32%

26.42%

12.18%

6.77%

5.78%

China

United States

India

Hong Kong

Korea, Republic of

Traffic Sources

6.12%

0.99%

0.14%

13.7%

27.62%

51.36%

social

paidReferrals

mail

referrals

search

direct

VLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

When comparing LMCache and VLLM, you can also consider the following products

GPTCache - ChatGPT 和各種大型語言模型 (LLM) 擁有令人難以置信的多功能性,可以開發廣泛的應用程式。

LazyLLM - LazyLLM: 專為多代理式LLM應用程式打造的低程式碼平台。快速建構、疊代並部署複雜的AI解決方案,從原型開發到正式部署一氣呵成。將重心放在演算法的創新,而非繁瑣的工程細節。

Supermemory - Supermemory 賦予您的 LLM 長期記憶。有別於過往的無狀態文字生成模式,LLM 現在能從您的檔案、對話紀錄與工具中,精準地提取所需資訊,讓回應更為連貫、符合情境,且充滿個人色彩。

LM Studio - LM Studio 是一款操作簡便的桌面應用程式,讓您能輕鬆體驗本地與開源的大型語言模型(LLM)。這款 LM Studio 跨平台桌面應用程式,讓您可以從 Hugging Face 下載並運行任何 ggml-相容的模型,並提供簡潔而強大的模型配置與推論介面。該應用程式會盡可能地運用您的 GPU 資源。

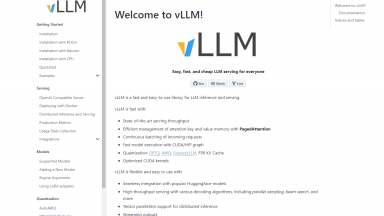

VLLM

VLLM