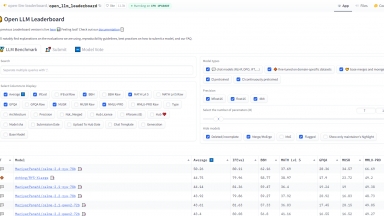

Huggingface's Open LLM Leaderboard

Huggingface's Open LLM Leaderboard

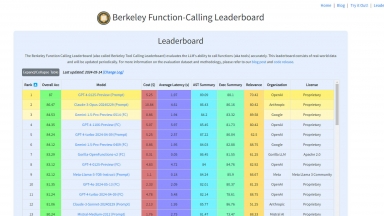

Berkeley Function-Calling Leaderboard

Berkeley Function-Calling Leaderboard

Huggingface's Open LLM Leaderboard

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Llm Benchmark Leaderboard,Data Analysis |

Berkeley Function-Calling Leaderboard

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,cdnjs,Fastly,Google Fonts,Bootstrap,GitHub Pages,Gzip,Varnish,YouTube |

| Tag | Llm Benchmark Leaderboard,Data Analysis,Data Visualization |

Huggingface's Open LLM Leaderboard Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Berkeley Function-Calling Leaderboard Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

Klu LLM Benchmarks - Los datos de Klu.ai en tiempo real impulsan esta tabla de clasificación para evaluar proveedores de LLM, permitiendo la selección de la API y el modelo óptimos para sus necesidades.

LiveBench - LiveBench es un punto de referencia para LLM con nuevas preguntas mensuales de diversas fuentes y respuestas objetivas para una puntuación precisa, actualmente con 18 tareas en 6 categorías y más por venir.

LLM Explorer - Descubra, compare y clasifique Large Language Models sin esfuerzo con LLM Extractum. Simplifique su proceso de selección e impulse la innovación en aplicaciones de IA.

LightEval - LightEval es un conjunto de evaluación de LLM ligero que Hugging Face ha estado utilizando internamente con la biblioteca de procesamiento de datos de LLM recientemente lanzada datatrove y la biblioteca de entrenamiento de LLM nanotron.