LazyLLM

LazyLLM

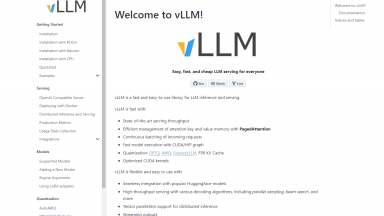

VLLM

VLLM

LazyLLM

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Low Code,Mlops |

VLLM

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Software Development,Data Science |

LazyLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

VLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

TaskingAI - TaskingAI aporta la simplicidad de Firebase al desarrollo de aplicaciones nativas de IA. Inicia tu proyecto seleccionando un modelo LLM, desarrolla un asistente responsivo respaldado por APIs con estado, y potencia sus capacidades con memoria gestionada, integraciones de herramientas y un sistema de generación aumentada.

liteLLM - Invocar todas las API de LLM utilizando el formato OpenAI. Usar Bedrock, Azure, OpenAI, Cohere, Anthropic, Ollama, Sagemaker, HuggingFace, Replicate (más de 100 LLM)

LM Studio - LM Studio es una aplicación de escritorio fácil de usar para experimentar con Modelos de Lenguaje Grandes (LLMs) locales y de código abierto. La aplicación de escritorio multiplataforma LM Studio permite descargar y ejecutar cualquier modelo compatible con ggml de Hugging Face, y proporciona una interfaz de usuario (UI) sencilla pero potente para la configuración e inferencia de modelos. La aplicación aprovecha tu GPU cuando es posible.

Laminar AI - Laminar es una plataforma para desarrolladores que combina orquestación, evaluaciones, datos y observabilidad para empoderar a los desarrolladores de IA a lanzar aplicaciones LLM confiables 10 veces más rápido.

Literal AI - Literal AI: Observabilidad y Evaluación para RAG y LLMs. Depura, monitoriza, optimiza el rendimiento y garantiza aplicaciones de IA listas para producción.