LLM Outputs

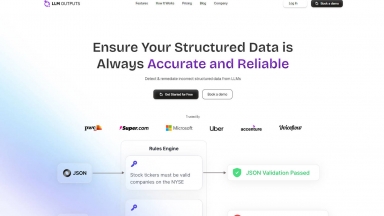

LLM Outputs

Gestell

Gestell

LLM Outputs

| Launched | 2024-08 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,Webflow,Amazon AWS CloudFront,Google Fonts,jQuery,Gzip,OpenGraph,HSTS |

| Tag | Data Analysis,Data Extraction,Data Enrichment |

Gestell

| Launched | 2024-09 |

| Pricing Model | Free Trial |

| Starting Price | |

| Tech used | Next.js,Vercel,Gzip,JSON Schema,OpenGraph,Progressive Web App,Webpack,HSTS |

| Tag | Data Pipelines,Data Integration,Data Science |

LLM Outputs Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Gestell Rank/Visit

| Global Rank | 5368258 |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

Deepchecks - Deepchecks: La plataforma integral para la evaluación de LLM. Ponga a prueba, compare y monitorice sistemáticamente sus aplicaciones de IA del desarrollo a la producción. Reduzca las alucinaciones y despliegue más rápido.

Confident AI - Las empresas de todos los tamaños utilizan Confident AI para justificar por qué su LLM merece estar en producción.

Traceloop - Traceloop es una herramienta de observabilidad para aplicaciones LLM. Monitoreo en tiempo real, pruebas retrospectivas, alertas instantáneas. Admite múltiples proveedores. Garantiza implementaciones LLM fiables.

LazyLLM - LazyLLM: Bajo código para aplicaciones LLM multiagente. Desarrolle, itere y despliegue soluciones de IA complejas con rapidez, desde el prototipo hasta la producción. Céntrese en los algoritmos, no en la ingeniería.

Humanloop - Administra tus solicitudes, evalúa tus cadenas, crea rápidamente aplicaciones de nivel de producción con Large Language Models.