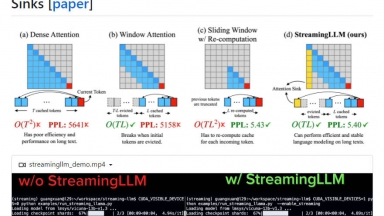

StreamingLLM

StreamingLLM

OneLLM

StreamingLLM

| Launched | 2024 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Workflow Automation,Developer Tools,Communication |

OneLLM

| Launched | 2024-03 |

| Pricing Model | Freemium |

| Starting Price | $19 /mo |

| Tech used | Next.js,Vercel,Gzip,OpenGraph,Webpack,HSTS |

| Tag | Text Analysis,No-Code,Data Analysis |

StreamingLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

OneLLM Rank/Visit

| Global Rank | 11268274 |

| Country | Germany |

| Month Visit | 87 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

vLLM - Un motor de inferencia y servicio de alto rendimiento y bajo consumo de memoria para LLM

EasyLLM - EasyLLM es un proyecto de código abierto que ofrece herramientas y métodos útiles para trabajar con modelos de lenguaje grande (LLM), tanto de código abierto como de código cerrado. Ponte en marcha de inmediato o echa un vistazo a la documentación.

LLMLingua - Para acelerar la inferencia de los LLM y mejorar la percepción de los LLM de información clave, comprime el indicador y KV-Cache, que logra una compresión de hasta 20 veces con una pérdida de rendimiento mínima.

LazyLLM - LazyLLM: Bajo código para aplicaciones LLM multiagente. Desarrolle, itere y despliegue soluciones de IA complejas con rapidez, desde el prototipo hasta la producción. Céntrese en los algoritmos, no en la ingeniería.

LMCache - LMCache es una red de entrega de conocimiento (KDN) de código abierto que acelera las aplicaciones LLM mediante la optimización del almacenamiento y la recuperación de datos.