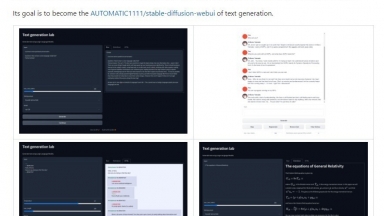

Text Generation WebUI

Text Generation WebUI

Text Generation WebUI

| Launched | 2023 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Text Generators |

Open WebUI

| Launched | 2024-2 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,Svelte(Kit),Gravatar,Gzip,Nginx,Ubuntu |

| Tag | Web Design,Chrome Extension |

Text Generation WebUI Rank/Visit

| Global Rank | 0 |

| Country | |

| Month Visit | 0 |

Top 5 Countries

Traffic Sources

Open WebUI Rank/Visit

| Global Rank | 63556 |

| Country | United States |

| Month Visit | 792629 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

Text Generator Plugin - Descubre cómo TextGen revoluciona las tareas de generación de idioma con una compatibilidad amplia de modelos. Crea contenido, desarrolla chatbots y aumenta los conjuntos de datos sin esfuerzo.

LoLLMS Web UI - LoLLMS WebUI: Accede y utiliza modelos LLM para escribir, codificar, organizar datos, generar imágenes y música, ¡y mucho más! ¡Pruébalo ahora!

ChattyUI - Interfaz de código abierto, rica en funciones, similar a Gemini/ChatGPT para ejecutar modelos de código abierto (Gemma, Mistral, LLama3, etc.) localmente en el navegador utilizando WebGPU. ¡Sin procesamiento del lado del servidor: tus datos nunca abandonan tu PC!

LLMLingua - Para acelerar la inferencia de los LLM y mejorar la percepción de los LLM de información clave, comprime el indicador y KV-Cache, que logra una compresión de hasta 20 veces con una pérdida de rendimiento mínima.

Open WebUI

Open WebUI