What is Poml?

POML (Prompt Orchestration Markup Language) introduce un enfoque estructurado y declarativo para construir prompts sofisticados para Modelos de Lenguaje Grandes (LLMs). Si alguna vez ha tenido dificultades para gestionar prompts complejos como bloques de texto y código desordenados y difíciles de mantener, POML ofrece una solución clara. Está diseñado para desarrolladores e ingenieros de prompts que necesitan crear aplicaciones LLM fiables, escalables y versátiles.

Características Clave

✍️ Prompts Estructurados y Modulares POML utiliza una sintaxis clara, similar a HTML, con componentes como

<role>,<task>y<example>. Esto le anima a desglosar prompts complejos en partes lógicas y reutilizables, lo que los hace mucho más fáciles de leer, depurar y mantener con el tiempo.🎨 Estilado de Presentación Desacoplado Aprovechando un sistema similar a CSS, POML separa la lógica central de su prompt de su presentación final. Esto le permite experimentar con diferentes formatos de salida (por ejemplo, JSON vs. texto plano) o ajustar la verbosidad simplemente cambiando una hoja de estilo, todo sin modificar el contenido subyacente del prompt. Esto mitiga directamente la sensibilidad de un LLM a los cambios de formato.

🔗 Integración de Datos Fluida Integre o referencie sin esfuerzo fuentes de datos externas directamente en sus prompts. Con componentes dedicados como

<img>,<table>y<document>, puede integrar imágenes, datos CSV o archivos de texto sin un formato manual torpe, asegurando que sus prompts sean potentes y limpios.⚙️ Herramientas y Plantillas Integradas POML incluye un motor de plantillas integrado para crear prompts dinámicos y basados en datos utilizando variables, bucles y condicionales. Combinado con una extensión completa para VS Code y SDKs para Python y Node.js, se obtiene un entorno de desarrollo completo y profesional con resaltado de sintaxis, autocompletado y pruebas integradas.

Casos de Uso:

Generación Dinámica de Contenido Basado en Datos Imagine que necesita generar un resumen de ventas semanal. Con POML, puede crear una única plantilla de prompt que acepte una hoja de cálculo de ventas a través del componente

<table>. El prompt puede entonces usar el motor de plantillas para iterar a través de los datos, realizar cálculos y generar un informe narrativo perfectamente formateado, transformando una tarea manual en un flujo de trabajo automatizado.Pruebas A/B de Formatos de Prompt Suponga que desea determinar si un LLM ofrece mejores resultados con una lista con viñetas o un objeto JSON. En lugar de escribir dos prompts separados y codificados, puede usar un único archivo POML para su lógica central y dos hojas de estilo diferentes. Esto le permite probar y comparar rápidamente los formatos de salida para encontrar la estructura más efectiva para su tarea específica.

Instrucciones Complejas y Multimodales Para una tarea como la creación de material educativo, puede combinar múltiples entradas con facilidad. Un prompt de POML podría definir una persona (

<role>Eres un profesor paciente...</role>), establecer un objetivo (<task>Explica este diagrama...</task>) e incluir una referencia visual (<img src="diagram.png" />), todo en un único archivo estructurado y legible por humanos.

¿Por qué elegir POML?

Claridad Sobre Concatenación: Mientras que la ingeniería de prompts tradicional a menudo implica una manipulación desordenada de cadenas directamente en el código de su aplicación, POML ofrece un lenguaje de marcado limpio y declarativo. Esto separa la lógica de su prompt de la lógica de su aplicación, lo que resulta en un código significativamente más fácil de leer y mantener.

Resiliencia Mediante el Desacoplamiento: A diferencia de las simples librerías de plantillas, POML desacopla de forma única el contenido del prompt de su presentación. Esto significa que puede adaptarse a la "sensibilidad al formato" de diferentes LLMs modificando una hoja de estilo, y no reescribiendo la lógica central de su prompt, una ventaja crucial para construir aplicaciones robustas e independientes del modelo.

Un Flujo de Trabajo Integrado, No Solo una Sintaxis: En lugar de un proceso fragmentado de escribir prompts en un lugar y probarlos en otro, POML proporciona una experiencia de desarrollo unificada. La extensión de VS Code ofrece vistas previas en tiempo real, verificación de errores y pruebas interactivas, creando un flujo de trabajo fluido y eficiente desde la creación hasta la implementación.

Conclusión:

POML transforma la ingeniería de prompts de un oficio de manipulación de cadenas en una disciplina estructurada y escalable. Al proporcionar las herramientas para construir, probar y mantener prompts complejos con claridad y confianza, le permite crear aplicaciones de IA más robustas y sofisticadas.

¡Explore la documentación oficial o vea el video de demostración para comenzar!

Preguntas Frecuentes

1. ¿Cómo empiezo a usar POML? La forma más sencilla de empezar es instalando la extensión POML directamente desde el Visual Studio Code Marketplace. Esto proporciona resaltado de sintaxis, autocompletado y pruebas integradas. También puede instalar los SDKs para Python (pip install poml) o Node.js para integrar POML en sus aplicaciones.

2. ¿Necesito una clave API de LLM para usar la extensión de VS Code? Para características como el resaltado de sintaxis y el autocompletado, no necesita una clave API. Sin embargo, para utilizar las funciones integradas de prueba de prompts y vista previa en tiempo real, debe configurar su proveedor de LLM (por ejemplo, OpenAI, Azure, Google), clave API y endpoint en la configuración de VS Code.

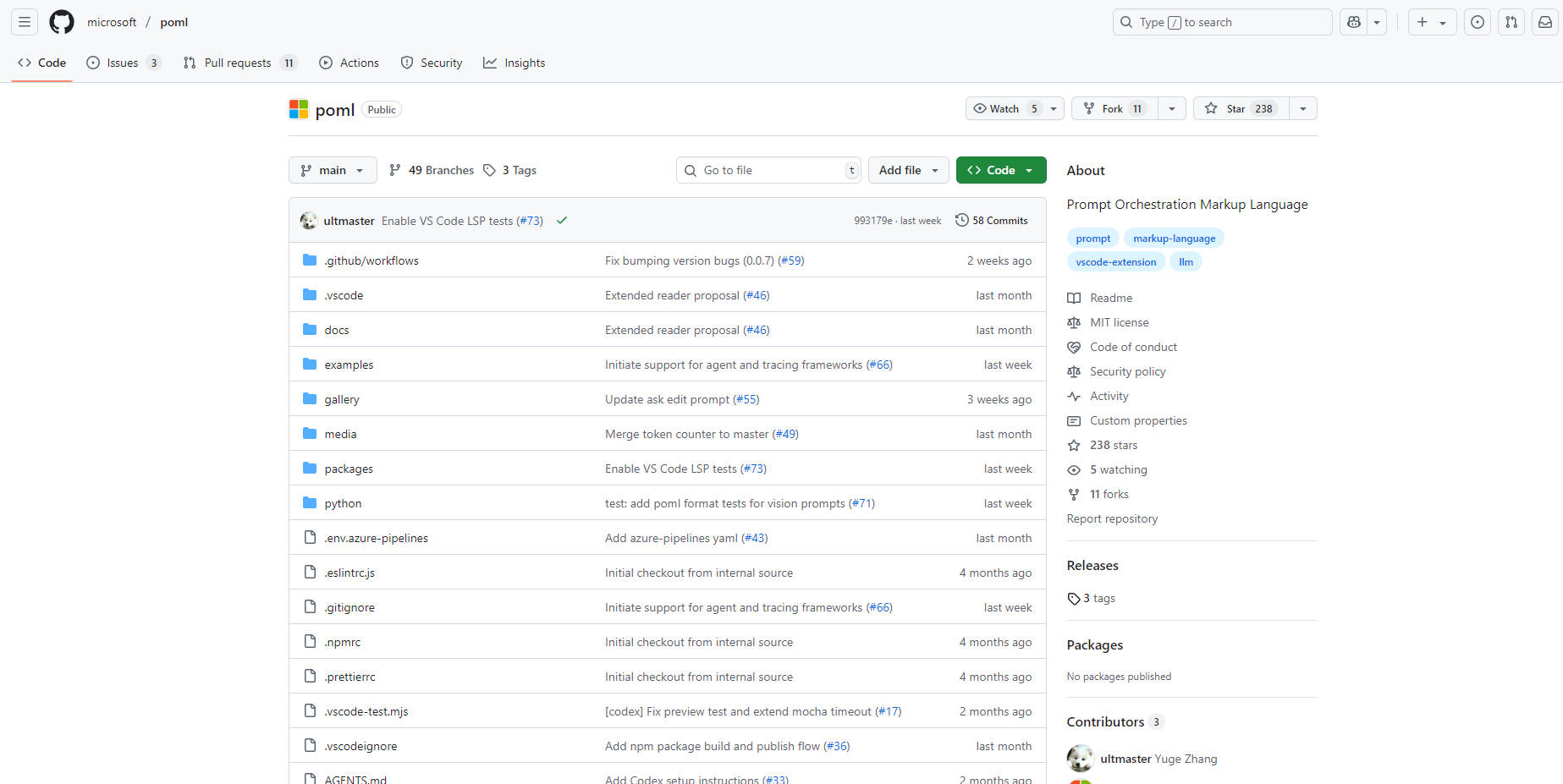

3. ¿Es POML un proyecto de código abierto? Sí, POML es un proyecto de código abierto lanzado bajo el Microsoft Open Source Code of Conduct. El proyecto acepta contribuciones y ha sido evaluado para cumplir con el Microsoft Responsible AI Standard.

More information on Poml

Poml Alternativas

Más Alternativas-

-

La plataforma líder para crear, probar e implementar tareas y API impulsadas por grandes modelos de lenguaje. Eleva tus soluciones de IA hoy.

-

-

PromptTools es una plataforma de código abierto que ayuda a los desarrolladores a construir, monitorizar y mejorar aplicaciones de LLM mediante la experimentación, la evaluación y la retroalimentación.

-

Optimice la ingeniería de prompts para LLM. PromptLayer ofrece gestión, evaluación y observabilidad en una única plataforma. Cree una IA mejor, más rápido.