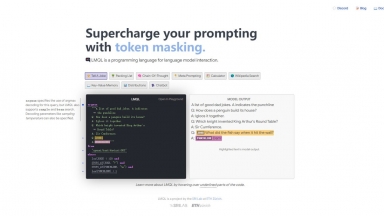

LMQL

LMQL

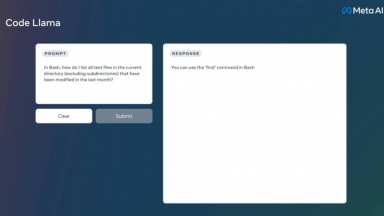

Code Llama

Code Llama

LMQL

| Launched | 2022-11 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Cloudflare Analytics,Fastly,Google Fonts,GitHub Pages,Highlight.js,jQuery,Varnish |

| Tag | Text Analysis |

Code Llama

| Launched | 1991-01 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Gzip,HTTP/3,OpenGraph,HSTS |

| Tag | Code Generation,Software Development,Developer Tools |

LMQL Rank/Visit

| Global Rank | 2509184 |

| Country | United States |

| Month Visit | 8348 |

Top 5 Countries

Traffic Sources

Code Llama Rank/Visit

| Global Rank | 0 |

| Country | United States |

| Month Visit | 1064466 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

LM Studio - LM Studio est une application de bureau intuitive, conçue pour faciliter l'expérimentation avec les Large Language Models (LLM) locaux et open-source. Cette application multiplateforme vous offre la possibilité de télécharger et d'exécuter n'importe quel modèle compatible ggml directement depuis Hugging Face. Elle intègre une interface utilisateur (UI) pour la configuration et l'inférence des modèles, se distinguant par sa simplicité d'accès et sa puissance. De plus, elle tire pleinement parti de votre GPU lorsque les conditions le permettent.

LLMLingua - Pour accélérer l'inférence LLM et améliorer la perception des informations clés de LLM, compressez l'invite et KV-Cache, ce qui permet d'obtenir une compression jusqu'à 20x avec une perte de performance minimale.

LazyLLM - LazyLLM : Le low-code pour les applications LLM multi-agents. Créez, itérez et déployez rapidement des solutions d'IA complexes, du prototype à la production. Concentrez-vous sur les algorithmes, et non sur l'ingénierie.

vLLM - Un moteur d'inférence et de service à haut débit et économe en mémoire pour les LLM

LLM-X - Révolutionnez le développement LLM avec LLM-X ! Intégrez des modèles de langage volumineux en toute transparence dans votre workflow grâce à une API sécurisée. Optimisez la productivité et libérez la puissance des modèles de langage pour vos projets.