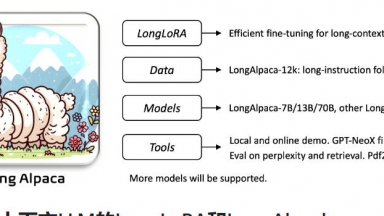

LongLoRA

LongLoRA

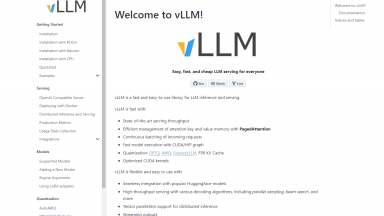

VLLM

VLLM

LongLoRA

| Launched | 2024 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Text Generators,Code Generation,Developer Tools |

VLLM

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Software Development,Data Science |

LongLoRA Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

VLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

LLMLingua - Pour accélérer l'inférence LLM et améliorer la perception des informations clés de LLM, compressez l'invite et KV-Cache, ce qui permet d'obtenir une compression jusqu'à 20x avec une perte de performance minimale.

PolyLM - PolyLM, un modèle linguistique révolutionnaire polyglote, prend en charge 18 langues, excelle dans diverses tâches et est open-source. Idéal pour les développeurs, les chercheurs et les entreprises ayant des besoins multilingues.

LongWriter - LongWriter, un modèle linguistique révolutionnaire de l'Université Tsinghua, génère jusqu'à 20 000 mots. Idéal pour les écrivains, les journalistes et bien plus encore. Améliore l'efficacité et la qualité de la création de contenu.

TinyLlama - Le projet TinyLlama est une initiative ouverte visant à pré-entraîner un modèle Llama de 1,1 milliard de paramètres sur 3 trillions de jetons.