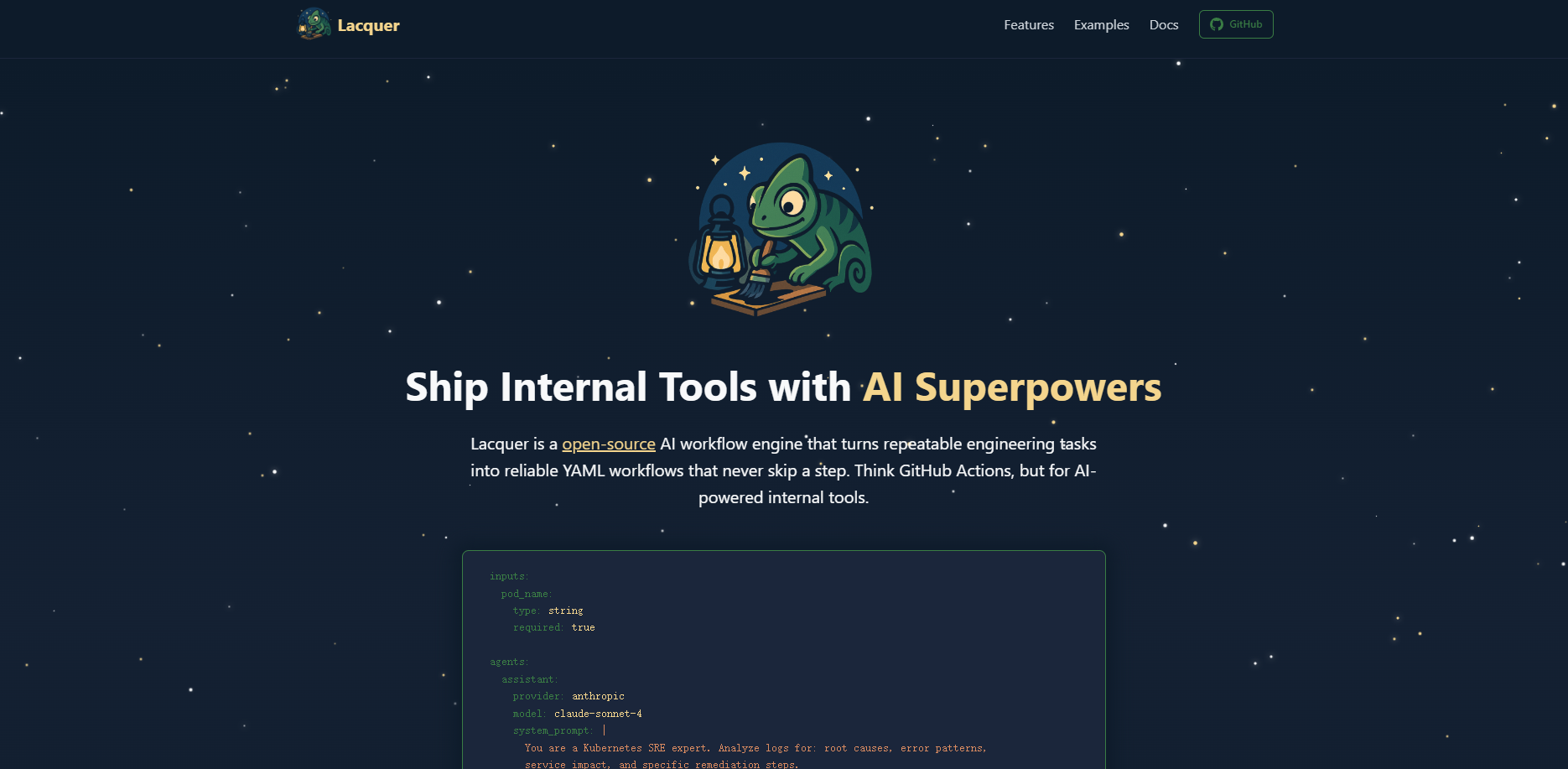

What is Lacquer?

Lacquer est un moteur de flux de travail d'IA open-source, conçu pour les ingénieurs désireux d'automatiser des tâches complexes et répétitives grâce à une boîte à outils pensée pour les développeurs. Il vous permet de créer des outils internes fiables, basés sur l'IA, en utilisant les mêmes principes GitOps que ceux que vous appliquez à votre code d'application. Pensez-y comme à GitHub Actions, mais spécifiquement conçu pour orchestrer des agents IA au sein de votre propre infrastructure.

Fonctionnalités Clés

Lacquer offre les fonctionnalités essentielles pour construire, tester et déployer des automatisations IA de qualité production.

↔️ Conçu pour le GitOps dès l'origine : Vos workflows sont définis dans de simples fichiers YAML déclaratifs. Cela signifie que vous pouvez committer, versionner et réviser vos automatisations par les pairs, tout comme n'importe quelle autre partie de code, apportant prévisibilité et auditabilité à vos outils internes.

💻 Développement local d'abord, sans dépendances : Lacquer est un binaire Go unique et léger, sans aucune dépendance externe. Vous pouvez construire et tester des workflows entiers sur votre ordinateur portable sans avoir besoin d'un compte cloud ni de jongler avec des environnements Python complexes, garantissant un cycle de développement fluide.

🤖 Orchestration multi-agents avancée : Définissez et combinez plusieurs agents IA au sein d'un même workflow. Vous pouvez attribuer différents modèles (par exemple, Claude d'Anthropic pour l'analyse, les modèles d'OpenAI pour la génération), des invites système (system prompts) et des outils à chaque agent, vous permettant d'utiliser le meilleur outil pour chaque étape de la tâche.

⚙️ Flux de contrôle puissant et familier : Grâce à un DSL qui semblera immédiatement familier à quiconque a déjà utilisé GitHub Actions, vous pouvez créer des workflows véritablement dynamiques. Mettez en œuvre une exécution conditionnelle basée sur les sorties des étapes précédentes ou créez des boucles qui s'exécutent jusqu'à ce qu'une condition spécifique soit remplie.

Cas d'utilisation

Diagnostic automatisé des pods Kubernetes : Lorsqu'un pod est en échec, vous pouvez déclencher un workflow Lacquer qui récupère automatiquement les derniers logs, filtre les erreurs et les transmet à un agent IA préconfiguré en tant qu'expert Kubernetes. L'agent analyse les logs pour identifier la cause première, vérifier les schémas d'erreur et renvoie un ensemble d'étapes de remédiation spécifiques, réduisant ainsi considérablement votre temps moyen de résolution (MTTR).

Surveillance et remédiation intelligentes de l'état des services : Créez un workflow qui s'exécute selon un calendrier pour vérifier les métriques de santé clés d'un service. Si le workflow détecte un taux d'erreur supérieur à un seuil défini (par exemple, 5 %), il peut déclencher conditionnellement une série d'actions automatisées, telles que la mise à l'échelle du déploiement (scaling up), l'exécution d'un redémarrage glissant (rolling restart), puis la revérification de l'état du service après le redémarrage.

Pourquoi choisir Lacquer ?

Pour les équipes d'ingénierie, la création d'automatisations IA implique souvent des compromis avec des plateformes sans code qui ne correspondent pas au workflow d'un développeur. Lacquer repose sur une philosophie différente.

Vous travaillez avec du code, pas des interfaces utilisateur : Oubliez les interfaces glisser-déposer qui ne peuvent pas être versionnées. Avec Lacquer, toute votre automatisation est transparente, auditable et réside dans votre dépôt Git.

Vous gagnez en contrôle et en extensibilité : Contrairement aux systèmes "boîte noire", Lacquer est open-source et conçu pour être étendu. Vous pouvez créer vos propres outils personnalisés dans n'importe quel langage pour doter vos agents IA de nouvelles capacités, garantissant que le système s'adapte à vos besoins uniques.

Vous développez plus vite et déployez partout : La capacité à exécuter et tester tout localement élimine les frictions de déploiement. Une fois prêt, le binaire autonome peut être déployé facilement sur Kubernetes, dans des environnements serverless ou sur une machine virtuelle standard.

Démarrez en quelques minutes

Lacquer est conçu pour apporter de la valeur immédiatement. Vous pouvez passer de l'installation à l'exécution de votre premier workflow alimenté par l'IA en moins d'une minute. Explorez la documentation et consultez le projet sur GitHub pour découvrir comment Lacquer peut optimiser vos opérations d'ingénierie internes.

More information on Lacquer

Lacquer Alternatives

Plus Alternatives-

-

Créez rapidement des agents d'IA personnalisés avec Open Agent Kit ! Open source, flexible et déployable partout. Connectez des LLM et étendez les fonctionnalités avec des plugins.

-

Openlayer : Gouvernance et observabilité unifiées de l'IA pour le Machine Learning et l'IA générative en entreprise. Garantissez la confiance, la sécurité et la conformité ; prévenez les injections de prompts et les fuites de données personnelles identifiables. Déployez l'IA en toute confiance.

-

-

Laminar est une plateforme de développement qui combine l'orchestration, les évaluations, les données et l'observabilité pour permettre aux développeurs d'IA de déployer des applications LLM fiables 10 fois plus rapidement.