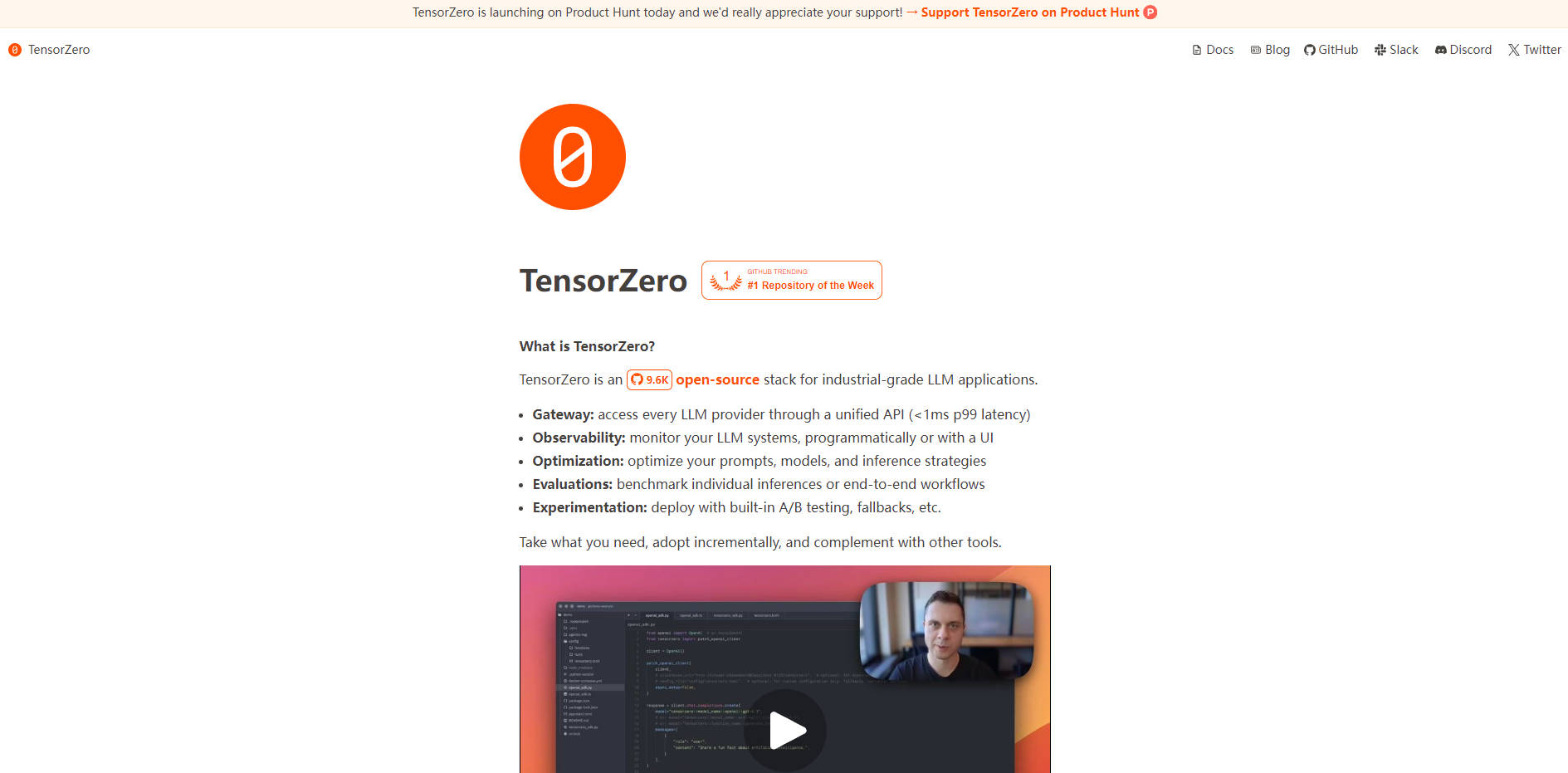

What is TensorZero?

TensorZeroは、高度なLLMアプリケーションを構築する開発者向けに設計された、オープンソースで産業グレードのスタックです。統一された高性能ツールキットを提供し、プロトタイプから本番環境への移行を確実に行えるよう支援します。LLMOpsライフサイクルのあらゆる重要なコンポーネントを統合することで、TensorZeroは強力なフィードバックループを構築し、本番データから、よりスマートで、より高速、かつ費用対効果の高いモデルを生み出すことを可能にします。

Key Features

🌐 Unified LLM Gateway: OpenAI、Anthropic、Groqといった主要なLLMプロバイダー、またはセルフホスト型モデルに、単一で一貫性のあるAPIを介してアクセスできます。Rustで構築されたこのゲートウェイは、極めて高いパフォーマンス(p99レイテンシオーバーヘッド1ms未満)を実現するように設計されており、大規模なアプリケーションでも高速性と応答性を維持します。

🔍 Integrated Observability: すべての推論、メトリクス、ユーザーフィードバックを独自のデータベースに自動的に保存・分析します。TensorZero UIを使用して個々の呼び出しをデバッグしたり、高レベルな傾向を監視したりすることで、アプリケーションのパフォーマンスと動作の全体像を把握できます。

📈 Data-Driven Optimization: 本番環境のメトリクスと人間のフィードバックを活用して洞察を行動に移し、システムを体系的に改善します。TensorZeroは、教師ありファインチューニング、自動プロンプトエンジニアリング、高度な推論戦略を促進し、モデルの精度向上と運用コスト削減に貢献します。

📊 Robust Evaluation Framework: プロンプト、モデル、構成をベンチマークすることで、情報に基づいた意思決定を行えます。ヒューリスティクス、LLM駆動の評価者、またはカスタムロジックを使用して、AIワークフローのユニットテストや統合テストのように機能する評価を実行できます。

🧪 Confident Experimentation: 組み込みのA/Bテスト、戦略的ルーティング、自動フォールバックにより、新機能やモデルを安全に展開できます。これにより、変更点をすべてのユーザーに展開する前に、実世界のデータで検証することが可能です。

Use Cases

Dramatically Reduce API Costs: アプリケーションがデータ抽出のために大規模で高価なモデルに依存しているとします。TensorZeroを使用すると、本番環境から少量の高品質なデータセットを収集し、ファインチューニングツールを使用してはるかに小規模なモデル(GPT-4o Miniなど)を訓練できます。その結果、特定のタスクにおいて、より大きなモデルを上回り、コストとレイテンシを大幅に削減できるモデルが実現します。

Build a Reliable Research Agent: 複数の情報源を検索して複雑な質問に回答する、エージェント型RAGシステムを開発しているとします。TensorZeroのオブザーバビリティ機能により、クエリごとのエージェントの推論プロセス全体を追跡できます。失敗した場合は、正確なステップを特定し、その動作を修正し、そのインタラクションを評価データセットに追加することで、将来的なデグレードを防ぐことができます。

Align a Model to Nuanced Preferences: 特定の主観的なスタイルに合致するクリエイティブなコンテンツ(俳句など)を生成することが目標だとします。生成されたコンテンツに対するユーザーフィードバックを収集することで、選好データセットを作成し、それを使用してベースモデルをファインチューニングできます。TensorZeroの統合スタックは、この「データの好循環」を継続的に機能させ、モデルの出力を望む嗜好に段階的に合わせていきます。

Why Choose TensorZero?

耐久性があり、高品質なLLMシステム構築に注力するチームにとって、TensorZeroは、個別のツール群と比較して、いくつかの重要な利点を提供します。

A Truly Integrated Stack: TensorZeroは単なるツールのセットではなく、各コンポーネントが互いを強化し合う統一されたシステムです。例えば、オブザーバビリティモジュールを通じてログに記録されたデータは、評価データセットの作成に直接利用でき、それがモデルのファインチューニングのための洞察を生み出します。これらすべてが単一の、まとまりのあるワークフロー内で完結します。

Engineered for Production Demands: パフォーマンスは主要な設計原則です。Rustベースのゲートウェイは、高いスループット(10k+ QPS)でも最小限のレイテンシを保証します。スタック全体がセルフホスト型であるため、データ、セキュリティ、インフラストラクチャを完全に制御でき、GitOpsワークフローを完全にサポートします。

Completely Open-Source and Transparent: TensorZeroは、有料機能やベンダーロックインがなく、100%オープンソース(Apache 2.0)です。コードベースに完全にアクセスでき、必要に応じてカスタマイズ、拡張、統合する自由があるため、既存の技術環境に完全に適合します。

Conclusion

TensorZeroは、プロフェッショナルなLLMアプリケーションの構築とスケールに必要な重要なインフラストラクチャを提供します。LLMOpsライフサイクルを単一の高性能スタックに統合することで、実世界のデータに駆動される継続的な改善ループを構築することを可能にします。この原則に基づいたアプローチは、より信頼性が高く、インテリジェントで、効率的なAI製品を構築するのに役立ちます。

わずか5分で最初の本番環境対応LLMアプリケーションを展開するためのクイックスタートガイドをご覧ください。

Frequently Asked Questions (FAQ)

1. How much does TensorZero cost? 無料です。TensorZeroはApache 2.0ライセンスの下で100%フリーかつオープンソースです。セルフホスト型であるため、実行に選択したインフラストラクチャのコストのみが発生します。有料機能やエンタープライズライセンスはありません。

2. Is TensorZero ready for production use? はい。産業グレードのアプリケーション向けにゼロから設計されており、大規模な金融機関でのコード変更ログの自動化を含め、すでに本番環境で使用されています。

3. What languages and frameworks can I use with TensorZero? 主要なプログラミング言語からTensorZeroを統合できます。専用のPythonクライアント、任意のOpenAI SDK(PythonやNode.js用など)との互換性、およびその他のすべての環境向けの標準HTTP APIを提供します。