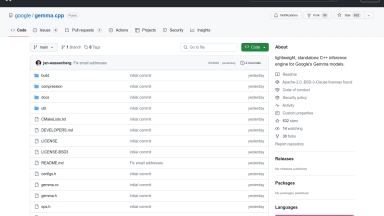

Gemma.cpp

Gemma.cpp

CodeGemma

CodeGemma

Gemma.cpp

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Code Generation,Data Analysis |

CodeGemma

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Coding Assistants,Code Autocomplete,Code Generation |

Gemma.cpp Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

CodeGemma Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

Google's open Gemma models - Gemma — это семейство легких открытых моделей, созданное на основе исследований и технологий, которые Google использовала для разработки моделей Gemini.

Gemma 2 - Gemma 2 предлагает лучшую в своем классе производительность, работает с невероятной скоростью на разных аппаратных платформах и легко интегрируется с другими инструментами ИИ, при этом в нее встроены значительные усовершенствования в области безопасности.

Gemma 3 - Gemma 3: открытая нейросеть от Google для создания мощных мультимодальных приложений. Разрабатывайте мультиязычные решения легко и просто, используя гибкие и безопасные модели.

Gemma 3 270M - Gemma 3 270M: Компактный, сверхэффективный ИИ для специализированных задач. Легко настраивается для точного выполнения команд и экономичного локального развертывания.