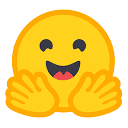

Huggingface's Open LLM Leaderboard

Huggingface's Open LLM Leaderboard

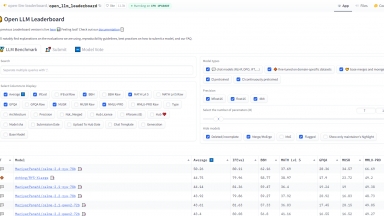

LightEval

LightEval

Huggingface's Open LLM Leaderboard

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Llm Benchmark Leaderboard,Data Analysis |

LightEval

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Data Science,Llm Benchmark Leaderboard,Developer Tools |

Huggingface's Open LLM Leaderboard Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

LightEval Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

Klu LLM Benchmarks - Данная таблица лидеров для оценки поставщиков LLM работает на основе данных Klu.ai в режиме реального времени, что позволяет выбрать оптимальный API и модель для ваших нужд.

Berkeley Function-Calling Leaderboard - Изучите таблицу лидеров вызова функций Беркли (также известную как таблица лидеров вызова инструментов Беркли), чтобы увидеть, насколько хорошо большие языковые модели могут вызывать функции (также называемые инструментами) с точностью.

LiveBench - LiveBench – это бенчмарк для больших языковых моделей (LLM) с ежемесячными новыми вопросами из различных источников и объективными ответами для точного оценивания. В настоящее время представлено 18 задач в 6 категориях, и в будущем их станет еще больше.

LLM Explorer - С легкостью находите, сравнивайте и ранжируйте крупные языковые модели с помощью LLM Extractum. Упростите процесс выбора и стимулируйте инновации в приложениях ИИ.