Yuan2.0-M32

Yuan2.0-M32

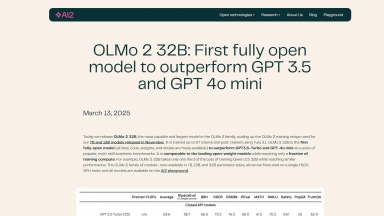

OLMo 2 32B

OLMo 2 32B

Yuan2.0-M32

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Code Generation,Answer Generators,Question Answering |

OLMo 2 32B

| Launched | 2010-12 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Next.js,Gzip,OpenGraph,Webpack,HSTS |

| Tag | Code Development,Software Development,Data Science |

Yuan2.0-M32 Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

OLMo 2 32B Rank/Visit

| Global Rank | 134275 |

| Country | United States |

| Month Visit | 364536 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

XVERSE-MoE-A36B - XVERSE-MoE-A36B: Многоязычная большая языковая модель, разработанная XVERSE Technology Inc.

JetMoE-8B - JetMoE-8B был обучен с затратами менее 0,1 миллиона долларов1, но превосходит LLaMA2-7B от Meta AI, которая имеет многомиллиардные ресурсы обучения. Обучение LLM может быть намного дешевле, чем обычно считается.

Qwen2.5-LLM - Языковые модели серии Qwen2.5 предлагают расширенные возможности благодаря более крупным наборам данных, большему объему знаний, улучшенным навыкам программирования и математики, а также более тесному соответствию человеческим предпочтениям. Открытый исходный код и доступны через API.

DeepSeek Chat - DeepSeek-V2: 236-миллиардная модель MoE. Передовые характеристики. Ультрадоступно. Несравненный опыт. Чат и API обновлены до последней модели.

Hunyuan-MT-7B - Hunyuan-MT-7B: Машинный перевод на базе ИИ с открытым исходным кодом. Поддерживает более 33 языков, обеспечивая непревзойденную контекстуальную и культурную точность. Победитель WMT2025, легковесный и эффективный.