What is Yuan2.0-M32?

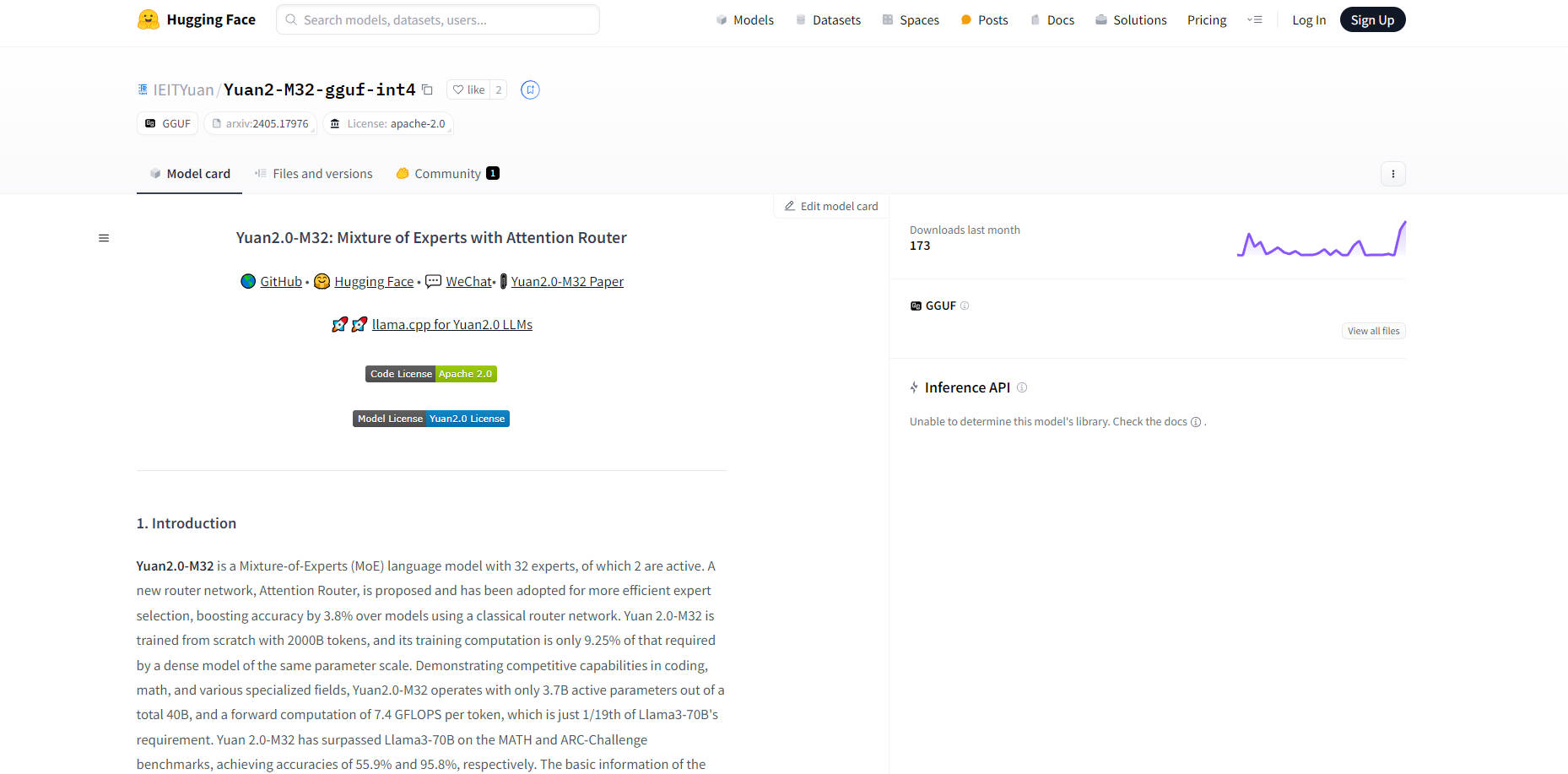

Yuan2.0-M32, новаторская языковая модель на основе смеси экспертов (MoE), сочетает в себе высокую эффективность с невероятной точностью благодаря своей новой сети маршрутизатора внимания. С всего 3,7 млрд активных параметров и 2 активными экспертами она превосходит модели аналогичного масштаба, демонстрируя передовые результаты на таких бенчмарках, как MATH и ARC-Challenge. Эта модель, с общим количеством параметров 40 млрд, была эффективно дообучена на 2000 млрд токенов, устанавливая новый стандарт вычислительной эффективности в области языковых моделей.

Ключевые особенности:

Сеть маршрутизатора внимания: Прорывная сеть маршрутизатора повышает эффективность выбора экспертов, увеличивая точность модели на 3,8% по сравнению с традиционными альтернативами.

Невероятная эффективность: Несмотря на общее количество параметров 40 млрд, активны только 3,7 млрд, что требует значительно меньших вычислительных ресурсов — всего 1/19 от того, что требуется Llama3-70B.

Высокая точность на бенчмарках: Превосходит конкурентов, таких как Llama3-70B, на нескольких бенчмарках, особенно в математических задачах и сложном рассуждении, достигая точности 55,9% и 95,8% на MATH и ARC-Challenge соответственно.

Конкурентоспособность в специализированных областях: Демонстрирует компетентность в кодировании, математике и других специализированных областях, подтверждая свою универсальность и надежные возможности.

Тщательная оценка и оптимизация: Интеллектуальное использование параметров приводит к средней точности 10,69 вычислений с плавающей запятой на токен во время вывода, превосходя аналогичные модели.

Сферы применения:

Улучшение образовательного программного обеспечения: Улучшение образовательных приложений за счет предоставления точных и мгновенных ответов на сложные математические задачи и вопросы, что выгодно для учащихся с различными уровнями подготовки.

Услуги виртуального репетиторства: Предложение сложного и индивидуального репетиторства по программированию и другим техническим предметам, позволяющее учащимся практиковаться в написании кода или решении задач с обратной связью в реальном времени.

Помощь в научных исследованиях: Поддержка исследователей в анализе и понимании сложных научных статей или наборов данных, с точными insights, которые улучшают результаты исследований.

Заключение:

Yuan2.0-M32, с ее инновационной технической основой и эффективным дизайном, обеспечивает масштабируемое и точное решение для языковых приложений. Будь то образование, научные исследования или разработка программного обеспечения, она обеспечивает непревзойденную производительность, преобразуя ландшафт возможностей, основанных на искусственном интеллекте. Оцените мощь Yuan2.0-M32 и используйте ее потенциал уже сегодня.

More information on Yuan2.0-M32

Yuan2.0-M32 Альтернативы

Yuan2.0-M32 Альтернативы-

XVERSE-MoE-A36B: Многоязычная большая языковая модель, разработанная XVERSE Technology Inc.

-

JetMoE-8B был обучен с затратами менее 0,1 миллиона долларов1, но превосходит LLaMA2-7B от Meta AI, которая имеет многомиллиардные ресурсы обучения. Обучение LLM может быть намного дешевле, чем обычно считается.

-

Языковые модели серии Qwen2.5 предлагают расширенные возможности благодаря более крупным наборам данных, большему объему знаний, улучшенным навыкам программирования и математики, а также более тесному соответствию человеческим предпочтениям. Открытый исходный код и доступны через API.

-

DeepSeek-V2: 236-миллиардная модель MoE. Передовые характеристики. Ультрадоступно. Несравненный опыт. Чат и API обновлены до последней модели.

-

Hunyuan-MT-7B: Машинный перевод на базе ИИ с открытым исходным кодом. Поддерживает более 33 языков, обеспечивая непревзойденную контекстуальную и культурную точность. Победитель WMT2025, легковесный и эффективный.