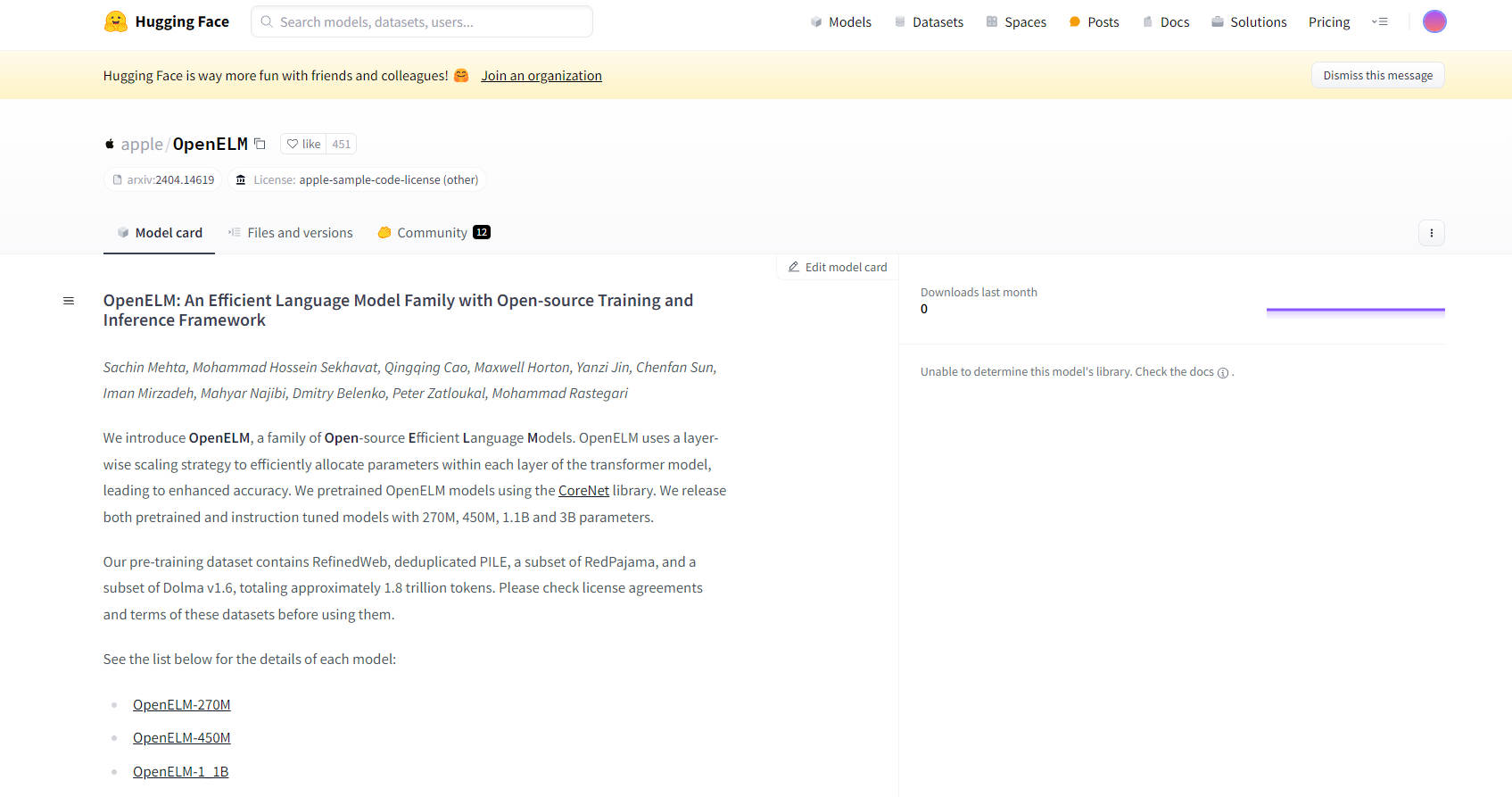

What is OpenELM?

OpenELM 是一款创新的开源语言模型系列,专为高效且准确地处理自然语言任务而设计。这些模型利用了一种独特的逐层扩展策略,该策略优化了 transformer 架构中每一层的参数分配。这种方法增强了整体准确性和性能。

主要特点:

逐层扩展策略:OpenELM 在其 transformer 模型的各层内有效分配参数,从而提高了语言处理任务的准确性。

预训练和指令微调模型:OpenELM 提供了一系列具有不同参数大小(2.7亿、4.5亿、11亿和30亿)的模型,包括预训练和指令微调版本,以满足不同的用户需求。

开源训练和推理框架:这些模型使用 CoreNet 库进行训练,并在开源许可下提供,鼓励社区驱动开发和创新。

通用的预训练数据集:预训练数据集包括 RefinedWeb、去重的 PILE、RedPajama 和 Dolma v1.6 的子集,总计约 1.8 万亿个令牌,确保了广泛而多样的语言理解。

易于集成:OpenELM 模型可通过 HuggingFace Hub 轻松访问,从而与现有的自然语言处理工作流实现无缝集成。

用例:

自然语言理解:非常适合需要对人类语言进行深度理解的任务,例如问答、情感分析和文本摘要。

内容生成:适用于自动写作、创意叙事和内容完成等应用。

定制语言模型开发:为研究人员和开发者提供强大的基础,以便针对特定领域或语言构建和微调定制模型。

目标受众:

OpenELM 面向自然语言处理、机器学习和人工智能领域的广大受众,包括研究人员、开发人员和学生。它特别有利于那些希望在项目中探索和利用高级语言模型且无需大量计算资源的人员。

主要优势:

增强准确性:逐层扩展策略在模型复杂性和准确性之间取得平衡,从而在各种语言任务上获得更好的性能。

可访问性和社区支持:OpenELM 作为开源项目,营造了一种协作环境,允许用户做出改进并分享他们的发现。

可扩展性:借助不同大小的模型,用户可以选择最适合其计算资源和特定需求的模型。

OpenELM 代表了开源语言模型领域的重要一步,为广泛的自然语言处理任务提供了一个强大、通用且社区驱动的解决方案。