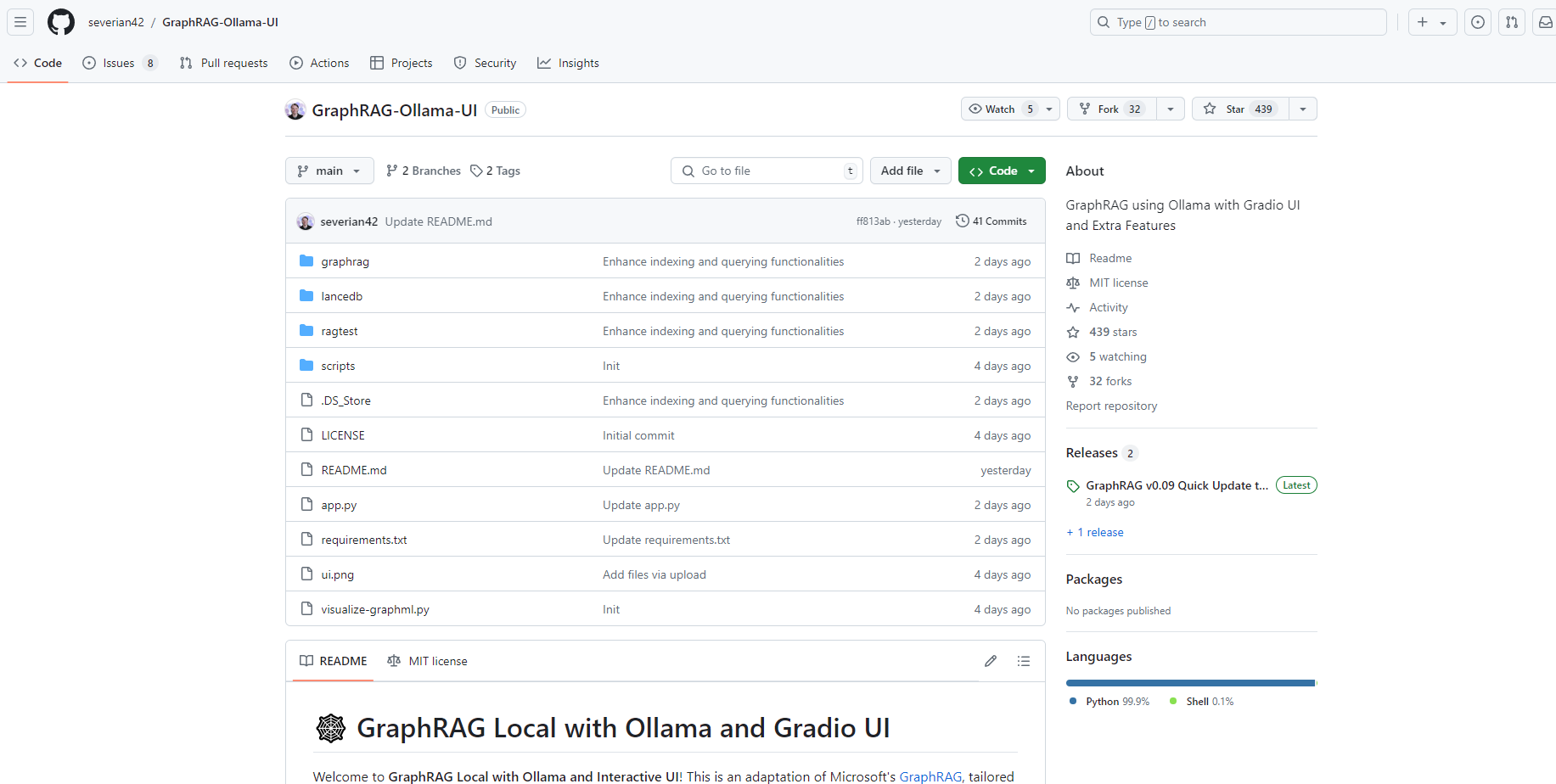

What is GraphRAG-Ollama-UI?

GraphRAG Local con Ollama e interfaz interactiva ofrece una solución potente y rentable para administrar y visualizar grafos de conocimiento utilizando modelos locales. Esta adaptación de GraphRAG de Microsoft aprovecha Ollama para el soporte de LLM e incrustación, proporcionando una interfaz de usuario interactiva para el manejo eficiente de datos y la visualización de grafos en tiempo real.

Características principales:

Soporte de modelo local ?️

Emplea Ollama para modelos locales de LLM e incrustación.

Reduce la dependencia de los costosos servicios de IA basados en la nube.

Interfaz de usuario interactiva ?

Interfaz fácil de usar para administrar datos, ejecutar consultas y visualizar resultados.

Simplifica las operaciones que antes se hacían mediante la línea de comandos.

Visualización de grafos en tiempo real ?

Utiliza Plotly para la visualización en 3D de grafos de conocimiento.

Mejora la comprensión y la exploración de las relaciones de datos.

Gestión de archivos y configuraciones ?

Acceso directo de la interfaz de usuario para la carga, edición y gestión de archivos.

Fáciles actualizaciones y gestión de la configuración de GraphRAG.

Opciones de personalización ?

Flexibilidad para experimentar con diferentes modelos en el archivo settings.yaml.

Admite varios modelos de LLM e incrustación proporcionados por Ollama.

Casos de uso:

Investigación y desarrollo ?

Los investigadores pueden utilizar GraphRAG Local para explorar y visualizar conjuntos de datos complejos.

La interfaz de usuario interactiva ayuda en las pruebas de hipótesis y el análisis de datos.

Soluciones empresariales ?

Las empresas pueden aprovechar esta herramienta para una gestión rentable de los grafos de conocimiento.

Mejora la información sobre los datos y los procesos de toma de decisiones.

Propósitos educativos ?

Los educadores y los estudiantes pueden usar GraphRAG Local para enseñar y aprender estructuras de datos basadas en grafos y conceptos de IA.

Conclusión:

GraphRAG Local con Ollama e interfaz interactiva es una herramienta versátil para cualquier persona involucrada en la gestión y visualización de grafos de conocimiento. Su soporte de modelo local y su interfaz fácil de usar lo convierten en una opción rentable y eficiente. Le invitamos a experimentar el poder de GraphRAG Local y explorar las posibilidades que ofrece para administrar y visualizar sus datos.

More information on GraphRAG-Ollama-UI

GraphRAG-Ollama-UI Alternativas

Más Alternativas-

RLAMA es una potente herramienta de preguntas y respuestas impulsada por IA para tus documentos, que se integra perfectamente con tus modelos locales de Ollama. Te permite crear, gestionar e interactuar con sistemas de Generación Aumentada por Recuperación (RAG) adaptados a tus necesidades de documentación.

-

Marco Fast GraphRAG optimizado y con capacidad de respuesta, diseñado para flujos de trabajo de recuperación impulsados por agentes, interpretables y de alta precisión.

-

Agentes Unificados Verticalmente para el Razonamiento Complejo Aumentado mediante Recuperación de Grafos - Un marco revolucionario que desplaza la Frontera de Pareto, logrando una reducción del 33.6% en el coste de *tokens* y un aumento del 16.62% en la precisión, superando así a las líneas base SOTA.

-

-

HelloRAG es una solución sin código, fácil de usar y escalable para ingerir datos multimodales generados por humanos y máquinas para aplicaciones potenciadas por LLM