MiniCPM-2B

MiniCPM-2B

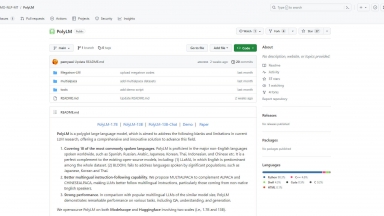

PolyLM

PolyLM

MiniCPM-2B

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Language Learning |

PolyLM

| Launched | 2023 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Language Learning |

MiniCPM-2B Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

PolyLM Rank/Visit

| Global Rank | 0 |

| Country | |

| Month Visit | 0 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

MiniCPM-Llama3-V 2.5 - Avec un total de 8 milliards de paramètres, le modèle surpasse les modèles propriétaires tels que GPT-4V-1106, Gemini Pro, Qwen-VL-Max et Claude 3 en termes de performances globales.

MiniCPM3-4B - MiniCPM3-4B est la 3e génération de la série MiniCPM. Les performances globales de MiniCPM3-4B surpassent celles de Phi-3.5-mini-Instruct et GPT-3.5-Turbo-0125, se comparant à de nombreux modèles récents de 7B à 9B.

SmolLM - SmolLM est une série de modèles de langage de pointe de petite taille disponibles en trois tailles : 135 M, 360 M et 1,7 milliard de paramètres.

MiniMind - Créez des modèles d'IA de A à Z ! MiniMind propose un entraînement rapide et abordable des LLM sur un seul GPU. Apprenez PyTorch et créez votre propre IA.

OpenBMB - OpenBMB : création d'un centre de modèles de langage pré-entraînés à grande échelle et d'outils pour accélérer l'entraînement, le réglage et l'inférence de modèles majeurs comprenant plus de 10 milliards de paramètres. Rejoignez notre communauté open source et rendez ces modèles majeurs disponibles à tous.