What is DeepSeek-R1?

La série DeepSeek-R1 propose un ensemble de puissants modèles de raisonnement conçus pour faire progresser la recherche et le développement en IA. Ces modèles, incluant DeepSeek-R1-Zero et DeepSeek-R1, excellent dans les tâches mathématiques, de codage et de raisonnement, atteignant des niveaux de performance comparables, et parfois supérieurs, à ceux de modèles de pointe comme OpenAI-o1.

Fonctionnalités clés :

DeepSeek-R1-Zero et DeepSeek-R1 ont été entraînés différemment, ce qui a conduit à des avancées significatives dans le raisonnement par IA.

Exploitation de l’apprentissage par renforcement (RL) : DeepSeek-R1-Zero a été entraîné exclusivement avec du RL, en contournant l’étape traditionnelle d’ajustement fin supervisé (SFT). Vous pouvez observer comment le RL seul favorise des comportements de raisonnement sophistiqués dans les modèles, conduisant à des capacités émergentes telles que l’auto-vérification, la réflexion et la génération de longues chaînes de pensées (CoTs).

Intégration de données de démarrage à froid : Contrairement à DeepSeek-R1-Zero, DeepSeek-R1 intègre des données avant l’entraînement par RL. Cela permet d’éviter les problèmes observés avec DeepSeek-R1-Zero, tels que les répétitions infinies et la mauvaise lisibilité. Cela améliore également les performances globales de raisonnement.

Utilisation de la distillation pour des modèles plus petits et plus efficaces : Les capacités de raisonnement de DeepSeek-R1 sont distillées dans des modèles plus petits et plus accessibles. Vous pouvez utiliser ces modèles distillés, qui surpassent les modèles entraînés directement avec du RL à plus petite échelle, pour diverses applications sans sacrifier les performances.

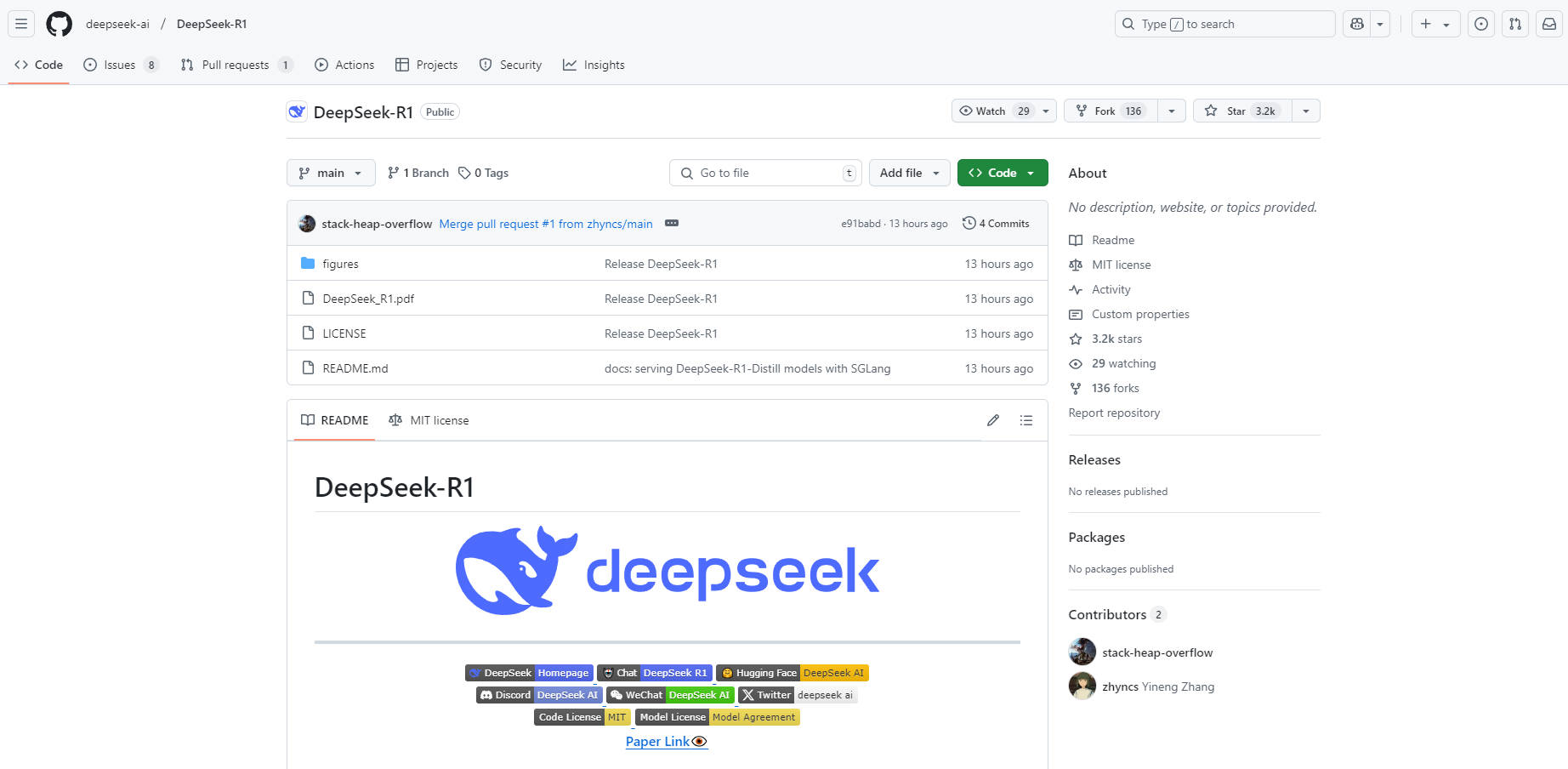

Utilisation de modèles open source : La publication inclut des versions open source de DeepSeek-R1-Zero, DeepSeek-R1 et six modèles distillés basés sur Llama et Qwen. Vous avez accès à ces modèles, vous permettant d’intégrer des capacités de raisonnement avancées dans vos projets et de contribuer à la communauté de recherche. Plus précisément, DeepSeek-R1-Distill-Qwen-32B surpasse OpenAI-o1-mini sur plusieurs benchmarks, établissant une nouvelle référence pour les modèles denses.

Cas d’utilisation :

Les chercheurs et les développeurs peuvent utiliser les modèles DeepSeek-R1 de plusieurs manières :

Recherche académique : Si vous êtes chercheur, DeepSeek-R1-Zero offre une occasion unique d’étudier l’impact du RL pur sur l’entraînement des modèles. Vous pouvez explorer comment des comportements de raisonnement complexes émergent sans SFT, découvrant potentiellement de nouvelles méthodologies d’entraînement. DeepSeek-R1 offre également une occasion unique d’étudier l’impact des données de démarrage à froid sur l’entraînement des modèles.

Développement de modèles : En tant que développeur, vous pouvez intégrer DeepSeek-R1 ou ses versions distillées dans vos applications. Par exemple, en utilisant DeepSeek-R1-Distill-Qwen-32B, vous pouvez créer des outils de génération de code avancés offrant des performances supérieures aux solutions existantes. DeepSeek-R1 fournit des services API pour afficher la chaîne de pensée, accessibles en définissant

model='deepseek-reasoner.Évaluation comparative : Utilisez les résultats d’évaluation complets fournis pour comparer vos modèles à DeepSeek-R1. Par exemple, si vous travaillez à l’amélioration du raisonnement mathématique, vous pouvez comparer les performances de votre modèle sur le benchmark AIME 2024, où DeepSeek-R1 a atteint un taux de réussite de 79,8 %.

Conclusion :

Les modèles de la série DeepSeek-R1 représentent une avancée significative dans le domaine du raisonnement par IA. En exploitant des techniques d’entraînement avancées et en rendant les modèles open source, DeepSeek permet aux chercheurs et aux développeurs d’explorer de nouvelles frontières de l’IA. Que vous meniez des recherches académiques, que vous développiez des applications basées sur l’IA ou que vous cherchiez à comparer vos modèles, DeepSeek-R1 fournit les outils et les performances dont vous avez besoin pour réussir.

FAQ :

1. Qu’est-ce qui rend les modèles DeepSeek-R1 uniques ?

Les modèles DeepSeek-R1 sont uniques en raison de leurs méthodologies d’entraînement. DeepSeek-R1-Zero a été entraîné uniquement par apprentissage par renforcement, démontrant que des raisonnements complexes peuvent émerger sans ajustement fin supervisé. DeepSeek-R1 exploite des données de démarrage à froid pour améliorer les performances et résoudre des problèmes tels que la mauvaise lisibilité. De plus, la possibilité de distiller ces capacités de raisonnement avancées dans des modèles plus petits les rend plus accessibles pour diverses applications.

2. Comment puis-je accéder aux modèles DeepSeek-R1 et les utiliser ?

Vous pouvez accéder aux modèles DeepSeek-R1 via le site Web officiel de DeepSeek et la plateforme API. Les modèles, y compris DeepSeek-R1-Zero, DeepSeek-R1 et les versions distillées, sont également disponibles sur Hugging Face. Vous pouvez les télécharger et les intégrer à vos projets en utilisant les procédures standard pour les modèles Qwen ou Llama.

3. Quels sont les avantages de l’utilisation des modèles distillés ?

Les modèles distillés, tels que DeepSeek-R1-Distill-Qwen-32B, offrent plusieurs avantages. Ils conservent les capacités de raisonnement avancées du modèle DeepSeek-R1 plus grand, mais sont plus petits et plus efficaces. Cela signifie que vous pouvez les déployer dans des environnements aux ressources limitées sans sacrifier les performances. Ils surpassent également les modèles de taille similaire entraînés directement avec l’apprentissage par renforcement, offrant des résultats supérieurs pour des tâches telles que la génération de code et le raisonnement mathématique.

4. Comment les modèles DeepSeek-R1 se comparent-ils aux autres modèles de pointe ?

Les modèles DeepSeek-R1 obtiennent d’excellents résultats lors des évaluations comparatives, souvent égalant ou surpassant les modèles de pointe comme OpenAI-o1. Par exemple, DeepSeek-R1 a atteint un taux de réussite de 79,8 % sur le benchmark AIME 2024 et un taux de réussite de 97,3 % sur MATH-500. Dans les tâches de codage, il a obtenu un classement Codeforces de 2029, surpassant 96,3 % des participants humains. Les modèles distillés affichent également de fortes performances, DeepSeek-R1-Distill-Qwen-32B surpassant OpenAI-o1-mini sur divers benchmarks.

More information on DeepSeek-R1

DeepSeek-R1 Alternatives

Plus Alternatives-

DeepCoder : IA avec un contexte de 64K. Modèle open source de 14 milliards de paramètres qui surpasse les attentes ! Contexte long, entraînement par renforcement, performances optimales.

-

DeepSeek-VL2, un modèle vision-langage développé par DeepSeek-AI, traite des images haute résolution, offre des réponses rapides grâce à MLA et excelle dans diverses tâches visuelles telles que le VQA et l'OCR. Il est idéal pour les chercheurs, les développeurs et les analystes BI.

-

DeepSeek-V2 : modèle MoE de 236 milliards. Performances de pointe. Ultra abordable. Expérience inégalée. Chat et API mis à jour avec le dernier modèle.

-

DeepSeek LLM, un modèle avancé de langage composé de 67 milliards de paramètres. Il a été entraîné à partir de zéro sur un vaste jeu de données de 2 billions de jetons en anglais et en chinois.

-

API DeepSearch : Un outil révolutionnaire pour une investigation approfondie des requêtes. Grâce à la recherche itérative, un contexte de 500 000 tokens et des résultats basés sur des preuves, il fournit des réponses complètes à des questions complexes, idéal pour la recherche et pour se tenir informé dans n'importe quel domaine.