What is DeepSeek-R1?

Серия моделей DeepSeek-R1 предлагает набор мощных моделей рассуждения, разработанных для продвижения исследований и разработок в области искусственного интеллекта. Эти модели, включая DeepSeek-R1-Zero и DeepSeek-R1, превосходно справляются с математическими задачами, программированием и логическими выводами, достигая уровня производительности, сопоставимого, а в некоторых случаях и превосходящего, ведущие модели, такие как OpenAI-o1.

Ключевые особенности:

DeepSeek-R1-Zero и DeepSeek-R1 были обучены по-разному, что привело к значительному прогрессу в области рассуждений ИИ.

Использование обучения с подкреплением (RL): DeepSeek-R1-Zero был обучен исключительно с помощью RL, минуя традиционный этап контролируемой тонкой настройки (SFT). Вы можете наблюдать, как RL сам по себе способствует развитию сложных поведенческих моделей рассуждения, приводя к появлению таких дополнительных возможностей, как самопроверка, рефлексия и генерация длинных цепочек рассуждений (CoTs).

Включение данных «холодного старта»: В отличие от DeepSeek-R1-Zero, DeepSeek-R1 включает данные до обучения с подкреплением. Благодаря этому удаётся избежать проблем, наблюдаемых в DeepSeek-R1-Zero, таких как бесконечное повторение и плохая читаемость. Это также повышает общую производительность рассуждений.

Использование дистилляции для создания меньших, эффективных моделей: Возможности рассуждения DeepSeek-R1 были перенесены в меньшие, более доступные модели. Вы можете использовать эти дистиллированные модели, которые превосходят модели, обученные непосредственно с помощью RL меньшего масштаба, для различных приложений без потери производительности.

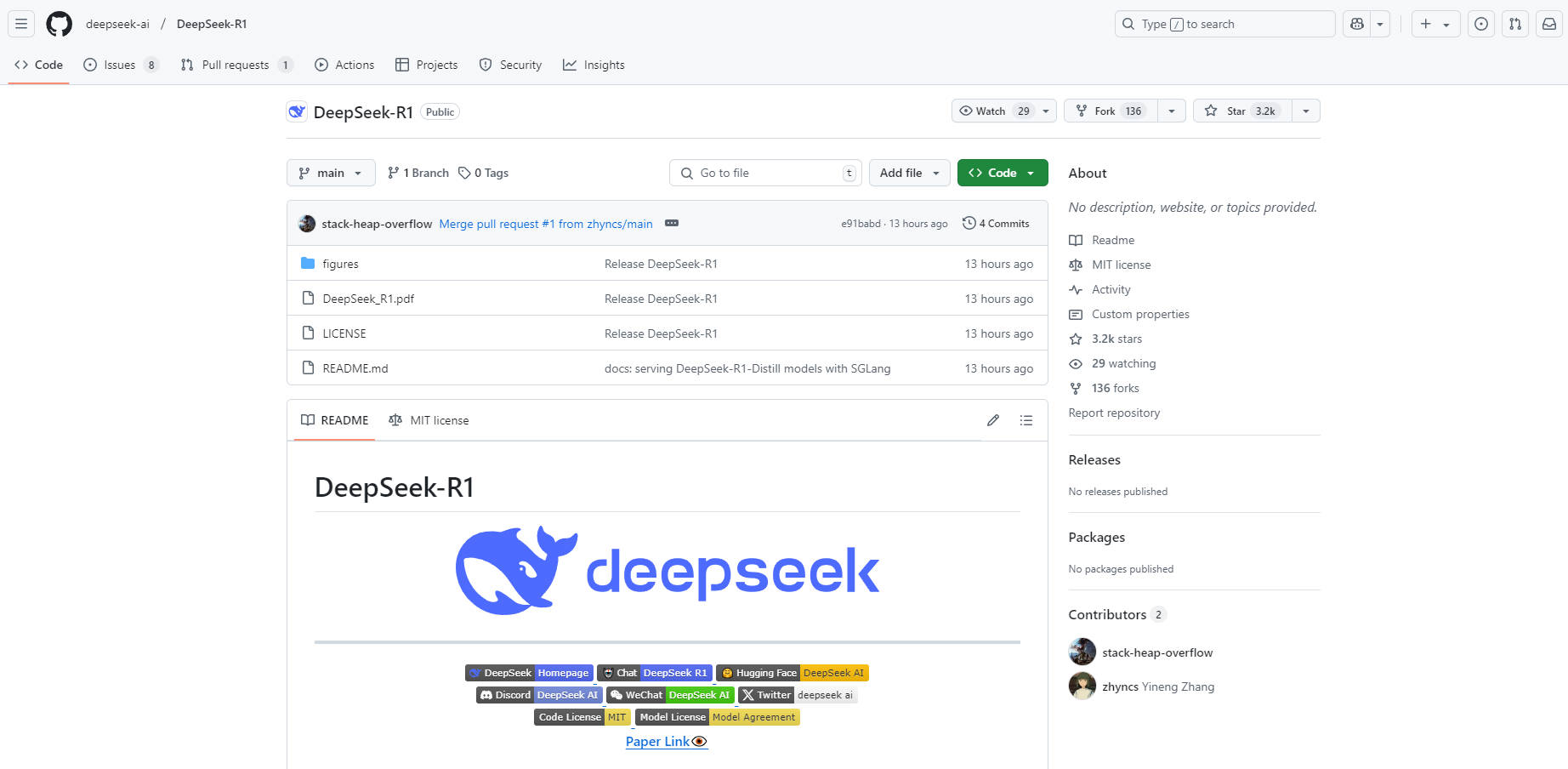

Использование моделей с открытым исходным кодом: Релиз включает в себя версии с открытым исходным кодом DeepSeek-R1-Zero, DeepSeek-R1 и шести дистиллированных моделей на основе Llama и Qwen. Вы получаете доступ к этим моделям, что позволяет интегрировать расширенные возможности рассуждения в свои проекты и вносить свой вклад в исследовательское сообщество. В частности, DeepSeek-R1-Distill-Qwen-32B превосходит OpenAI-o1-mini по нескольким бенчмаркам, устанавливая новый стандарт для плотных моделей.

Варианты использования:

Исследователи и разработчики могут использовать модели DeepSeek-R1 различными способами:

Научные исследования: Если вы исследователь, DeepSeek-R1-Zero предоставляет уникальную возможность изучить влияние чистого RL на обучение модели. Вы можете изучить, как возникают сложные поведенческие модели рассуждения без SFT, потенциально открывая новые методологии обучения. DeepSeek-R1 также предоставляет уникальную возможность изучить влияние данных «холодного старта» на обучение модели.

Разработка моделей: Как разработчик, вы можете интегрировать DeepSeek-R1 или его дистиллированные версии в свои приложения. Например, используя DeepSeek-R1-Distill-Qwen-32B, вы можете создавать расширенные инструменты генерации кода, которые предлагают более высокую производительность по сравнению с существующими решениями. DeepSeek-R1 предоставляет API-сервисы для вывода цепочки рассуждений, которые можно вызвать, установив

model='deepseek-reasoner.Бенчмаркинг и оценка: Используйте предоставленные всесторонние результаты оценки для сравнения ваших моделей с DeepSeek-R1. Например, если вы работаете над улучшением математических рассуждений, вы можете сравнить производительность вашей модели на бенчмарке AIME 2024, где DeepSeek-R1 достиг 79,8% успешности.

Заключение:

Модели серии DeepSeek-R1 представляют собой значительный шаг вперед в области рассуждений ИИ. Используя передовые методы обучения и предоставляя модели с открытым исходным кодом, DeepSeek предоставляет исследователям и разработчикам возможность исследовать новые горизонты в области ИИ. Независимо от того, проводите ли вы научные исследования, разрабатываете ли приложения на основе ИИ или стремитесь протестировать свои модели, DeepSeek-R1 предоставляет необходимые инструменты и производительность для достижения успеха.

Часто задаваемые вопросы:

1. Что делает модели DeepSeek-R1 уникальными?

Модели DeepSeek-R1 уникальны благодаря своим методологиям обучения. DeepSeek-R1-Zero был обучен исключительно с помощью обучения с подкреплением, демонстрируя, что сложное рассуждение может возникнуть без контролируемой тонкой настройки. DeepSeek-R1 использует данные «холодного старта» для повышения производительности и решения таких проблем, как плохая читаемость. Кроме того, возможность дистиллировать эти расширенные возможности рассуждения в меньшие модели делает их более доступными для различных приложений.

2. Как я могу получить доступ и использовать модели DeepSeek-R1?

Вы можете получить доступ к моделям DeepSeek-R1 через официальный веб-сайт и платформу API DeepSeek. Модели, включая DeepSeek-R1-Zero, DeepSeek-R1 и дистиллированные версии, также доступны на Hugging Face. Вы можете загрузить и интегрировать их в свои проекты, используя стандартные процедуры для моделей Qwen или Llama.

3. Каковы преимущества использования дистиллированных моделей?

Дистиллированные модели, такие как DeepSeek-R1-Distill-Qwen-32B, обладают несколькими преимуществами. Они сохраняют расширенные возможности рассуждения большей модели DeepSeek-R1, но при этом являются меньшими и более эффективными. Это означает, что вы можете развертывать их в средах с ограниченными ресурсами без потери производительности. Они также превосходят модели аналогичного размера, обученные непосредственно с помощью обучения с подкреплением, обеспечивая превосходные результаты для таких задач, как генерация кода и математические рассуждения.

4. Как модели DeepSeek-R1 сравниваются с другими ведущими моделями?

Модели DeepSeek-R1 демонстрируют исключительную производительность в бенчмарках, часто сравниваясь или превосходя ведущие модели, такие как OpenAI-o1. Например, DeepSeek-R1 достиг 79,8% успешности на бенчмарке AIME 2024 и 97,3% успешности на MATH-500. В задачах программирования он достиг рейтинга Codeforces 2029, опередив 96,3% участников-людей. Дистиллированные модели также демонстрируют высокую производительность, причём DeepSeek-R1-Distill-Qwen-32B превосходит OpenAI-o1-mini по различным бенчмаркам.

More information on DeepSeek-R1

DeepSeek-R1 Альтернативи

Больше Альтернативи-

DeepCoder: ИИ для работы с кодом с контекстом 64K. Модель с открытым исходным кодом на 14B превосходит все ожидания! Увеличенная длина контекста, обучение с подкреплением (RL) и высочайшая производительность.

-

DeepSeek-VL2, модель визуального и языкового взаимодействия от DeepSeek-AI, обрабатывает изображения высокого разрешения, обеспечивает быстрые ответы с помощью MLA и показывает превосходные результаты в различных визуальных задачах, таких как VQA и OCR. Идеальна для исследователей, разработчиков и аналитиков бизнес-интеллекта.

-

DeepSeek-V2: 236-миллиардная модель MoE. Передовые характеристики. Ультрадоступно. Несравненный опыт. Чат и API обновлены до последней модели.

-

DeepSeek LLM, передовая языковая модель, включающая 67 миллиардов параметров. Она была обучена с нуля на обширном наборе данных в 2 триллиона токенов как на английском, так и на китайском языках.

-

DeepSearch API: революционный инструмент для углубленного исследования запросов. Благодаря итеративному поиску, контексту в 500 тысяч токенов и результатам, основанным на доказательствах, он предоставляет исчерпывающие ответы на сложные вопросы, идеально подходит для исследований и поддержания актуальности знаний в любой области.