StreamingLLM

StreamingLLM

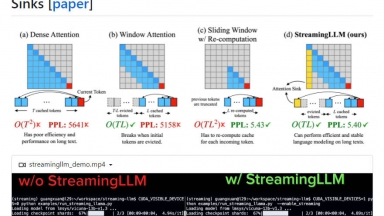

StreamingLLMのご紹介:ストリーミングアプリにLLMを導入するための効率的なフレームワーク。パフォーマンスを犠牲にすることなく無限のシーケンス長を処理し、最大22.2倍の速度最適化を享受できます。複数ラウンドの対話や日常のアシスタントに最適です。

LLMLingua

LLMLingua

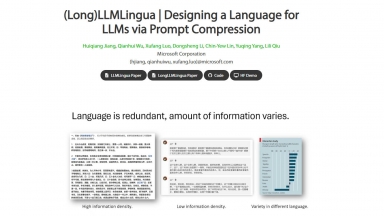

LLMの推論を高速化し、LLMが重要な情報を認識できるように、プロンプトとKVキャッシュを圧縮します。これにより、パフォーマンスをほとんど低下させることなく、最大20倍の圧縮を実現します。

StreamingLLM

| Launched | 2024 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Workflow Automation,Developer Tools,Communication |

LLMLingua

| Launched | 2023-7 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,cdnjs,Font Awesome,Highlight.js,jQuery,Gzip,HSTS,Nginx,Ubuntu |

| Tag | Text Generators,Data Science,Summarize Text |

StreamingLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

LLMLingua Rank/Visit

| Global Rank | 11514600 |

| Country | India |

| Month Visit | 1634 |

Top 5 Countries

50.25%

49.75%

India

United States

Traffic Sources

8.83%

1.49%

0.11%

9.67%

29.93%

49.62%

social

paidReferrals

mail

referrals

search

direct

Estimated traffic data from Similarweb

What are some alternatives?

When comparing StreamingLLM and LLMLingua, you can also consider the following products

vLLM - 大規模言語モデル向けの、スループットが高くメモリー効率に優れた推論およびサービングエンジン

EasyLLM - EasyLLMは、オープンソースおよびクローズドソースの大規模言語モデル(LLM)を扱うための有用なツールと方法を提供するオープンソースプロジェクトです。直ちに開始するか、ドキュメントを確認してください。

LazyLLM - LazyLLM: マルチエージェントLLMアプリ向けのローコード 複雑なAIソリューションを、プロトタイプから本番環境まで迅速に構築、反復、デプロイ。 開発作業ではなく、アルゴリズムに注力。

LMCache - LMCacheは、データの保存と検索を最適化することでLLMアプリケーションを高速化する、オープンソースのKnowledge Delivery Network(KDN)です。