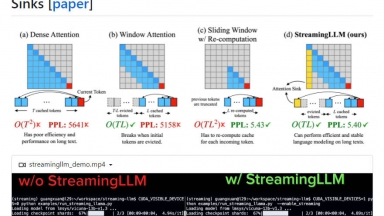

StreamingLLM

StreamingLLM

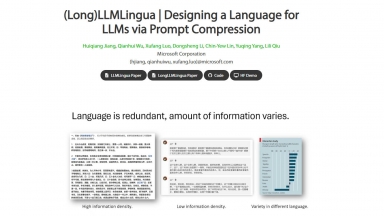

LLMLingua

LLMLingua

StreamingLLM

| Launched | 2024 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Workflow Automation,Developer Tools,Communication |

LLMLingua

| Launched | 2023-7 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,cdnjs,Font Awesome,Highlight.js,jQuery,Gzip,HSTS,Nginx,Ubuntu |

| Tag | Text Generators,Data Science,Summarize Text |

StreamingLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

LLMLingua Rank/Visit

| Global Rank | 11514600 |

| Country | India |

| Month Visit | 1634 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

vLLM - Высокопроизводительный и экономичный по памяти механизм вывода и обслуживания для LLMs

EasyLLM - EasyLLM — это проект с открытым исходным кодом, который предоставляет полезные инструменты и методы для работы с большими языковыми моделями (LLM), как с открытым, так и с закрытым исходным кодом. Начните работу мгновенно или ознакомьтесь с документацией.

LazyLLM - LazyLLM: Low-code для мультиагентных LLM-приложений. Создавайте, итерируйте и развертывайте сложные ИИ-решения быстро — от прототипа до продакшена. Сосредоточьтесь на алгоритмах, а не на инжиниринге.

LMCache - LMCache — это открытая сеть доставки знаний (KDN), которая ускоряет работу приложений на основе больших языковых моделей (LLM) за счёт оптимизации хранения и извлечения данных.