MiniCPM-Llama3-V 2.5

MiniCPM-Llama3-V 2.5

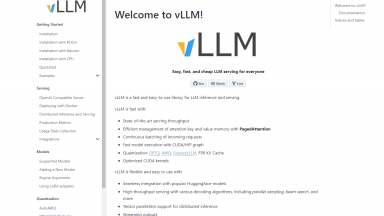

VLLM

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Software Development,Data Science |

MiniCPM-Llama3-V 2.5

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Language Learning,Mlops |

VLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

MiniCPM-Llama3-V 2.5 Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

EasyLLM - EasyLLMは、オープンソースおよびクローズドソースの大規模言語モデル(LLM)を扱うための有用なツールと方法を提供するオープンソースプロジェクトです。直ちに開始するか、ドキュメントを確認してください。

LLMLingua - LLMの推論を高速化し、LLMが重要な情報を認識できるように、プロンプトとKVキャッシュを圧縮します。これにより、パフォーマンスをほとんど低下させることなく、最大20倍の圧縮を実現します。

MegaLLM - Ship AI features faster with MegaLLM's unified gateway. Access Claude, GPT-5, Gemini, Llama, and 70+ models through a single API. Built-in analytics, smart fallbacks, and usage tracking included.

StreamingLLM - StreamingLLMのご紹介:ストリーミングアプリにLLMを導入するための効率的なフレームワーク。パフォーマンスを犠牲にすることなく無限のシーケンス長を処理し、最大22.2倍の速度最適化を享受できます。複数ラウンドの対話や日常のアシスタントに最適です。

LazyLLM - LazyLLM: マルチエージェントLLMアプリ向けのローコード 複雑なAIソリューションを、プロトタイプから本番環境まで迅速に構築、反復、デプロイ。 開発作業ではなく、アルゴリズムに注力。

VLLM

VLLM