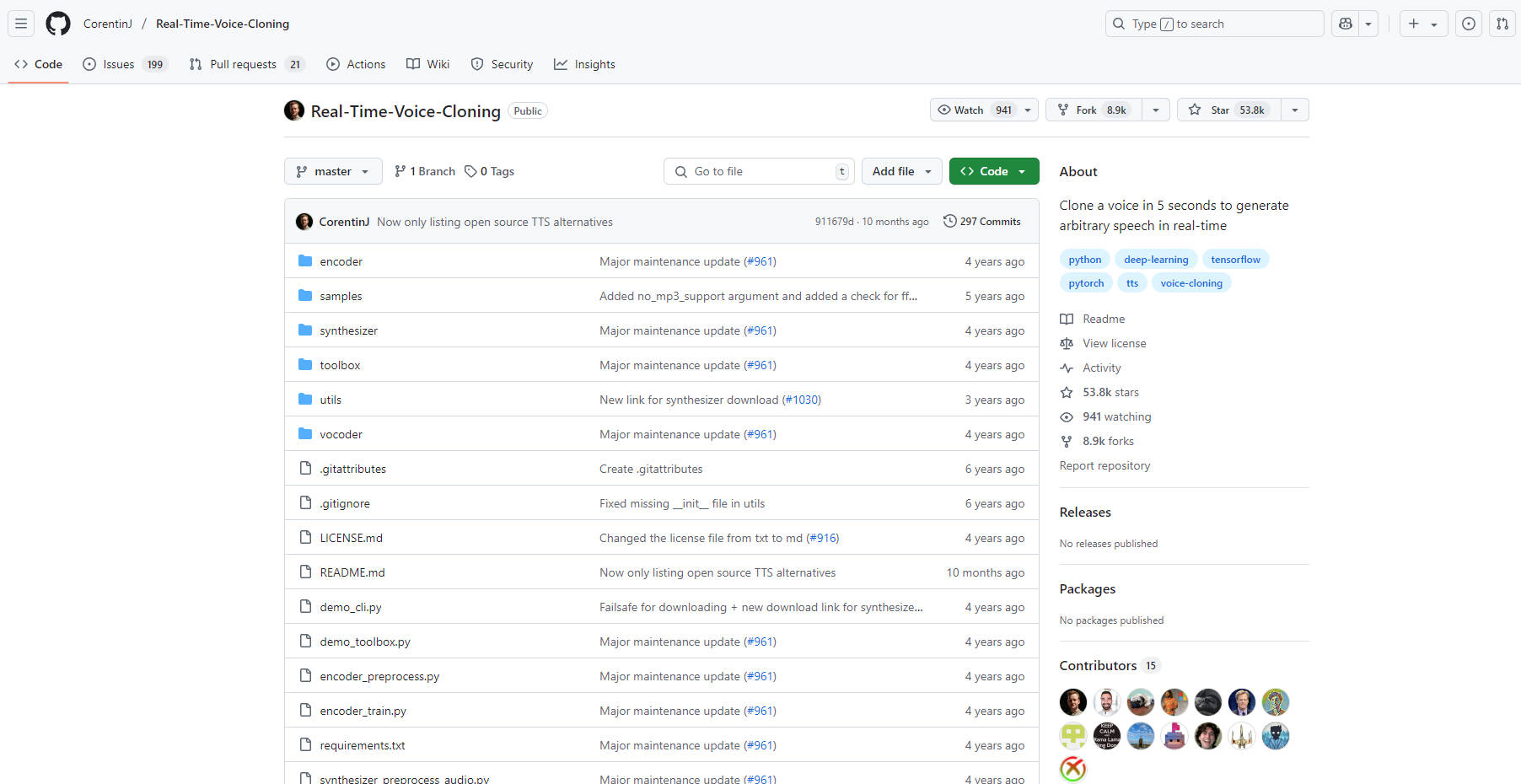

What is Real-Time Voice Cloning?

본 저장소는 음성 복제를 위한 강력한 딥러닝 프레임워크인 화자 검증에서 다중 화자 텍스트 음성 변환(SV2TTS)으로의 전이 학습을 실시간으로 구현한 것을 제공합니다. 오리지널 SV2TTS 논문(1806.04558)을 기반으로 한 이 프로젝트를 통해 단 몇 초 분량의 오디오만으로 음성의 디지털 표현을 만들고, 그 표현을 사용하여 임의의 텍스트로 음성을 생성할 수 있습니다. 이 기술은 연구원과 개발자를 위해 설계된 실용적인 작업 구현입니다.

주요 기능:

SV2TTS 구현: 화자 인코더, 합성기 및 보코더를 포함하여 3단계 SV2TTS 프로세스의 완벽하고 기능적인 구현을 제공합니다.

실시간 보코더 활용: 효율적이고 실시간 오디오 합성을 위해 WaveRNN 기반 보코더(1802.08435)를 활용합니다.

사전 훈련된 모델 적용: 사전 훈련된 모델이 즉시 사용 가능하도록 자동으로 다운로드되거나, 사용자가 직접 훈련할 수도 있습니다.

다중 데이터세트와 통합: 훈련 및 실험을 위해 LibriSpeech를 포함한 다양한 데이터세트를 지원합니다. (자세한 목록은 여기를 참조하십시오.)

종합적인 테스트 실행: 구성을 확인하고 적절한 기능을 보장하기 위한 내장 테스트 스위트(

demo_cli.py)를 포함합니다.GE2E(Generalized End-to-End) 손실 적용: 향상된 화자 검증 성능을 위해 GE2E 손실 함수(1710.10467)를 구현합니다.

기술적 세부 사항:

이 시스템은 3단계 딥러닝 파이프라인을 기반으로 구축되었습니다.

화자 인코더: 대상 화자의 짧은 오디오 샘플에서 고정 차원 임베딩 벡터(d-vector)를 추출합니다. 이 임베딩은 화자 음성의 고유한 특징을 나타냅니다. 이 단계에서는 GE2E 손실 함수를 구현합니다.

합성기: Tacotron 아키텍처(1703.10135)를 기반으로 하는 이 단계에서는 화자 임베딩과 입력 텍스트 시퀀스를 입력으로 사용합니다. 오디오 신호의 시간-주파수 표현인 멜 스펙트로그램을 생성합니다.

보코더: WaveRNN(1802.08435)을 기반으로 구축된 이 구성 요소는 멜 스펙트로그램을 원시 파형으로 변환하여 최종 합성 음성을 생성합니다.

사용 사례:

맞춤형 음성 어시스턴트 개발: 음성 어시스턴트 및 기타 대화형 애플리케이션을 위한 고유하고 개인화된 음성을 만듭니다. 일반적인 시스템 음성에 의존하는 대신 특정 브랜드 또는 페르소나에 맞게 음성을 조정할 수 있습니다.

음성 합성 연구: 음성 복제, 텍스트 음성 변환 및 화자 검증에 대한 추가 연구의 기반 역할을 합니다. 모듈식 설계를 통해 개별 구성 요소를 실험할 수 있습니다.

오디오 콘텐츠 제작: 복제된 음성을 사용하여 비디오, 팟캐스트 또는 오디오북에 대한 사실적인 보이스오버를 생성합니다. 이는 콘텐츠의 음성 특성에 대한 유연성과 제어력을 제공합니다.

결론:

이 실시간 음성 복제 저장소는 최첨단 음성 복제 기술을 실험하고 개발하기 위한 강력하고 접근 가능한 플랫폼을 제공합니다. 더 높은 오디오 품질을 제공하는 최신 유료 SaaS 솔루션도 있지만, 이 오픈 소스 프로젝트는 연구, 개발 및 사용자 정의를 위한 귀중한 도구를 제공합니다. SV2TTS 및 실시간 음성 합성의 기능을 탐구하는 데 관심이 있는 모든 사람에게 훌륭한 시작점이 될 것입니다.