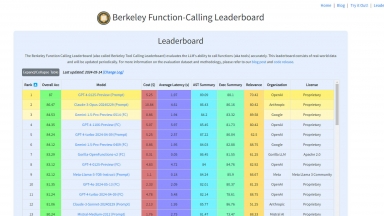

Berkeley Function-Calling Leaderboard

Berkeley Function-Calling Leaderboard

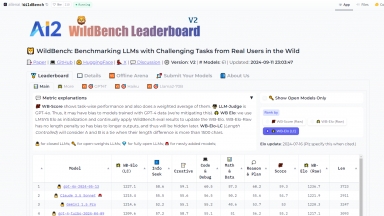

AI2 WildBench Leaderboard

AI2 WildBench Leaderboard

Berkeley Function-Calling Leaderboard

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,cdnjs,Fastly,Google Fonts,Bootstrap,GitHub Pages,Gzip,Varnish,YouTube |

| Tag | Llm Benchmark Leaderboard,Data Analysis,Data Visualization |

AI2 WildBench Leaderboard

| Launched | |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Llm Benchmark Leaderboard,Data Analysis,A/B Testing |

Berkeley Function-Calling Leaderboard Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

AI2 WildBench Leaderboard Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

Klu LLM Benchmarks - Данная таблица лидеров для оценки поставщиков LLM работает на основе данных Klu.ai в режиме реального времени, что позволяет выбрать оптимальный API и модель для ваших нужд.

Huggingface's Open LLM Leaderboard - Рейтинг открытых языковых моделей Huggingface направлен на поощрение открытого сотрудничества и прозрачности в оценке языковых моделей.

Scale Leaderboard - Рейтинг SEAL демонстрирует, что семейство больших языковых моделей (LLM) GPT от OpenAI занимает первое место в трех из четырех начальных областей, которые они используют для ранжирования моделей ИИ, а популярный Claude 3 Opus от Anthropic PBC занимает первое место в четвертой категории. Модели Gemini от Google LLC также показали хорошие результаты, разделив первое место с моделями GPT в паре областей.

LiveBench - LiveBench – это бенчмарк для больших языковых моделей (LLM) с ежемесячными новыми вопросами из различных источников и объективными ответами для точного оценивания. В настоящее время представлено 18 задач в 6 категориях, и в будущем их станет еще больше.

Hugging Face Agent Leaderboard - Выбирайте лучшего AI-агента, отвечающего вашим потребностям, с помощью Agent Leaderboard — объективного анализа производительности в реальных условиях, основанного на 14 критериях оценки.