LLM Outputs

LLM Outputs

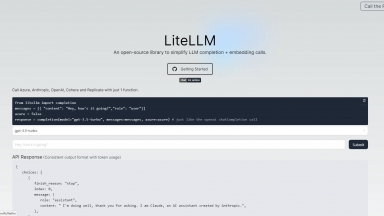

LiteLLM

LiteLLM

LLM Outputs

| Launched | 2024-08 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,Webflow,Amazon AWS CloudFront,Google Fonts,jQuery,Gzip,OpenGraph,HSTS |

| Tag | Data Analysis,Data Extraction,Data Enrichment |

LiteLLM

| Launched | 2023-08 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Next.js,Vercel,Webpack,HSTS |

| Tag | Gateway |

LLM Outputs Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

LiteLLM Rank/Visit

| Global Rank | 102564 |

| Country | United States |

| Month Visit | 482337 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

Deepchecks - Deepchecks: Комплексная платформа для оценки LLM. Систематически тестируйте, сравнивайте и отслеживайте ваши ИИ-приложения от разработки до продакшена. Минимизируйте галлюцинации и ускорьте внедрение.

Confident AI - Компании всех размеров используют Confident AI, чтобы обосновать, почему их LLM заслуживают места в процессе производства.

Traceloop - Traceloop — это инструмент мониторинга производительности приложений на основе больших языковых моделей (LLM). Режим реального времени, обратное тестирование, мгновенные оповещения. Поддерживает работу с несколькими провайдерами. Гарантирует надёжное развертывание LLM.

LazyLLM - LazyLLM: Low-code для мультиагентных LLM-приложений. Создавайте, итерируйте и развертывайте сложные ИИ-решения быстро — от прототипа до продакшена. Сосредоточьтесь на алгоритмах, а не на инжиниринге.

Humanloop - Управляйте своими подсказками, оценивайте цепочки, быстро создавайте приложения производственного уровня с помощью моделей крупного языка.