What is Ollama?

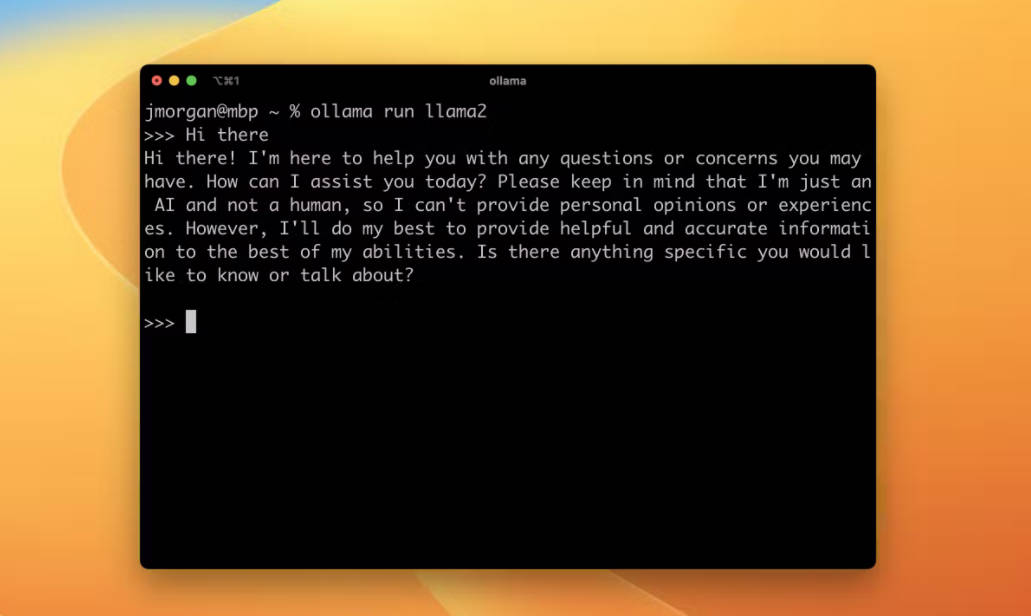

Ollama — это программное обеспечение, позволяющее пользователям запускать большие языковые модели локально. Оно доступно для macOS, Windows (через WSL2) и Linux & WSL2. Пользователи также могут устанавливать Ollama через Docker. Программа поддерживает список моделей с открытым исходным кодом, которые можно загрузить и настроить. Для запуска различных моделей требуется минимальный объем оперативной памяти. Ollama также предоставляет справочник CLI, REST API и интеграции с сообществом для удобства использования.

Ключевые особенности:

1. Локальная установка: Ollama позволяет пользователям запускать большие языковые модели локально на своих компьютерах, обеспечивая удобство и доступность.

2. Библиотека моделей: программа поддерживает множество моделей с открытым исходным кодом, которые можно загружать и использовать для разных целей. Пользователи могут выбирать из таких моделей, как Llama 2, Mistral, Dolphin Phi, Neural Chat и другие.

3. Настройка: пользователи могут настраивать модели, импортируя модели GGUF, изменяя подсказки и устанавливая параметры, такие как температура и системные сообщения.

Варианты использования:

1. Обработка естественного языка: Ollama можно эффективно использовать в задачах обработки естественного языка, таких как генерация текста, суммирование и анализ настроений. Возможность программы запускать большие языковые модели локально обеспечивает более быструю и эффективную обработку.

2. Разработка чат-ботов: благодаря библиотеке моделей и возможностям настройки Ollama разработчики могут создавать и обучать модели чат-ботов для различных приложений, включая поддержку клиентов, виртуальных помощников и интерактивные разговорные интерфейсы.

3. Исследования и разработки: Ollama предоставляет платформу для исследователей и разработчиков для экспериментов и улучшения языковых моделей. Гибкость программы и обширная библиотека моделей позволяют изучать различные подходы и методы в области обработки естественного языка.

Заключение:

Ollama — это мощный инструмент для запуска больших языковых моделей локально. Благодаря простому процессу установки, обширной библиотеке моделей и возможностям настройки пользователи могут эффективно выполнять задачи обработки естественного языка, разрабатывать чат-ботов и проводить исследования в этой области. Удобный пользовательский интерфейс и возможности интеграции делают программу ценным активом для специалистов в различных отраслях.

More information on Ollama

Top 5 Countries

Traffic Sources

Ollama Альтернативи

Больше Альтернативи-

-

Оптимизируйте развертывание Ollama с помощью Docker Compose. Погружайтесь в контейнеризированную среду, разработанную для простоты и эффективности.

-

-

-

OLMo 2 32B: LLM с открытым исходным кодом, способная потягаться с GPT-3.5! Бесплатный код, данные и веса. Исследуйте, настраивайте и создавайте более совершенный ИИ.