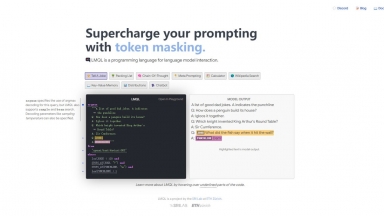

LMQL

LMQL

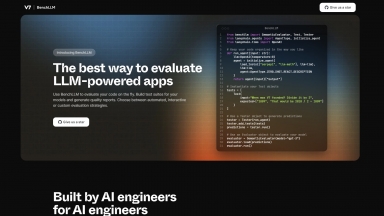

BenchLLM by V7

BenchLLM by V7

LMQL

| Launched | 2022-11 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Cloudflare Analytics,Fastly,Google Fonts,GitHub Pages,Highlight.js,jQuery,Varnish |

| Tag | Text Analysis |

BenchLLM by V7

| Launched | 2023-07 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Framer,Google Fonts,HSTS |

| Tag | Test Automation,Llm Benchmark Leaderboard |

LMQL Rank/Visit

| Global Rank | 2509184 |

| Country | United States |

| Month Visit | 8348 |

Top 5 Countries

Traffic Sources

BenchLLM by V7 Rank/Visit

| Global Rank | 12812835 |

| Country | United States |

| Month Visit | 961 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

LM Studio - LM Studio es una aplicación de escritorio fácil de usar para experimentar con Modelos de Lenguaje Grandes (LLMs) locales y de código abierto. La aplicación de escritorio multiplataforma LM Studio permite descargar y ejecutar cualquier modelo compatible con ggml de Hugging Face, y proporciona una interfaz de usuario (UI) sencilla pero potente para la configuración e inferencia de modelos. La aplicación aprovecha tu GPU cuando es posible.

LLMLingua - Para acelerar la inferencia de los LLM y mejorar la percepción de los LLM de información clave, comprime el indicador y KV-Cache, que logra una compresión de hasta 20 veces con una pérdida de rendimiento mínima.

LazyLLM - LazyLLM: Bajo código para aplicaciones LLM multiagente. Desarrolle, itere y despliegue soluciones de IA complejas con rapidez, desde el prototipo hasta la producción. Céntrese en los algoritmos, no en la ingeniería.

vLLM - Un motor de inferencia y servicio de alto rendimiento y bajo consumo de memoria para LLM

LLM-X - ¡Revolucione el desarrollo de LLM con LLM-X! Integre sin problemas grandes modelos de lenguaje en su flujo de trabajo con una API segura. Aumente la productividad y desbloquee el poder de los modelos de lenguaje para sus proyectos.