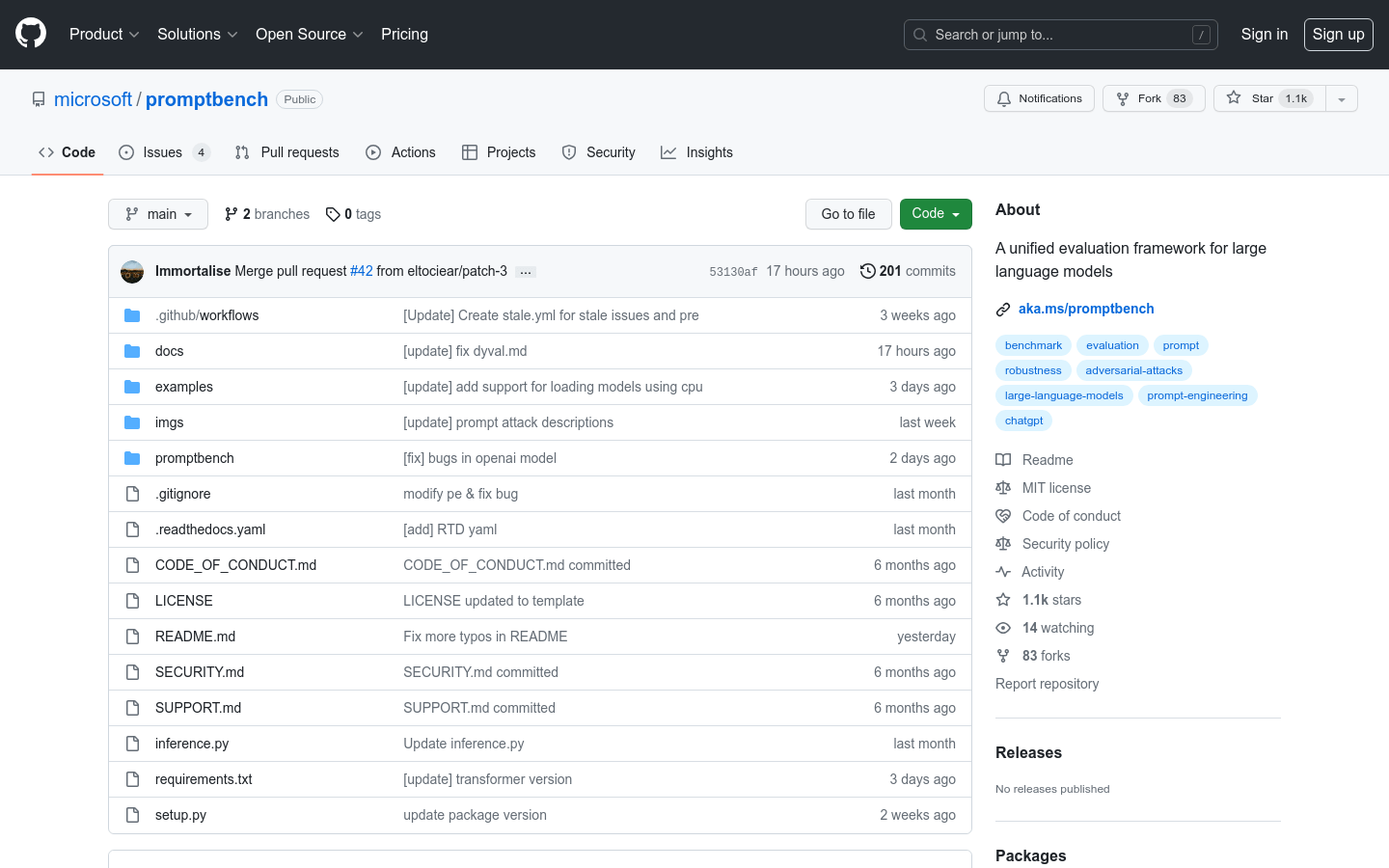

What is promptbench?

PromptBench es un paquete de Python basado en Pytorch que permite a los investigadores evaluar Modelos de Lenguaje Grande (LLM) fácilmente. Ofrece API fáciles de usar para la evaluación del rendimiento del modelo, la ingeniería de indicaciones, la evaluación de indicaciones adversarias y la evaluación dinámica. Con soporte para varios conjuntos de datos, modelos y métodos de ingeniería de indicaciones, PromptBench es una herramienta versátil para evaluar y analizar LLM.

Características principales:

1. Evaluación rápida del rendimiento del modelo: PromptBench proporciona una interfaz fácil de usar para construir modelos, cargar conjuntos de datos y evaluar el rendimiento del modelo de manera eficiente.

2. Ingeniería de indicaciones: El software implementa varios métodos de ingeniería de indicaciones, como Few-shot Chain-of-Thought, Emotion Prompt y Expert Prompting, lo que permite a los investigadores mejorar el rendimiento del modelo.

3. Ataques de indicaciones adversarias: PromptBench integra ataques de indicaciones, lo que permite a los investigadores simular ataques de indicaciones adversarias de caja negra en modelos y evaluar su solidez.

Casos de uso:

1. Evaluación del modelo: Los investigadores pueden usar PromptBench para evaluar los LLM en puntos de referencia existentes como GLUE, SQuAD V2 y CSQA, lo que permite un análisis integral y una comparación del rendimiento del modelo.

2. Investigación de ingeniería de indicaciones: PromptBench facilita la exploración de diferentes técnicas de indicación, incluidas Chain-of-Thought y EmotionPrompt, lo que ayuda a los investigadores a mejorar las capacidades del modelo para tareas específicas.

3. Pruebas de robustez: Con los ataques de indicaciones integrados, PromptBench permite a los investigadores evaluar la robustez de los LLM frente a indicaciones adversarias, lo que respalda el desarrollo de modelos más seguros y confiables.

Conclusión:

PromptBench ofrece una solución integral y fácil de usar para evaluar los Modelos de Lenguaje Grande. Con su interfaz fácil de usar, soporte para varios conjuntos de datos y modelos y capacidades de ingeniería de indicaciones, los investigadores pueden evaluar el rendimiento del modelo, explorar diferentes técnicas de indicación y evaluar la robustez del modelo. Al proporcionar un marco de evaluación versátil, PromptBench contribuye al avance de la investigación y el desarrollo de LLM.

More information on promptbench

promptbench Alternativas

Más Alternativas-

Mejora el rendimiento del Modelo de lenguaje con promptfoo. Itera más rápido, mide las mejoras en calidad, detecta regresiones y más. Perfecto para investigadores y desarrolladores.

-

PromptLayer es la primera plataforma que te permite seguir y gestionar tu ingeniería de indicaciones GPT.

-

Mejora los modelos de lenguaje con Prompt Refine, una herramienta fácil de usar para experimentos rápidos. Ejecuta, rastrea y compara experimentos con facilidad.

-

Descubre indicaciones óptimas de IA con Prompter, una poderosa herramienta para depuración y optimización. Optimiza tu proceso de desarrollo y mejora la precisión del modelo.

-

Encuentra las mejores indicaciones, produce mejores resultados, ahorra en costes de API, vende tus propias indicaciones. DALL·E, GPT-3, Midjourney, Stable Diffusion Prompt Marketplace.