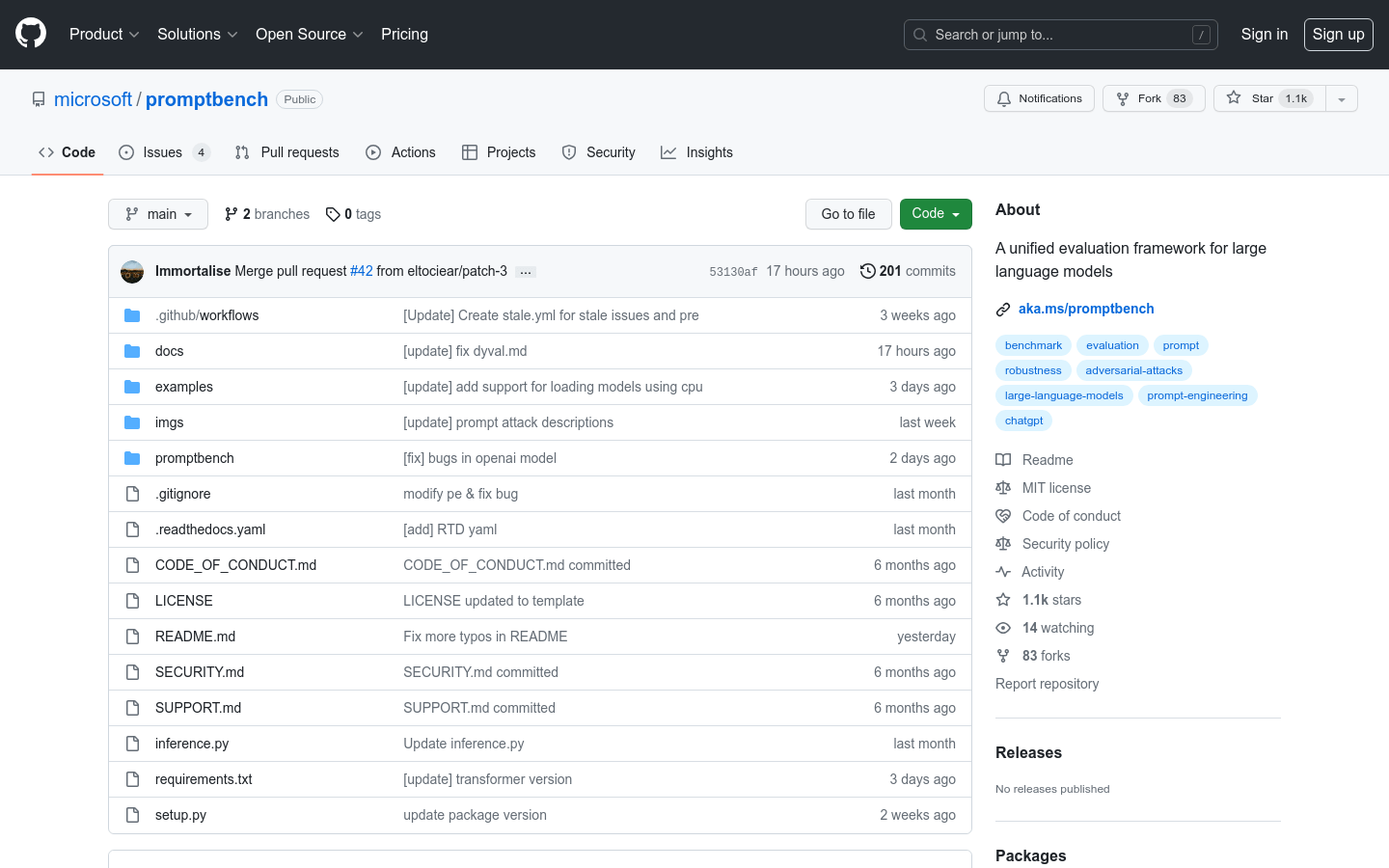

What is Promptbench?

PromptBenchは、大規模言語モデル(LLM)を簡単に評価できるPytorchベースのPythonパッケージです。モデルのパフォーマンス評価、プロンプトエンジニアリング、対抗プロンプトの評価、動的評価用の使いやすいAPIを提供します。PromptBenchは、さまざまなデータセット、モデル、プロンプトエンジニアリング手法に対応しており、LLMの評価と分析に役立つ多用途ツールです。

主な特長:

1. 迅速なモデルパフォーマンス評価:PromptBenchは、モデルの構築、データセットの読み込み、モデルパフォーマンスの効率的な評価のための使いやすいインターフェースを提供します。

2. プロンプトエンジニアリング:このソフトウェアは、少数のChain-of-Thought、Emotion Prompt、Expert Promptingなどのプロンプトエンジニアリング手法を実装しており、研究者はモデルパフォーマンスを向上させることができます。

3. 対抗プロンプト攻撃:PromptBenchはプロンプト攻撃を統合しており、研究者はモデルに対するブラックボックスの対抗プロンプト攻撃をシミュレートし、その堅牢性を評価できます。

ユースケース:

1. モデル評価:研究者はPromptBenchを使用して、GLUE、SQuAD V2、CSQAなどの既存のベンチマークでLLMを評価し、モデルパフォーマンスの包括的な分析と比較を行うことができます。

2. プロンプトエンジニアリングの調査:PromptBenchは、Chain-of-ThoughtやEmotionPromptなどのさまざまなプロンプティング手法の調査を容易にし、研究者が特定のタスクに対するモデルの機能を向上させるのに役立ちます。

3. 堅牢性のテスト:統合されたプロンプト攻撃により、PromptBenchは研究者が対抗プロンプトに対するLLMの堅牢性を評価し、より安全で信頼性の高いモデルの開発をサポートできます。

結論:

PromptBenchは、大規模言語モデルを評価するための使いやすい包括的なソリューションを提供します。使いやすいインターフェース、さまざまなデータセットとモデルのサポート、プロンプトエンジニアリング機能により、研究者はモデルパフォーマンスの評価、さまざまなプロンプティング手法の調査、モデルの堅牢性の評価を行うことができます。PromptBenchは多用途な評価フレームワークを提供することで、LLMの研究と開発の進歩に貢献しています。