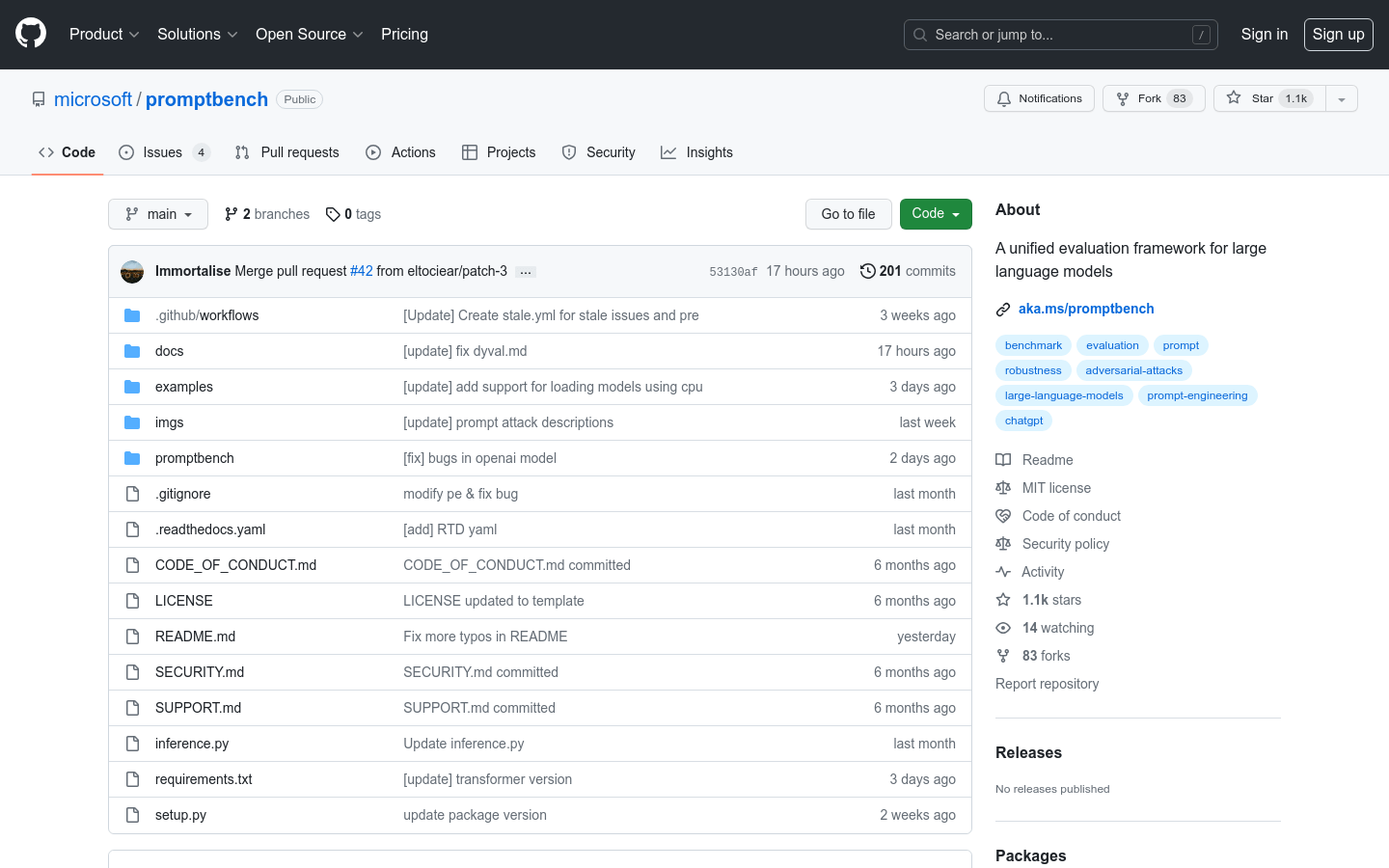

What is Promptbench?

PromptBench est un paquet Python basé sur Pytorch qui permet aux chercheurs d’évaluer facilement les grands modèles de langage (LLM). Il offre des API conviviales pour l’évaluation de performance du modèle, l’ingénierie des invites, l’évaluation d’invites adverses et l’évaluation dynamique. Avec la prise en charge de divers ensembles de données, modèles et méthodes d’ingénierie des invites, PromptBench est un outil polyvalent pour l’évaluation et l’analyse des LLM.

Caractéristiques principales :

1. Évaluation rapide de la performance du modèle : PromptBench fournit une interface conviviale pour créer des modèles, charger des ensembles de données et évaluer efficacement la performance du modèle.

2. Ingénierie des invites : Le logiciel met en œuvre plusieurs méthodes d’ingénierie des invites, telles que Few-shot Chain-of-Thought, Emotion Prompt et Expert Prompting, permettant aux chercheurs d’améliorer la performance du modèle.

3. Attaques d’invites adverses : PromptBench intègre des attaques d’invites, permettant aux chercheurs de simuler des attaques d’invites adverses de type boîte noire sur les modèles et d’évaluer leur robustesse.

Cas d’utilisation :

1. Évaluation du modèle : Les chercheurs peuvent utiliser PromptBench pour évaluer les LLM sur des références existantes comme GLUE, SQuAD V2 et CSQA, permettant une analyse complète et une comparaison des performances du modèle.

2. Recherche sur l’ingénierie des invites : PromptBench facilite l’exploration de différentes techniques d’invite, notamment Chain-of-Thought et EmotionPrompt, aidant les chercheurs à améliorer les capacités du modèle pour des tâches spécifiques.

3. Tests de robustesse : Avec les attaques d’invites intégrées, PromptBench permet aux chercheurs d’évaluer la robustesse des LLM contre les invites adverses, soutenant le développement de modèles plus sûrs et plus fiables.

Conclusion :

PromptBench offre une solution conviviale et complète pour évaluer les grands modèles de langage. Grâce à son interface facile à utiliser, à sa prise en charge de divers ensembles de données et modèles, ainsi qu’à ses capacités d’ingénierie des invites, les chercheurs peuvent évaluer la performance du modèle, explorer différentes techniques d’invite et évaluer la robustesse du modèle. En fournissant un cadre d’évaluation polyvalent, PromptBench contribue à l’avancement de la recherche et du développement des LLM.

More information on Promptbench

Promptbench Alternatives

Plus Alternatives-

Lancez plus rapidement vos produits d'IA grâce aux évaluations LLM sans code. Comparez plus de 180 modèles, concevez des invites et testez en toute confiance.

-

Améliorez les modèles de langage avec Prompt Refine : un outil convivial pour les expérimentations rapides. Exécutez, suivez et comparez les expériences facilement.

-

Rationalisez l'ingénierie des prompts LLM. PromptLayer propose la gestion, l'évaluation et l'observabilité sur une seule plateforme. Créez de meilleures IA, plus vite.

-

-

PromptTools est une plateforme open-source qui aide les développeurs à construire, surveiller et améliorer les applications LLM grâce à l'expérimentation, l'évaluation et la rétroaction.