What is Tokenomy?

Trabajar con Modelos de Lenguaje Extensos (LLMs) como los de OpenAI, Anthropic, Google y otros, ofrece un potencial increíble, pero gestionar los costes y el rendimiento asociados puede resultar complejo. Comprender cómo tus prompts se traducen en tokens, y cómo esto impacta tanto en tu presupuesto como en la respuesta del modelo, es crucial para una implementación eficiente de la IA.

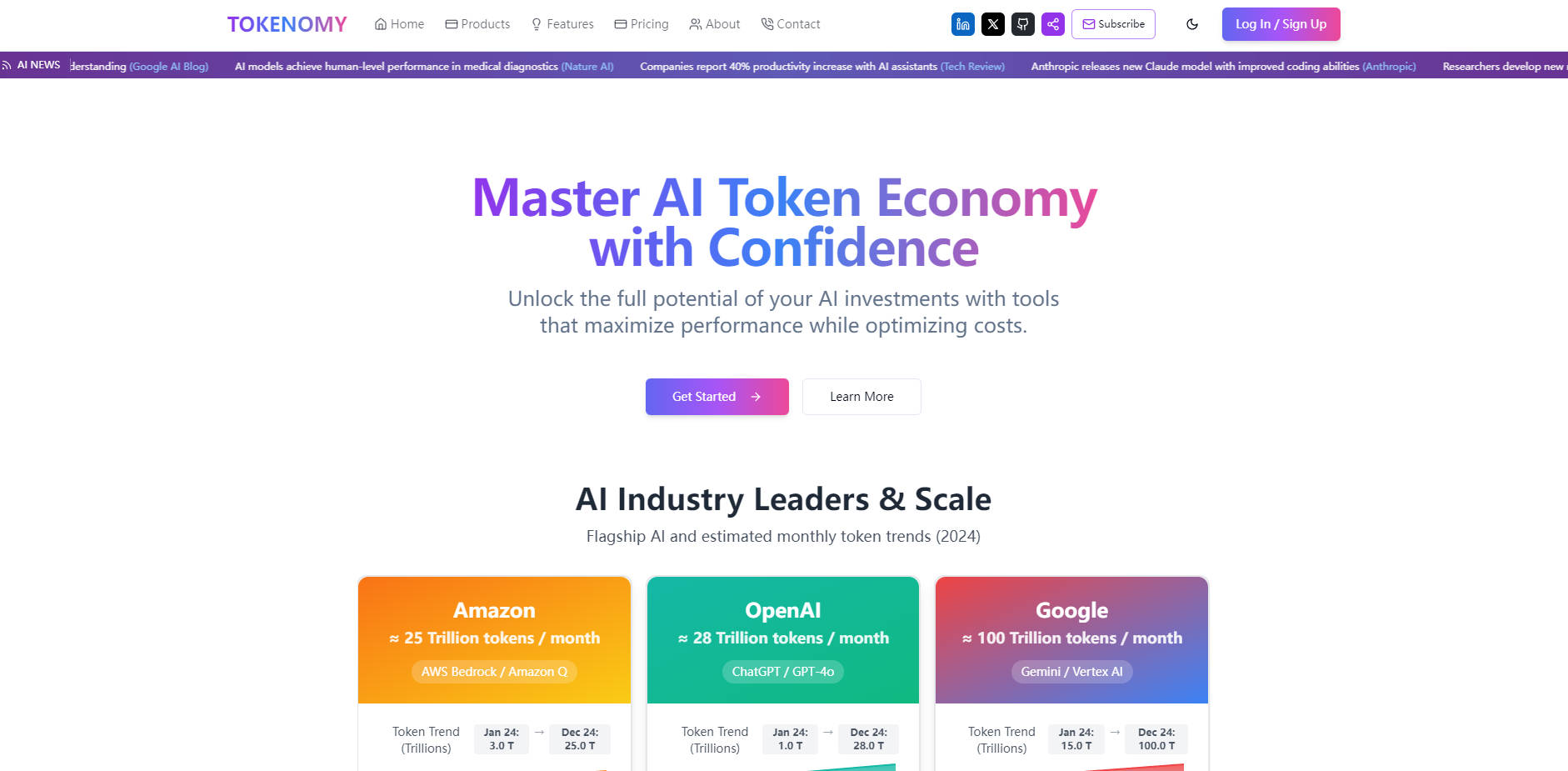

Tokenomy proporciona las herramientas que necesitas para obtener claridad y control sobre el uso de tus tokens de IA. Está diseñado para ayudarte a analizar, optimizar y gestionar tus interacciones con las APIs de LLM, lo que en última instancia conduce a decisiones más inteligentes y a un ahorro de costes potencialmente significativo.

Funciones Clave para una Gestión Inteligente de Tokens

Cálculo Preciso de Tokens: 🧮 Obtén recuentos precisos de tokens para tu contenido en varios modelos de IA importantes. Este paso fundamental te ayuda a comprender el "tamaño" real de tu entrada y salida, esencial para optimizar la longitud y la complejidad del prompt.

Estimación Precisa de Costes: 💰 Visualiza inmediatamente el coste estimado de tus llamadas a la API basándote en los precios actuales de los principales proveedores. Esto te permite predecir gastos, comparar los costes de los modelos para la misma tarea y tomar decisiones presupuestarias informadas antes de ejecutar trabajos costosos.

Herramientas de Comparación de Modelos: ⚖️ Compara fácilmente diferentes modelos de IA en paralelo. Analiza cómo el mismo contenido se tokeniza y se comporta en modelos como GPT-4o, Claude 3, Gemini y otros, lo que te ayudará a encontrar el mejor equilibrio entre rendimiento y coste para tus necesidades específicas.

Análisis de Tokenización: 👀 Visualiza cómo los diferentes modelos descomponen tu texto en tokens. Comprender estas diferencias es clave para crear prompts eficientes que minimicen el recuento de tokens, maximizando al mismo tiempo la comprensión del modelo y la calidad de la salida.

Simulación de Velocidad: ⏱️ Simula las velocidades de procesamiento del modelo para tu contenido. Obtén información sobre la latencia potencial y optimiza tus solicitudes para obtener tiempos de respuesta más rápidos, lo cual es crucial para aplicaciones en tiempo real o funciones orientadas al usuario.

Visualizaciones Interactivas: 📊 Explora tus patrones de uso de tokens, costes y resultados de análisis a través de gráficos claros. Los datos visuales facilitan la identificación de tendencias, la localización de áreas de optimización y la comunicación de información a tu equipo.

Casos Prácticos de Uso

Desarrollo de una Nueva Función de IA: Como desarrollador, planificar una nueva aplicación que utilice una API de LLM requiere comprender los costes y el rendimiento potenciales. Utiliza Tokenomy para estimar el coste por interacción del usuario, comparar diferentes modelos en cuanto a velocidad y eficiencia, y asegurarte de que la estructura de tu prompt esté optimizada para tokens antes de la implementación.

Optimización de los Flujos de Trabajo de Generación de Contenido: Un equipo de contenido que utiliza LLMs para redactar o resumir puede utilizar Tokenomy para analizar la eficacia del prompt. Al comprender cómo las diferentes formulaciones o instrucciones impactan en el recuento de tokens y en el coste, pueden refinar sus prompts para obtener mejores resultados de forma más económica.

Análisis y Reducción de los Gastos de LLM: Para las empresas con un uso significativo de la API de LLM, Tokenomy proporciona una forma de analizar los patrones generales de gasto. Identifica qué tipos de solicitudes o qué modelos están consumiendo la mayor cantidad de tokens y presupuesto, y luego utiliza las herramientas de optimización para implementar estrategias de ahorro de costes en todas tus operaciones.

Conclusión

Tokenomy proporciona visibilidad y control esenciales en el complejo mundo de los tokens de IA. Al ofrecer un cálculo preciso, un análisis detallado y una visualización clara, te ayuda a superar las conjeturas para gestionar con confianza tus costes de LLM, optimizar el rendimiento y construir aplicaciones de IA más eficientes. Obtén una comprensión más profunda de tu uso de la IA y toma decisiones basadas en datos para maximizar tu inversión.

More information on Tokenomy

Tokenomy Alternativas

Tokenomy Alternativas-

Herramienta en línea para contar tokens de modelos y avisos de OpenAI. Asegúrate de que tu aviso se ajuste a los límites de tokens del modelo que estás utilizando.

-

Calcula y compara el costo de usar las APIs de OpenAI, Azure, Anthropic Claude, Llama 3, Google Gemini, Mistral y Cohere LLM para tu proyecto de IA con nuestra calculadora gratuita, simple y potente. Números actualizados a mayo de 2024.

-

Token Counter es una herramienta de IA diseñada para contar el número de tokens en un texto dado. Los tokens son las unidades individuales de significado, como palabras o signos de puntuación, que procesan los modelos de lenguaje.

-

Tiktokenizer simplifica el desarrollo de IA con seguimiento de tokens en tiempo real, visualizador integrado, integración API fluida y mucho más. Optimiza costes y rendimiento.

-

Administra tu presupuesto de API de OpenAI con AiPrice. Calcula con exactitud el recuento de tokens, analiza los costos y toma decisiones informadas. Optimiza tu uso ahora.