What is Tokenomy?

使用大型语言模型 (LLM),如来自 OpenAI、Anthropic、Google 等公司的产品,蕴藏着巨大的潜力,但管理相关的成本和性能可能让人感到复杂。要高效地实施 AI,关键在于了解你的提示如何转化为 tokens,以及这如何影响你的预算和模型的响应。

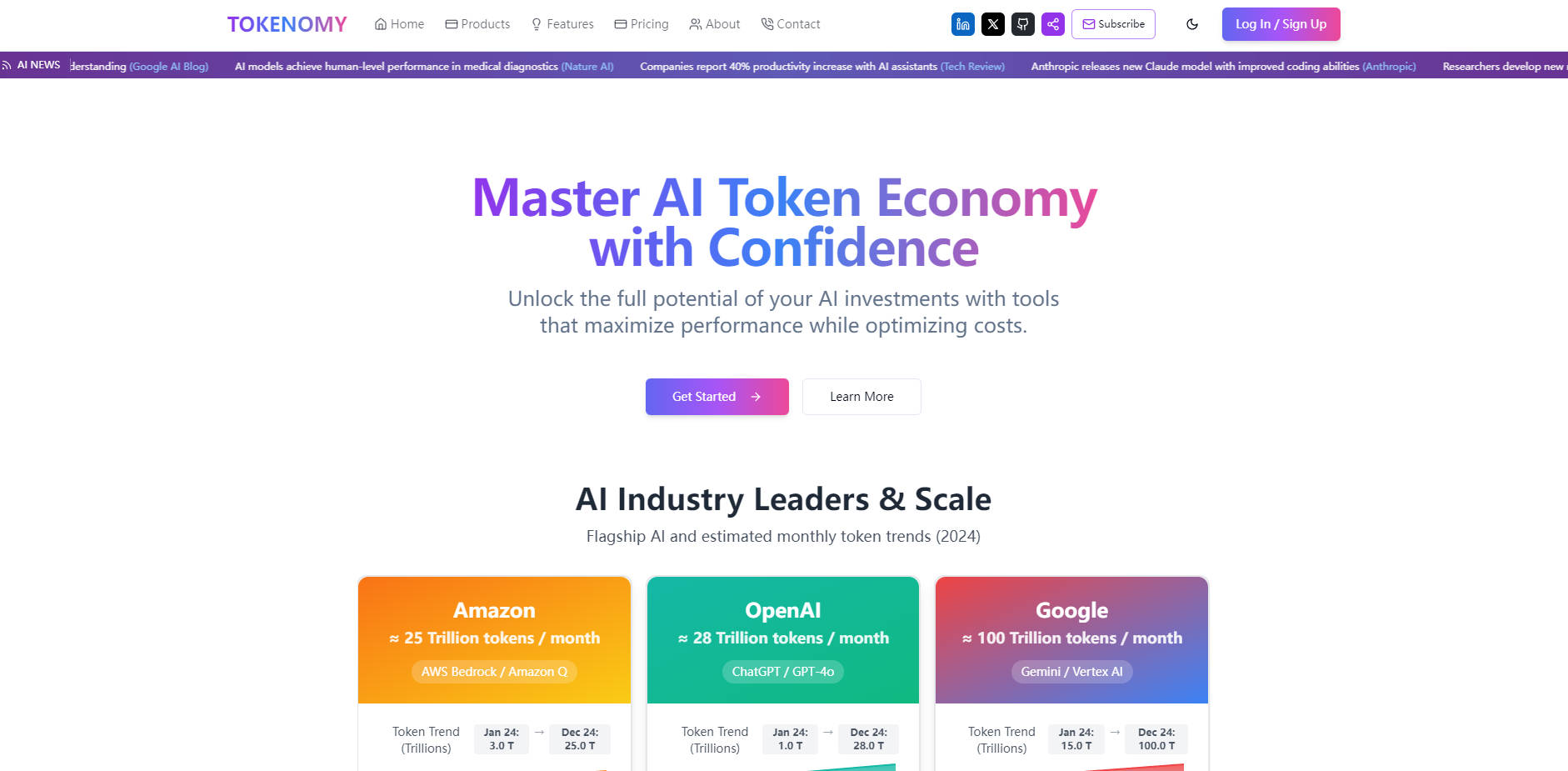

Tokenomy 提供你所需的工具,让你清晰地了解和控制你的 AI token 使用情况。它旨在帮助你分析、优化和管理你与 LLM API 的交互,最终促成更明智的决策,并可能显著节省成本。

智能 Token 管理的关键特性

精确的 Token 计算: 🧮 获得各种主要 AI 模型内容的精确 token 计数。这一基本步骤可帮助你了解输入和输出的真实“大小”,这对于优化提示的长度和复杂性至关重要。

准确的成本估算: 💰 立即根据主要提供商的当前定价查看 API 调用的估计成本。这使你能够在运行昂贵的任务之前预测费用、比较同一任务的模型成本,并做出明智的预算决策。

模型比较工具: ⚖️ 轻松地并排比较不同的 AI 模型。分析相同的内容如何在 GPT-4o、Claude 3、Gemini 等模型中进行 token 化和执行,帮助你找到性能和成本之间的最佳平衡点,以满足你的特定需求。

Token 化分析: 👀 可视化不同的模型如何将你的文本分解为 tokens。了解这些差异是制定有效提示的关键,这些提示可以最大限度地减少 token 计数,同时最大限度地提高模型的理解和输出质量。

速度模拟: ⏱️ 模拟你的内容处理模型速度。深入了解潜在的延迟并优化你的请求以获得更快的响应时间,这对于实时应用程序或面向用户的功能至关重要。

交互式可视化: 📊 通过清晰的图表探索你的 token 使用模式、成本和分析结果。可视化数据使你更容易识别趋势、查明需要优化的领域,并将见解传达给你的团队。

实际用例

开发新的 AI 功能: 作为开发人员,规划使用 LLM API 的新应用程序需要了解潜在的成本和性能。使用 Tokenomy 估算每次用户交互的成本,比较不同模型的速度和效率,并确保你的提示结构在部署之前经过 token 优化。

优化内容生成工作流程: 使用 LLM 进行起草或总结的内容团队可以使用 Tokenomy 来分析提示的有效性。通过了解不同的措辞或指令如何影响 token 计数和成本,他们可以优化他们的提示,以更经济地获得更好的结果。

分析和降低 LLM 费用: 对于 LLM API 使用量巨大的企业,Tokenomy 提供了一种分析总体支出模式的方法。确定哪些类型的请求或哪些模型消耗了最多的 tokens 和预算,然后使用优化工具在你的运营中实施节省成本的策略。

结论

Tokenomy 在复杂的 AI token 世界中提供了必要的可见性和控制力。通过提供精确的计算、详细的分析和清晰的可视化,它帮助你摆脱猜测,自信地管理你的 LLM 成本,优化性能,并构建更高效的 AI 应用程序。更深入地了解你的 AI 使用情况,并做出数据驱动的决策,以最大限度地提高你的投资。