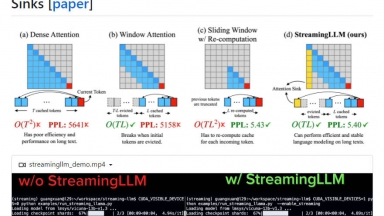

StreamingLLM

StreamingLLM

LMCache

StreamingLLM

| Launched | 2024 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | |

| Tag | Workflow Automation,Developer Tools,Communication |

LMCache

| Launched | 2024-10 |

| Pricing Model | Free |

| Starting Price | |

| Tech used | Google Analytics,Google Tag Manager,cdnjs,Cloudflare CDN,Fastly,Google Fonts,GitHub Pages,Gzip,HTTP/3,Varnish |

| Tag | Infrastructure,Data Pipelines,Developer Tools |

StreamingLLM Rank/Visit

| Global Rank | |

| Country | |

| Month Visit |

Top 5 Countries

Traffic Sources

LMCache Rank/Visit

| Global Rank | 475554 |

| Country | China |

| Month Visit | 59830 |

Top 5 Countries

Traffic Sources

Estimated traffic data from Similarweb

What are some alternatives?

vLLM - Un moteur d'inférence et de service à haut débit et économe en mémoire pour les LLM

EasyLLM - EasyLLM est un projet open source qui fournit des outils et méthodes utiles pour travailler avec des modèles de langage volumineux (LLM), open source et fermés. Commencez immédiatement ou consultez la documentation.

LLMLingua - Pour accélérer l'inférence LLM et améliorer la perception des informations clés de LLM, compressez l'invite et KV-Cache, ce qui permet d'obtenir une compression jusqu'à 20x avec une perte de performance minimale.

LazyLLM - LazyLLM : Le low-code pour les applications LLM multi-agents. Créez, itérez et déployez rapidement des solutions d'IA complexes, du prototype à la production. Concentrez-vous sur les algorithmes, et non sur l'ingénierie.