What is Koboldcpp?

KoboldCpp est un logiciel puissant et convivial de génération de texte par IA, conçu pour les modèles GGML et GGUF. Basé sur llama.cpp et inspiré par KoboldAI, il offre un point d'accès API polyvalent, la génération d'images Stable Diffusion, des capacités de transcription vocale et une interface utilisateur riche en fonctionnalités. Avec la prise en charge d'histoires persistantes, d'outils d'édition, de la mémoire, d'informations sur le monde et de la personnalisation des personnages, KoboldCpp est une solution complète pour l'écriture créative, les jeux de rôle et l'expérimentation en IA. Ses exécutables mono-fichier pour Windows, Linux et MacOS facilitent son installation et son utilisation, tandis que des fonctionnalités avancées telles que l'accélération GPU et la compatibilité descendante garantissent une flexibilité pour les débutants comme pour les experts.

Fonctionnalités clés :

?️ Point d'accès API polyvalent : S'intègre parfaitement à KoboldAI et KoboldAI Lite, offrant une API robuste pour la génération et la personnalisation de texte.

?️ Génération d'images Stable Diffusion : Générez des images de haute qualité en parallèle du texte, élargissant ainsi les possibilités créatives.

?️ Prise en charge de la transcription vocale : Convertissez la parole en texte, améliorant ainsi l'accessibilité et la convivialité.

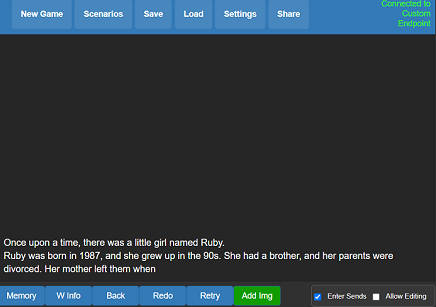

? Histoires persistantes et outils d'édition : Enregistrez, modifiez et poursuivez vos histoires grâce à des outils avancés tels que la mémoire, les informations sur le monde et les profils de personnages.

⚙️ Accélération GPU et compatibilité descendante : Optimisez les performances grâce à la prise en charge du GPU et exécutez les anciens modèles GGML sans problème.

Cas d'utilisation :

Écriture créative et jeux de rôle : Les écrivains et les joueurs de rôle peuvent créer des histoires immersives grâce à une mémoire persistante, au développement des personnages et aux outils de création de mondes.

Expérimentation en IA : Les développeurs et les chercheurs peuvent tester et affiner les modèles GGUF, en tirant parti de l'accélération GPU pour des résultats plus rapides.

Projets multimédias : Combinez la génération de texte et d'images pour des projets uniques tels que la narration interactive ou la création de contenu assistée par IA.

Conclusion :

KoboldCpp est une solution tout-en-un polyvalente pour la génération de texte par IA, offrant des fonctionnalités avancées telles que Stable Diffusion, la transcription vocale et l'accélération GPU. Que vous soyez écrivain, développeur ou passionné d'IA, KoboldCpp vous fournit les outils et la flexibilité nécessaires pour donner vie à vos idées. Sa facilité d'utilisation, combinée à ses puissantes capacités, en fait un incontournable pour tous ceux qui explorent la créativité pilotée par l'IA.

More information on Koboldcpp

Koboldcpp Alternatives

Plus Alternatives-

-

Découvrez comment TextGen révolutionne les tâches de génération de langage avec une compatibilité étendue des modèles. Créez du contenu, développez des chatbots et augmentez les ensembles de données sans effort.

-

Générez des images IA sur votre GPU Windows gratuitement avec NMKD Stable Diffusion GUI. Prend en charge la conversion de texte en image, d'image en image et plus encore. Pas d'installation complexe.

-

Boostez votre expérience de codage avec Code GPT, une extension d'IA open-source pour les EDI. Obtenez une assistance pour le codage, générez de la documentation et traduisez des langues sans effort.

-

Accès abordable à GPT-4, Claude 3, Gemini, MistralAI, DALL-E 3, Stable Diffusion, synthèse vocale et analyse d'images