What is Koboldcpp?

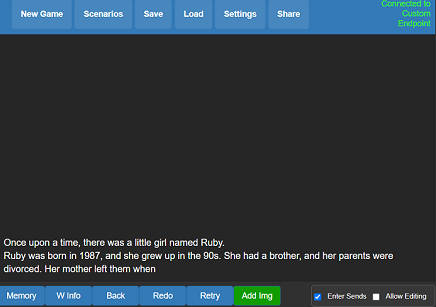

KoboldCpp — мощное и удобное программное обеспечение для генерации текста на основе ИИ, разработанное для моделей GGML и GGUF. Созданное на базе llama.cpp и вдохновлённое KoboldAI, оно предлагает универсальный API-endpoint, генерацию изображений с помощью Stable Diffusion, функции преобразования речи в текст и богатый функционал пользовательского интерфейса. Поддержка сохранения историй, инструменты редактирования, память, информация о мире и настройка персонажей делают KoboldCpp комплексным решением для творческого письма, ролевых игр и экспериментов с ИИ. Однофайловые исполняемые файлы для Windows, Linux и MacOS упрощают установку и использование, а такие расширенные функции, как ускорение на GPU и обратная совместимость, обеспечивают гибкость как для новичков, так и для экспертов.

Ключевые особенности:

?️ Универсальный API-endpoint: Бесшовная интеграция с KoboldAI и KoboldAI Lite, предоставляющая надёжный API для генерации текста и его настройки.

?️ Генерация изображений с помощью Stable Diffusion: Генерируйте высококачественные изображения вместе с текстом, расширяя творческие возможности.

?️ Поддержка преобразования речи в текст: Преобразуйте устную речь в текст, повышая доступность и удобство использования.

? Сохранение историй и инструменты редактирования: Сохраняйте, редактируйте и продолжайте истории с помощью таких продвинутых инструментов, как память, информация о мире и профили персонажей.

⚙️ Ускорение на GPU и обратная совместимость: Оптимизируйте производительность с помощью поддержки GPU и запускайте старые модели GGML без проблем.

Сферы применения:

Творческое письмо и ролевые игры: Писатели и ролевики могут создавать захватывающие истории с постоянной памятью, развитием персонажей и инструментами построения мира.

Эксперименты с ИИ: Разработчики и исследователи могут тестировать и дорабатывать модели GGUF, используя ускорение на GPU для более быстрых результатов.

Мультимедийные проекты: Объединяйте генерацию текста и изображений для уникальных проектов, таких как интерактивное повествование или создание контента с помощью ИИ.

Заключение:

KoboldCpp — универсальное комплексное решение для генерации текста с помощью ИИ, предлагающее расширенные функции, такие как Stable Diffusion, преобразование речи в текст и ускорение на GPU. Независимо от того, являетесь ли вы писателем, разработчиком или энтузиастом ИИ, KoboldCpp предоставляет инструменты и гибкость для воплощения ваших идей в жизнь. Простота использования в сочетании с мощными возможностями делает его обязательным к тестированию для всех, кто изучает творчество, управляемое ИИ.

More information on Koboldcpp

Koboldcpp Альтернативи

Больше Альтернативи-

-

Узнайте, как TextGen революционизирует задачи генерации языка благодаря широкой совместимости моделей. Создавайте контент, разрабатывайте чат-боты и дополняйте наборы данных без особых усилий.

-

Создавайте AI-изображения бесплатно на вашей Windows GPU с NMKD Stable Diffusion GUI. Поддерживает текст-в-изображение, изображение-в-изображение и многое другое. Без сложной установки.

-

Повышайте эффективность кодирования с помощью Code GPT — расширения с открытым исходным кодом для IDE, работающего на основе искусственного интеллекта. Получайте помощь в написании кода, создавайте документацию и переводите языки без труда.

-

Доступный доступ к GPT-4, Claude 3, Gemini, MistralAI, DALL-E 3, Stable Diffusion, Text to Speech & Image Analysis