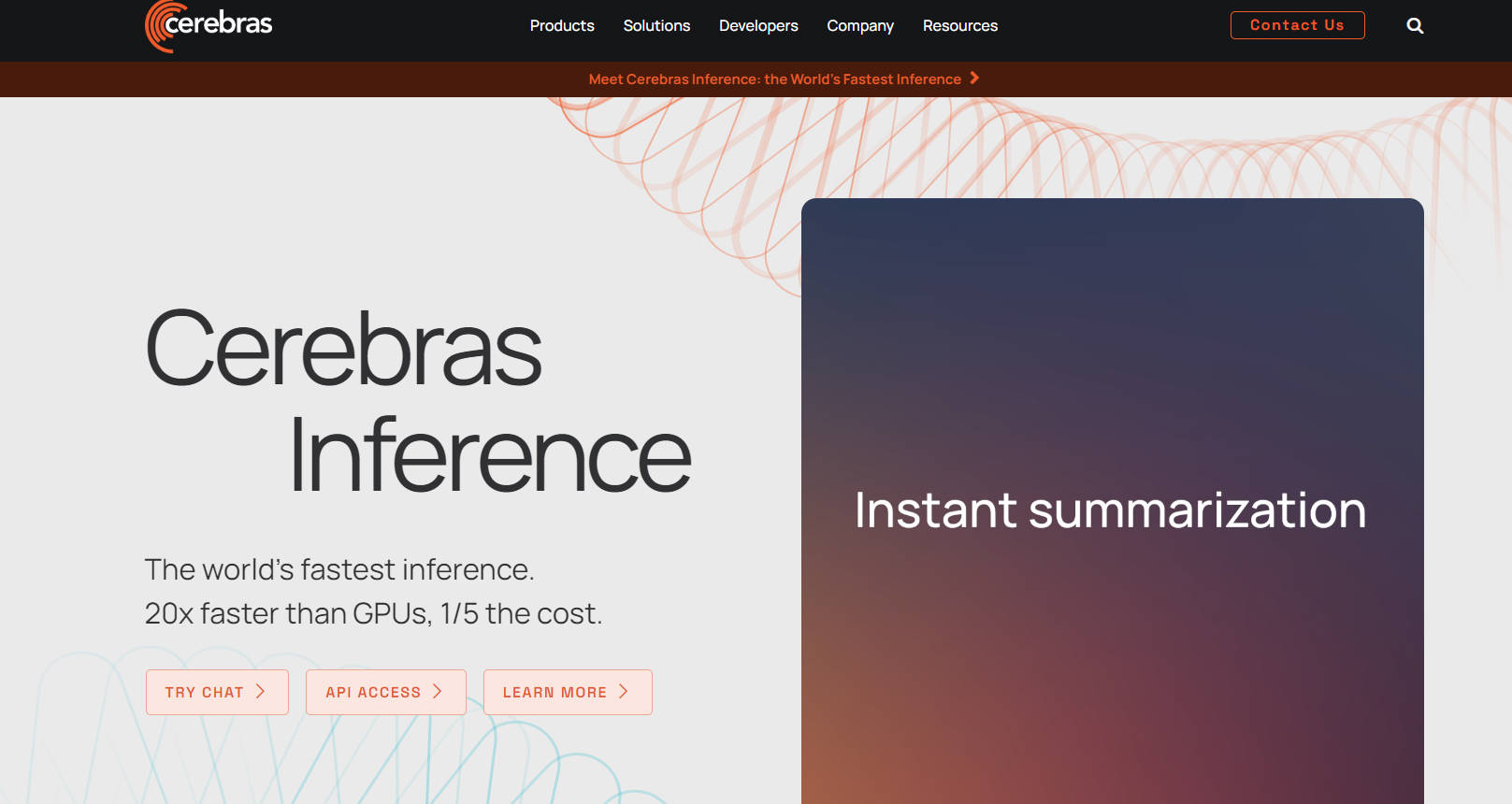

What is Cerebras Inference?

Cerebras Inferenceは、人工知能の効率を革新し、GPUよりも20倍速く、コストは5分の1という驚異的な速度を誇り、比類のない存在です。AIの能力を再定義する受賞歴のあるテクノロジーを搭載したこの最先端のソリューションは、モデルのトレーニングを前例のないレベルにまで加速します。90万コアと44GBのオンチップメモリを備えたCS-3システムは、複数のコンピューティング分野においてパフォーマンスの障壁を打ち破ります。Cerebrasは、AIを科学から戦略へと高め、境界線を押し広げ、複雑なAIプロジェクトをよりアクセスしやすく、費用対効果の高いものにします。

主な機能:

超音速推論速度: Cerebras Inferenceは、業界をリードするGPUの20倍の速度で高速な演算を提供し、大量かつ時間制約のあるアプリケーションを変革します。

費用対効果の高いAI処理: GPUの代替手段の5分の1のコストで効率を実現し、高度なAIテクノロジーへのアクセスを民主化します。

CS-3によるスケーラブルなコンピューティング: 90万コアと44GBのオンチップメモリを活用して、比類のないデータ処理を実現し、需要の高いコンピューティングタスクに優れたパフォーマンスを発揮します。

基盤モデルと微調整済みモデル: Llama 3.1、Llama 2、医療およびコーディングアプリケーション向けの専門モデルなど、すぐに使用できるモデルのスイートでAI機能を拡張します。

シームレスな統合: 医療、ライフサイエンス、エネルギーなど、AIモデルのトレーニングと推論を促進し、モデル開発と展開全体で専門的なサポートを提供します。

ユースケース:

ヘルスケアとライフサイエンス: ゲノミクスとプロテオミクスの研究におけるブレークスルーを加速し、創薬と個別化医療を迅速化します。

スーパーコンピュータアプリケーション: 地震処理とモンテカルロシミュレーションのランタイムを数日から数時間に短縮し、高性能コンピューティングにおけるリソースの利用を最適化します。

多言語AIアシスタント: 多言語チャットボット向けの言語モデルを開発および展開し、グローバル市場における顧客エンゲージメントとサポートを強化します。

結論:

Cerebras Inferenceは、AIアクセラレーションの頂点であり、ヘルスケアと製薬からエネルギーと科学計算まで、さまざまなセクターを変革します。モデルのトレーニング時間とコストを大幅に削減することで、このテクノロジーはAIへのアクセスを民主化し、あらゆる規模の組織がAIの潜在能力を最大限に活用できるようにします。今日のAIの未来に参加して、新しい可能性を開きましょう。

よくある質問:

Cerebras Inferenceを他のAI推論ソリューションと差別化するものは何ですか?

Cerebras Inferenceは、比類のない速度と費用対効果を提供し、世界で最も高速で経済的なAI推論ソリューションであり、さまざまな業界における高性能コンピューティングと複雑なAIアプリケーションに最適です。

Cerebras Inferenceは既存のAIモデルと統合できますか?

もちろんです。Cerebrasは、すぐに使用できる基盤モデルと微調整済みモデルのスイートに加えて、モデルをカスタマイズしてトレーニングするためのサービスを提供しており、特定のニーズに合わせたシームレスな統合と最適化を保証します。

Cerebras Inferenceが優れている特定の業界やユースケースはありますか?

Cerebras Inferenceは、創薬と個別化医療を加速するヘルスケアと製薬、地震処理やモンテカルロシミュレーションなどのタスクを実行するスーパーコンピューティングにおいて、計算時間を大幅に短縮します。